非结构化数据通常指没有预定义结构的数据,如图片,视频,文本等。

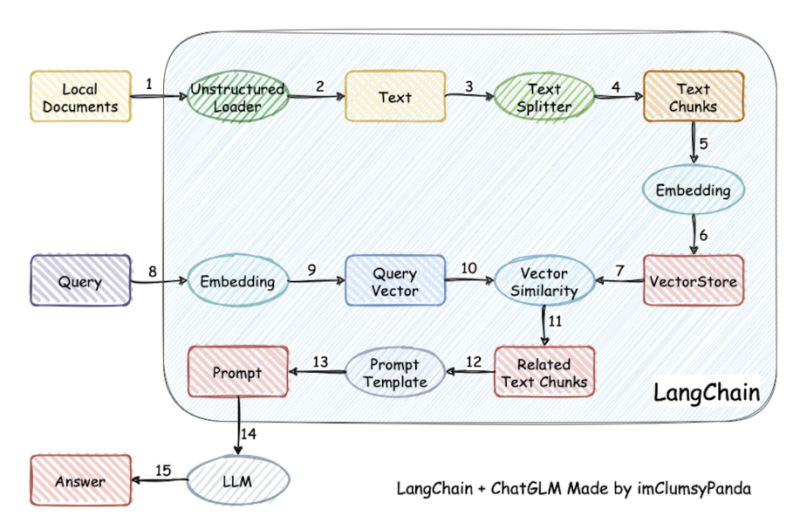

回看到过程中可选的向量数据库

用pgvector实现文本相似度检测其实相当简单

cd /tmp

git clone --branch v0.4.4 https://github.com/pgvector/pgvector.git

cd pgvector

make

make install # may need sudo复制

CREATE EXTENSION vector; 复制

from langchain.embeddings import HuggingFaceEmbeddings

embeddings = HuggingFaceEmbeddings(model_name='moka-ai/m3e-base',

model_kwargs={'device': 'cpu'})复制

import os

from langchain.vectorstores.pgvector import PGVector

PGVECTOR_CONNECTION_STRING = PGVector.connection_string_from_db_params(

driver=os.environ.get("PGVECTOR_DRIVER", "psycopg2"),

host=os.environ.get("PGVECTOR_HOST", "localhost"),

port=int(os.environ.get("PGVECTOR_PORT", "5432")),

database=os.environ.get("PGVECTOR_DATABASE", "postgres"),

user=os.environ.get("PGVECTOR_USER", "postgres"),

password=os.environ.get("PGVECTOR_PASSWORD", "123456"),

)复制

from langchain.vectorstores.pgvector import DistanceStrategy

data = [

"猫追老鼠",

"小猫捉啮齿动物",

"我喜欢火腿三明治",

"你使用的是什么embedding算法"

]

metadatas = [

{"answer":"老鼠可能被抓到"},

{"answer":"啮齿动物被抓到"},

{"answer":"火腿和三明治是不错的搭配"},

{"answer":"我使用的是m3e-base作为embedding算法,对中文的支持更好"}

]

PGVector.from_texts(texts = data,

embedding=embeddings,

collection_name="custom_qa",

connection_string=PGVECTOR_CONNECTION_STRING,

metadatas=metadatas

)复制

from langchain.docstore.document import Document

query = "猫捉老鼠"

print("="*80)

docs_with_score: list[tuple[Document, float]] = store.similarity_search_with_score(query)

for doc, score in docs_with_score:

print("Score:", score)

print(doc.page_content)

print(doc.metadata)

print("-"*80)复制

================================================================= Score: 0.04342155086519628

猫追老鼠

{'answer': '老鼠可能被抓到'}

-----------------------------------------------------------------

Score: 0.12241556104896034

小猫捉啮齿动物

{'answer': '啮齿动物被抓到'}

-----------------------------------------------------------------

Score: 0.33161097392725436

我喜欢火腿三明治

{'answer': '火腿和三明治是不错的搭配'}

-----------------------------------------------------------------

Score: 0.3587415090526611

你使用的是什么embedding算法

{'answer': '我使用的是m3e-base作为embedding算法,对中文的支持更好'}

-----------------------------------------------------------------复制

在实际使用中从向量数据库中搜索到的结果会被选出前几条,一起放到LLM中按照相关性分配权重进行归纳总结。

小 结

文章转载自瀚高数据库,如果涉嫌侵权,请发送邮件至:contact@modb.pro进行举报,并提供相关证据,一经查实,墨天轮将立刻删除相关内容。

评论

相关阅读

2025年4月中国数据库流行度排行榜:OB高分复登顶,崖山稳驭撼十强

墨天轮编辑部

2534次阅读

2025-04-09 15:33:27

数据库国产化替代深化:DBA的机遇与挑战

代晓磊

1184次阅读

2025-04-27 16:53:22

2025年3月国产数据库中标情况一览:TDSQL大单622万、GaussDB大单581万……

通讯员

855次阅读

2025-04-10 15:35:48

2025年4月国产数据库中标情况一览:4个千万元级项目,GaussDB与OceanBase大放异彩!

通讯员

676次阅读

2025-04-30 15:24:06

数据库,没有关税却有壁垒

多明戈教你玩狼人杀

583次阅读

2025-04-11 09:38:42

天津市政府数据库框采结果公布,7家数据库产品入选!

通讯员

569次阅读

2025-04-10 12:32:35

国产数据库需要扩大场景覆盖面才能在竞争中更有优势

白鳝的洞穴

546次阅读

2025-04-14 09:40:20

Hologres x 函数计算 x Qwen3,对接MCP构建企业级数据分析 Agent

阿里云大数据AI技术

489次阅读

2025-05-06 17:24:44

【活动】分享你的压箱底干货文档,三篇解锁进阶奖励!

墨天轮编辑部

485次阅读

2025-04-17 17:02:24

一页概览:Oracle GoldenGate

甲骨文云技术

464次阅读

2025-04-30 12:17:56