《Llama大模型实践指南》是Llama中文社区成员与电子工业出版社合&Broadview合作完成的

国内首创搭载AI图书助教的实体书

你只需要扫一扫书中二维码,就可以快速拥有一位可以陪你同步学习、实时答疑、实践Llama大模型的AI助教!

并且该AI助教的研发几乎用的都是本书中所讲的知识,基于Llama2大模型结合RAG实现。这本书不仅全面涵盖了Llama大模型的理论与实践,它更是将尖端的检索增强生成(RAG)技术巧妙融入,开创了搭载AI图书助教的纸质图书新纪元。

第2-3章:Llama 2大模型的实操指南,专注于Llama 2大模型的实际部署和微调过程,提供了一系列详尽的代码示例、案例分析和操作实践。

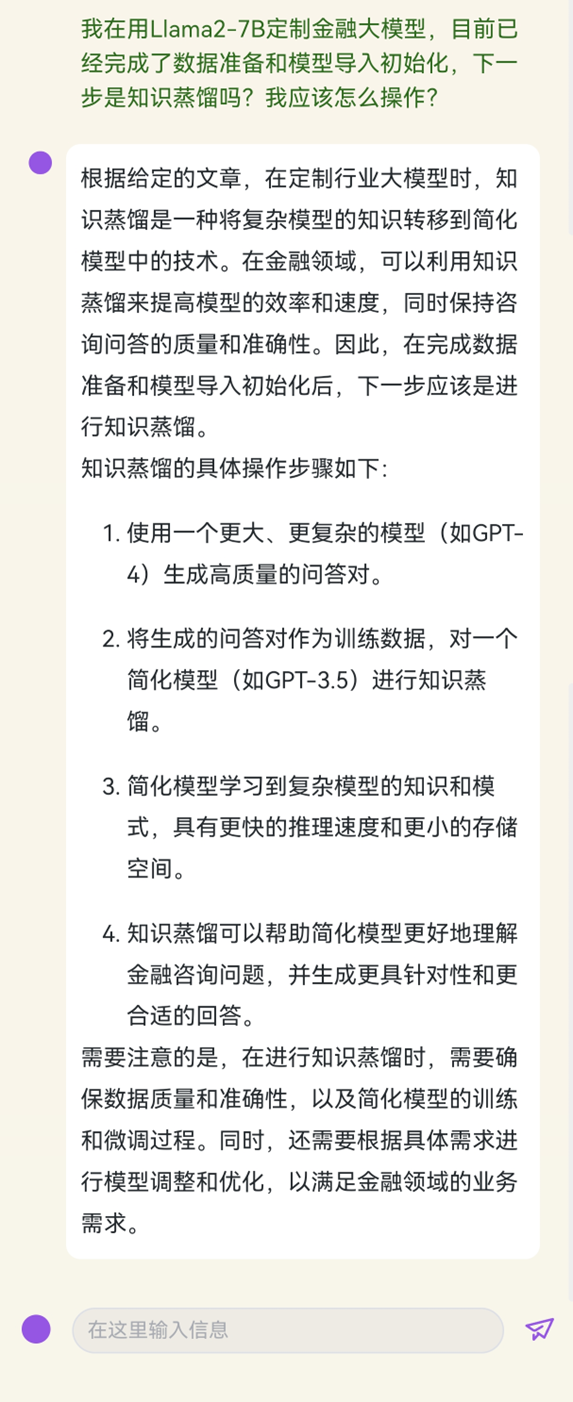

《Llama大模型实践指南》中搭载的AI图书助手,是将社区Atom大模型与RAG技术完美结合的产物。

简单扫码,即可开启与AI助手的互动之旅,对于大模型技术的任何疑问都能得到即时且专业的回答。这不仅是对传统阅读方式的一次革新,更是社区技术应用成果的生动展示。

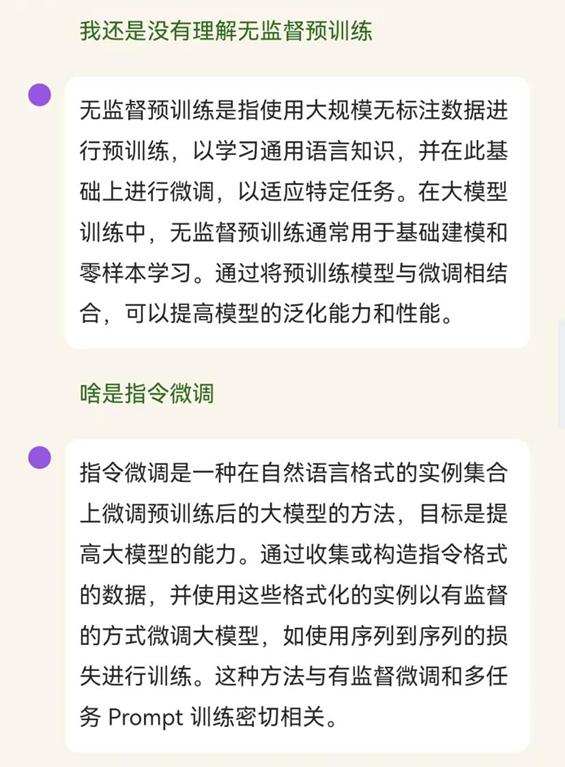

当你在阅读过程中不理解某些定义时,问一问AI助教:

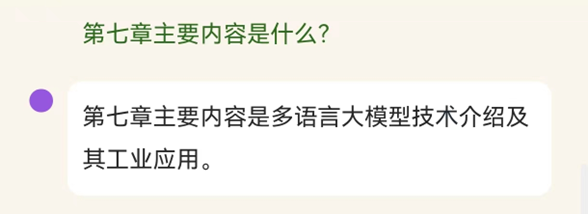

你想要快速了解某一章节内容时,问一问AI助教

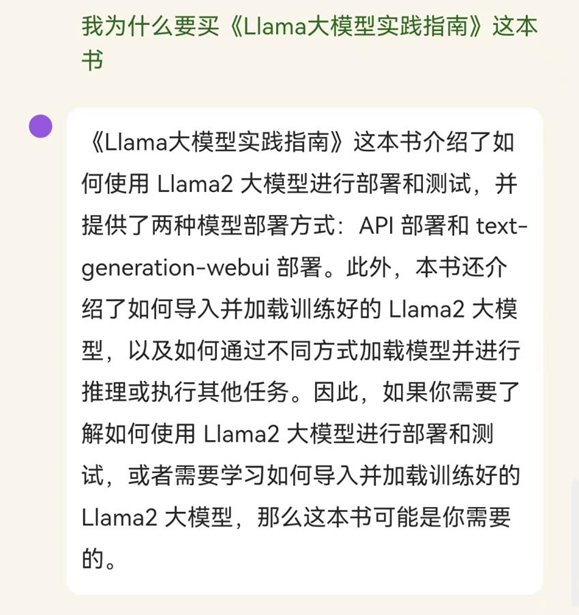

AI助教也给出了《Llama大模型实践指南》这本书的学习理由!

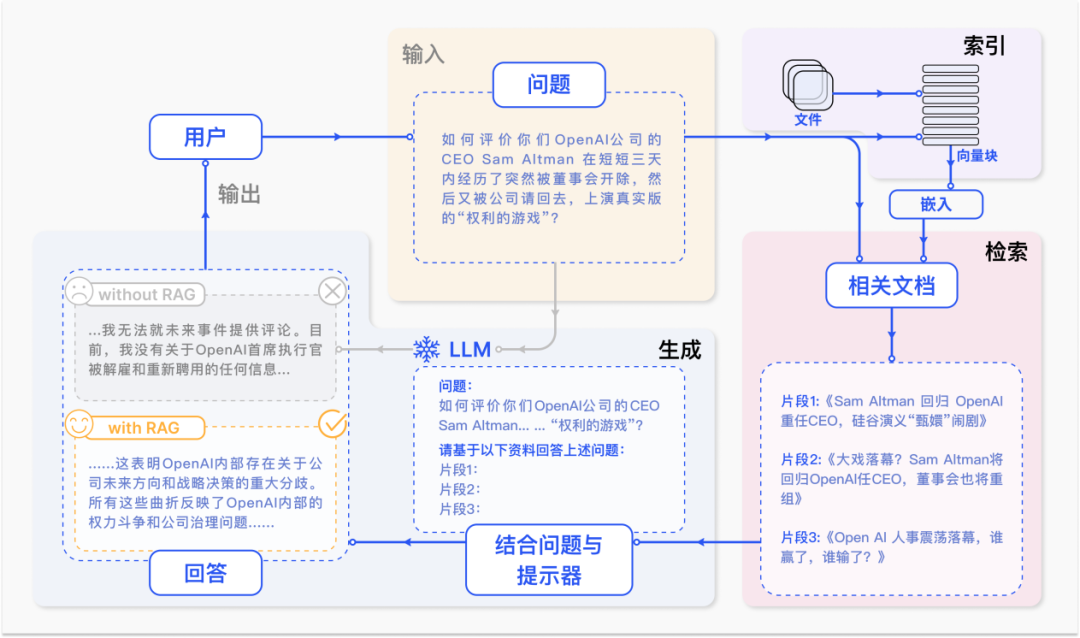

RAG(Retrieval-Augmented Generation)技术,也就是检索增强生成技术,是一个结合了两个强大概念的人工智能技术。简单来说,RAG是一种让AI模型在生成回答之前先进行信息检索的方法,让它们在回答问题时更加准确和可靠。

在传统的大型语言模型中,尽管它们非常强大,能够生成流畅的语言并处理复杂的问题,但它们有时会遇到一些问题。

例如,这些模型可能会产生不准确或误导性的回答,或者处理最新信息时效率不高,因为它们的训练数据可能是陈旧的。RAG技术通过在生成回答之前先从一个广泛的文档数据库中检索相关信息,来弥补这些不足。这样,模型不仅依赖于它已经知道的信息,还能利用最新的外部数据来提供答案。

但是,如果使用了RAG技术,模型可以先检索最新的相关新闻文章,然后结合这些信息来生成回答。

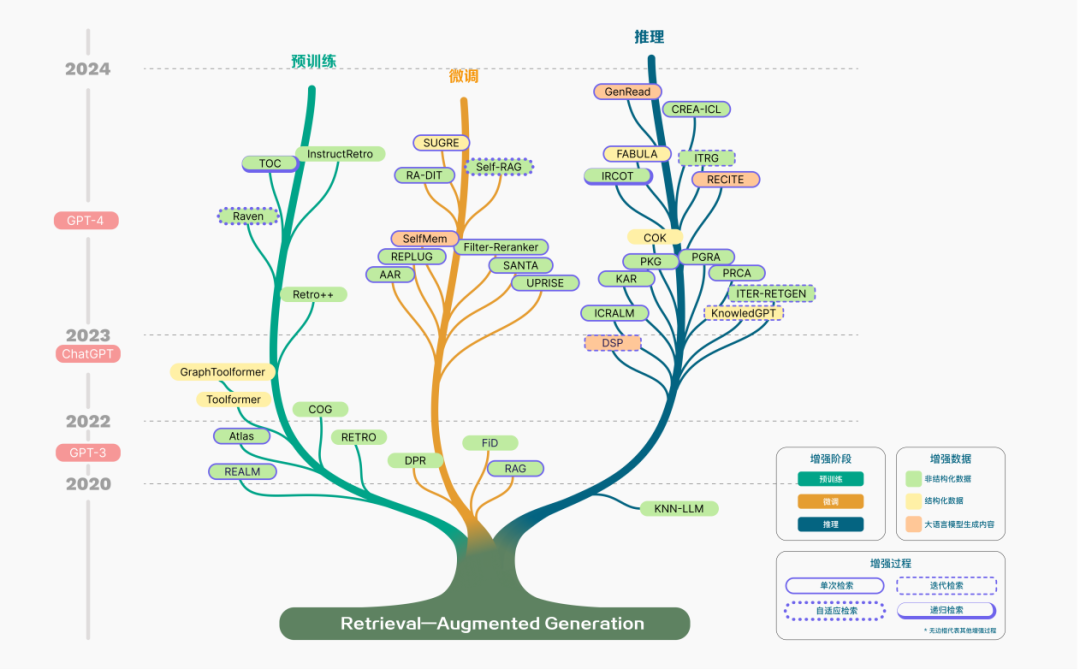

RAG技术的发展经历了几个阶段,从最初的简单实现(Naive RAG),到更高级和复杂的形式(如Advanced RAG和Modular RAG)。这些进阶形式解决了早期版本的一些问题,比如提高了检索的准确性和生成回答的质量。

致敬每一位创造奇迹的社区成员:

衷心感谢每一位社区成员对这本书的贡献。正是因为有了你们的智慧火花、热情投入和无限创造力,这本书才得以成就其非凡价值。

特别感谢:

张俊祺、曲东奇、张正、占冰强、董倩倩、涂标松、李文韬、蔡家坡、胡晓付林、杨沐晨、项滔、曹方咏峥。(排名不分先后)

如果你也想在社区未来的技术分享以及出版物上做出贡献,或者出版社的朋友想为纸质书添加AI图书助教,都欢迎联系社区!

开启你的大模型之旅

📚 Llama中文社区正举办一场特别的送书活动,旨在将这本充满智慧的书籍分享给更多热爱AI和大模型的朋友们。参与方式非常简单:

1️⃣ 将这篇文章+您对AI技术的热情和思考分享到朋友圈。

2️⃣ 收集50个点赞。

完成后截图私信Llama中文社区公众号,我们会抽取20位幸运同学赠送《Llama大模型实践指南》(包邮)。

这本书是对大模型技术的全面剖析,涵盖了从基础理论到实际应用的每一个细节,对于任何渴望深入了解AI领域的人来说,都是一份宝贵的资源。

🌈 把握这个机会,让我们共同探索人工智能的奥秘,揭开大模型的神秘面纱。让您的朋友圈成为知识的传播地,一起进入这个激动人心的AI新世界吧!🚀📖

社区官网:https://llama.family

商务合作添加微信号: vitamaxmin