目录

1.随机森林回归原理

2.特点

3.结果

4.优缺点

编辑:

校对:

版本:

WangXin

WangXin

python3

随机森林回归原理

随机森林的原理是,它对原始的数据集进行多次有放回抽样,在其中的每次抽样中,抽取和样本量同样多的观测值,在有放回这个前提下,则每次抽样都有一些观测值不能被抽到,一些观测值会被重复抽到。进而得到很多不同的数据集,然后使用之前我们了解过的决策树知识,对每一个数据集建立一颗决策树,从而产生大量决策树。就好比这些树组成了一个森林。

随机森林回归树,cart树是回归树,采用的原则是最小均方差。即对于任意划分特征A,对应的任意划分点s两边划分成的数据集D1和D2,求出使D1和D2各自集合的均方差最小,同时D1和D2的均方差之和最小所对应的特征和特征值划分点。

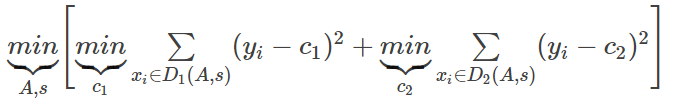

表达式为:

其中,c1为D1数据集的样本输出均值,c2为D2数据集的样本输出均值。

特点

随机森林中每棵树的每个节点,拆分变量不是由所有变量参与竞争,而是由随机挑选的少数变量进行竞争,且每棵树都是长到底的,拆分变量候选者的数目限制可以避免由于强势变量主宰而忽略的数据关系中的细节,从而大大提高了模型对数据的代表性。

结果

随机森林的结果是所有树的结果的平均,即给予一个新的观测值,需要通过许多棵树得到许多个结果,再对这些预测结果做平均做为最终结果。

优缺点

优点:

(1)它在当前很多数据集上,相对其他算法有着很大优势,表现良好。

(2)它能够处理很高维度的数据,并且不用做特征选择。

缺点:

随机森林已经被证明在某些噪音较大的分类或回归问题上会过拟合。

理解编程语言,探索数据奥秘

每日练习|干货分享|新闻资讯|公益平台。

每天学习一点点,你将会见到全新的自己。

长按识别二维码关注

文章转载自云南高校数据化运营管理工程中心,如果涉嫌侵权,请发送邮件至:contact@modb.pro进行举报,并提供相关证据,一经查实,墨天轮将立刻删除相关内容。