zhizhi会不会有那么一天,生活可以简单到每天清早踏上一辆载着鲜花的脚踏车,微笑着穿过窄窄的街巷,为爱花的人送去芬芳,为需要知识的你送去帮助。

简介

在企业中,一些重要的数据一般存储在硬盘上,虽然硬盘本身的性能也在不断提高,但是无论硬盘的存取速度有多快,企业所追寻的首先是可靠性,然后才是效率。如果数据面临丢失的风险.再好的硬件也无法挽回企业的损失。加之近几年云计算的出现,对存储提出了更高的要求。而分布式存储逐渐被人们所接受,它具有更好的性能、高扩展性以及可靠性。大部分分布式解决方案都是通过元服务器存放目录结构等元数据,元数据服务器提供了整个分布式存储的索引工作。但是一旦元数据服务器损坏,整个分布式存储将无法工作。本章介绍一款无元服务器的分布式存储解决方案,GlusterFS。

本章重点

部署GlusterFS

理解GlusterFS工作原理

理论讲解

一.GlusterFS概述

1.GlusterFS简介

GlusterFS是一个开源的分布式文件系统,同时也是Scale-Out 存储解决方案Gluster的核心,在存储数据方面具有强大的横向扩展能力,通过扩展不同的节点可以支持数PB级别的存储容量。

GlusterFS借助TCP/IP或InfiniBand RDMA网络将分散的存储资源汇聚在一起,统一提供存储服务,并使用单一全局命名空间来管理数据。GlusterFS基于可堆叠的用户空间以及无元的设计,可为各种不同的数据负载提供优异的性能。

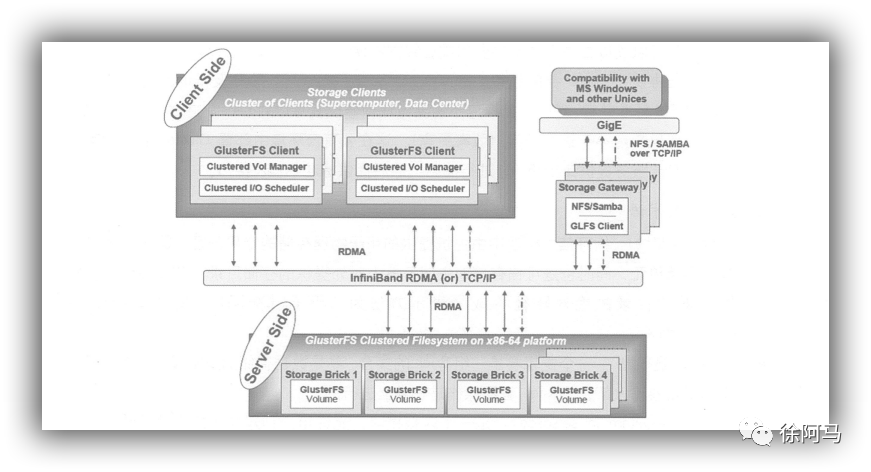

GlusterFS主要由存储服务器(Brick Server)、客户端及NFS/Samba存储网关(可选,根据需要选择使用)组成,如图所示。GlusterFS架构中最大的设计特点是没有元数据服务器组件,这有助于提升整个系统的性能、可靠性和稳定性。传统的分布式文件系统大多通过元服务器来存储元数据,元数据包含存储节点上的目录信息、目录结构等,这样的设计在浏览目录时效率非常高,但是也存在一些缺陷,如单点故障,一旦元数据服务器出现故障,即使节点具备再高的冗余性,整个存储系统也将崩溃,而GlusterFS分布式文件系统是基于无元服务器的设计,数据横向扩展能力强具备较高的可靠性及存储效率。GlusterFS支持TCP/IP和InfiniBandRDMA高速网络互联,客户端可通过原生GlusterFS协议访问数据,其他没有运行GlusterFS客户端的终端可通过NFS/CFS标准协议通过存储网关访问数据。

2.GlusterFS的特点

扩展性和高性能。GlusterFS利用双重特性来提供高容量存储解决方案。

◆Scale-Out架构通过增加存储节点的方式来提高存储容量和性能(磁盘、计算和l/O资源都可以独立增加),支持10GbE和InfiniBand等高速网络互联。

◆Gluster 弹性哈希(Elastic Hash)解决了GlusterFS对元数据服务器的依赖,GlusterFS采用弹性哈希算法在存储池中定位数据,放弃了传统的通过元数据服务器定位数据。GlusterFS中可以智能地定位任意数据分片(将数据分片存储在不同节点上),不需要查看索引或者向元数据服务器查询。这种设计机制实现了存储的横向扩展,改善了单点故障及性能瓶颈,真正实现了并行化数据访问。

高可用性,GlusterFS通过配置某些类型的存储卷,可以对文件进行自动复制(类似于RAD1),即使某个节点出现故障,也不影响数据的访问。当数据出现不一致时,自动修复功能能够把数据恢复到正确的状态.数据的修复是以增量的方式在后台执行.不会占用太多系统资源。GlusterFS可以支持所有的存储,因为它没有设计自己的私有数据文件格式,而是采用操作系统中标准的磁盘文件系统(如EXT3、XFS等)来存储文件,数据可以使用传统的访问磁盘的方式被访问。

全局统一命名空间。全局统一命名空间将所有的存储资源聚集成一个单一的虚拟存储池,对用户和应用屏蔽了物理存储信息。存储资源(类似于LVM)可以根据生产环境中的需要进行弹性扩展或收缩。在多节点场景中,全局统一命名空间还可以基于不同节点做负载均衡,大大提高了存取效率。

弹性卷管理。GlusterFS通过将数据储存在逻辑卷中,逻辑卷从逻辑存储池进行独立逻辑划分。逻辑存储池可以在线进行增加和移除,不会导致业务中断。逻辑卷可以根据需求在线

增长和缩减,并可以在多个节点中负载均衡。文件系统配置更改也可以实时在线进行并应用,从而可以适应工作负载条件变化或在线性能调优。

基于标准协议。Gluster 存储服务支持NFS、CFS、HTTP、FTP、SMB及Gluster原生协议,完全与POSIX标准兼容。现有应用程序不需要做任何修改就可以对Gluster中的数据进行访问。也可以使用专用APl进行访问(效率更高),这在公有云环境中部署Gluster 时非常有用Gluster对云服务提供商专用API进行抽象,然后提供标准POSX接口。

3.GlusterFS术语

Brick(存储块):指可信主机池中由主机提供的用于物理存储的专用分区,是GlusterFS中的基本存储单元,同时也是可信存储池中服务器上对外提供的存储目录。存储目录的格式由服务器和目录的绝对路径构成,表示方法为SERVER:EXPORT,如192.168.1.4:/data/mydir/。

Volume(逻辑卷):一个逻辑卷是一组Brick的集合。卷是数据存储的逻辑设备,类似于LVM中的逻辑卷。大部分Gluster管理操作是在卷上进行的。

FUSE(Filesystem inUserspace):是一个内核模块,允许用户创建自己的文件系统,无须修改内核代码。

VFS:内核空间对用户空间提供的访问磁盘的接口。

Glusterd(后台管理进程):在存储群集中的每个节点上都要运行。

4.模块化堆栈式架构

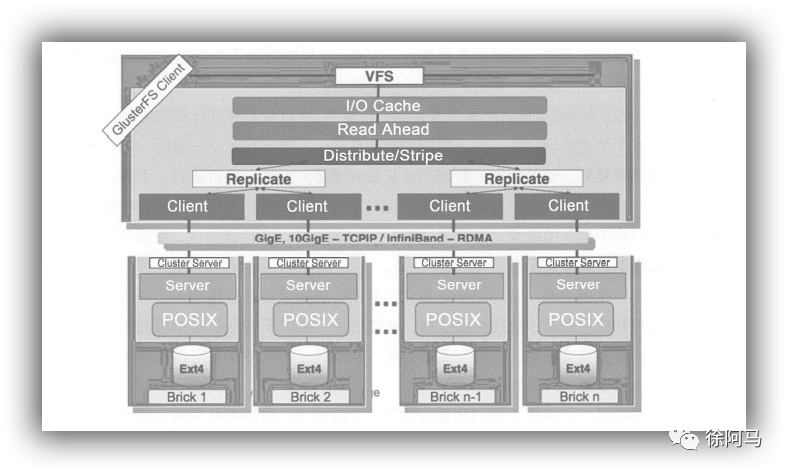

如图所示,GlusterFS采用模块化,堆栈式的架构,可以根据需求配置定制化的应用环境,如大文件存储、海量小文件存储、云存储、多传输协议应用等。通过对模块进行各种组合,即可实现复杂的功能。例如.Replicate 模块可实现RAID1.Stripe模块可实现RADO,通过两者的组合可实现RAD10和RAID01,同时获得更高的性能及可靠性。

GlusterFS是模块化堆栈式的架构设计,如上图所示。模块称为Translator,是GlusterFS提供的一种强大机制,借助这种良好定义的接口可以高效简便地扩展文件系统的功能。

(1)服务端与客户端的设计高度模块化的同时模块接口是兼容的,同一个translator可同时在客户端和服务器加载。

(2)GlusterFS中所有的功能都是通过translator实现的,其中客户端要比服务端更复杂。所以功能的重点主要集中在客户端上。

二.GlusterFS的工作原理

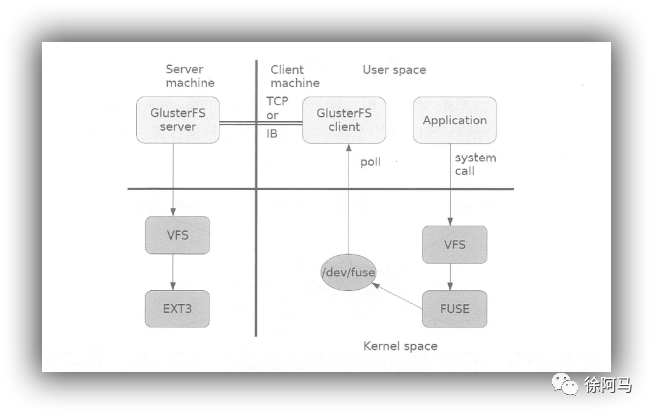

1.GlusterFS的工作流程GlusterFS数据访问流程如图所示。

如图所示是GlusterFS数据访问的一个概要图。

(1)客户端或应用程序通过GlusterFS的挂载点访问数据。

(2)Linux系统内核通过VFS APl收到请求并处理。

(3)VFS将数据递交给FUSE内核文件系统,并向系统注册一个实际的文件系统FUSE,而FUSE文件系统则是将数据通过/dev/fuse 设备文件递交给了GlusterFS client 端,可以将FUSE文件系统理解为一个代理。

(4)GlusterFS client 收到数据后,client 根据配置文件对数据进行处理。

(5)经过GlusterFS client处理后,通过网络将数据传递至远端的GlusterFS Server,并且将数据写入服务器存储设备。

2.弹性HASH算法

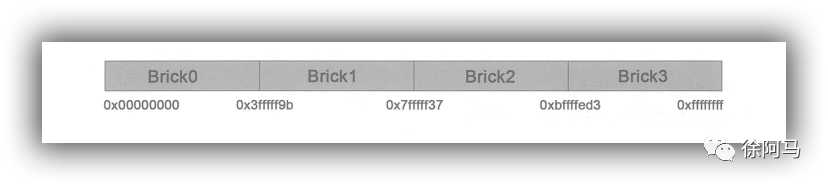

弹性HASH算法使用Davies-Meyer 算法,通过HASH算法得到一个32位的整数范围,假设逻辑

卷中有N个存储单位Brick,则32位的整数范围将被划分为N个连续的子空间,每个空间对应一个Brick。当用户或应用程序访问某一个命名空间时,通过对该命名空间计算HASH值,根据该HASH值所对应的32位整数空间定位数据所在的Brick。弹性HASH算法的优点表现如下。

保证数据平均分布在每个Brick中。

解决了对元数据服务器的依赖,进而解决了单点故障及访问瓶颈。

现在我们假设创建了一个包含四个Brick节点的GlusterFS卷,在服务端的Brick 挂载目录会给四个Brick平均分配2”的区间的范围空间,GlusterFS hash分布区间是保存在目录上而不是根据机器去分布区间。如图13.4所示,Brick*表示一个目录。分布区间保存在每个Brick 挂载点目录的扩展属性上。

在卷中创建四个文件,分别是test-file1、test-file2、test-file3、test-file4.在访问文件时,通过快速Hash函数计算出对应的HASH值(2“范围的数值),然后根据计算出来的HASH值所对应的子空间散列到服务器的Brick上,如图所示。

三,GlusterFS的卷类型

GlusterFS支持七种卷,即分布式卷、条带卷、复制卷、分布式条带卷、分布式复制卷,条带复制卷和分布式条带复制卷,这七种卷可以满足不同应用对高性能、高可用的需求。

基本卷:

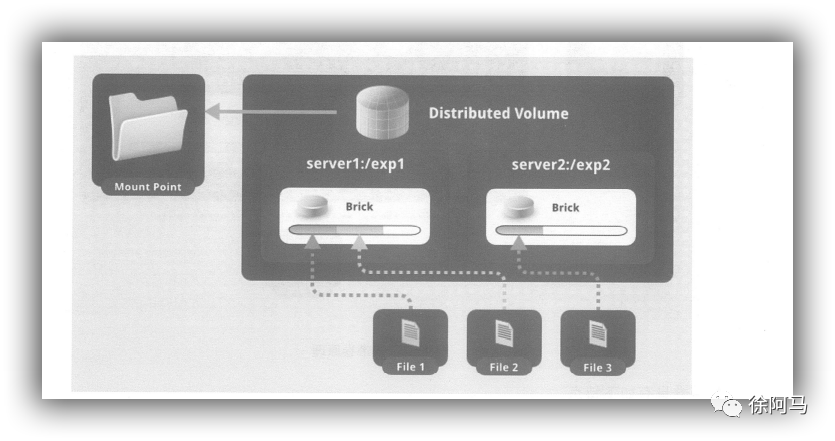

分布式卷(Distribute volume):文件通过HASH算法分布到所有Brick Server上,这种卷是Glusterf 的基础;以文件为单位根据HASH算法散列到不同的Brick,其实只是扩大了磁盘空间,如果有一块磁盘损坏,数据也将丢失,属于文件级的RAID0.不具有容错能力。

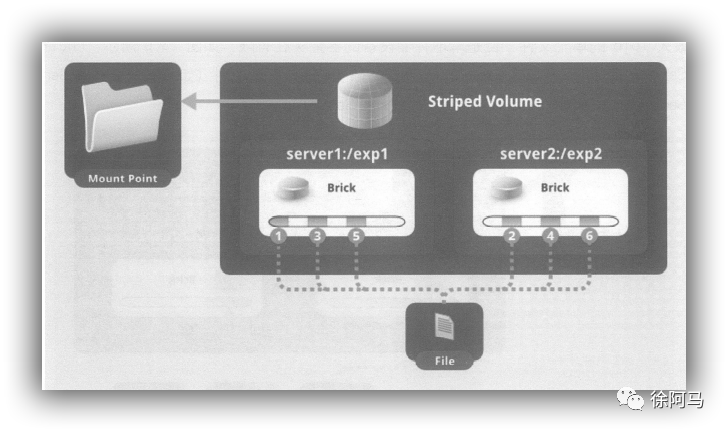

条带卷(Stripe volume):类似RAIDO,文件被分成数据块并以轮询的方式分布到多个Brick Server上,文件存储以数据块为单位,支持大文件存储,文件越大,读取效率越高。

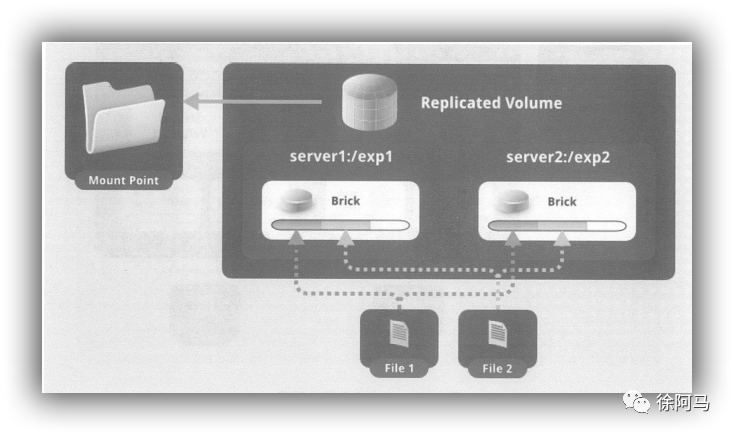

复制卷(Replica volume):将文件同步到多个Brick上,使其具备多个文件副本,属于文件级RAID1,具有容错能力。因为数据分散在多个Brick中,所以读性能得到很大提升,但写性能下降。

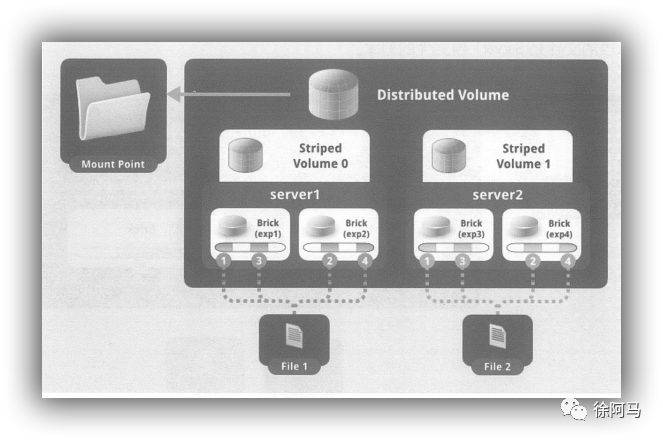

分布式条带卷(Distribute Stripe volume):Brick Server 数量是条带数(数据块分布的Brick数量)的倍数,兼具分布式卷和条带卷的特点。

分布式复制卷(Distribute Replica volume):Brick Server 数量是镜像数(数据副本数量)的倍数,兼具分布式卷和复制卷的特点。

条带复制卷(Stripe Replica volume):类似RAD10,同时具有条带卷和复制卷的特点。

分布式条带复制卷(Distribute Stripe Replicavolurme):三种基本卷的复合卷,通常用于类Map Reduce应用。

下面介绍几种重要的卷类型。

下面介绍几种重要的卷类型:

1.分布式卷

分布式卷是GlusterFS的默认卷,在创建卷时,默认选项是创建分布式卷。在该模式下,并没有对文件进行分块处理,文件直接存储在某个Server节点上。直接使用本地文件系统进行文件存储,大部分Linux命令和工具可以继续正常使用。需要通过扩展文件属性保存HASH值,目前支持的底层文件系统有ext3.ext4、ZFS、XFS等。

由于使用本地文件系统,所以存取效率并没有提高,反而会因为网络通信的原因而有所降低;另外支持超大型文件也会有一定的难度,因为分布式卷不会对文件进行分块处理。虽然ext4已经可以支持最大16TB的单个文件,但是本地存储设备的容量实在有限。如图所示,File1和File2存放在Server1,而File3存放在Server2.文件都是随机存储,一个文件(如File1)要么在Server1上,要么在Server2上,不能分块同时存放在Server1和Server2上。

分布式卷具有如下特点:

文件分布在不同的服务器,不具备冗余性。

更容易且廉价地扩展卷的大小。

单点故障会造成数据丢失。

依赖底层的数据保护。

2.条带卷

Stripe模式相当于RAID0,在该模式下,根据偏移量将文件分成N块(N个条带节点),轮询地存储在每个Brick Server节点。节点把每个数据块都作为普通文件存入本地文件系统中,通过扩展属性记录总块数(Stripe-count)和每块的序号(Stripe-index)。在配置时指定的条带数必须等于卷中Brick所包含的存储服务器数,在存储大文件时,性能尤为突出,但是不具备冗余性。

将文件存放在不同服务器里,如图所示,File被分割为6段,1、3、5放在Server1,2、4、6放在Server2。

条带卷具有如下特点。

数据被分割成更小块分布到块服务器群中的不同条带区。

分布减少了负载且更小的文件加速了存取的速度。

没有数据冗余。

3.复制卷

复制模式,也称为AFR(AutoFile Replication),相当于RAID1,即同一文件保存一份或多份副本,每个节点上保存相同的内容和目录结构。复制模式因为要保存副本,所以磁盘利用率较低,如果多个节点上的存储空间不一致,那么将按照木桶效应取最低节点的容量作为该卷的总容量。在配置复制卷时,复制数必须等于卷中Brick所包含的存储服务器数,复制卷具备冗余性,即使一个节点损坏,也不影响数据的正常使用。

将文件存放在服务器里,如图所示,File1 同时存在Server1和Server2,File2也是如此,相当于Server2中的文件是Server1中文件的副本。

复制卷具有如下特点。

卷中所有的服务器均保存一个完整的副本。

卷的副本数量可由客户创建的时候决定。

至少有两个块服务器或更多服务器。

具备冗余性。

4.分布式条带卷

分布式条带卷兼顾分布式卷和条带卷的功能,主要用于大文件访问处理,创建一个分布式条带卷最少需要4台服务器。

如图所示,File1和File2通过分布式卷的功能分别定位到Server1和Server2。在Server1中Filel 被分割成4段,其中1、3在Server1中的exp1目录中,2.4在Server1中的exp2日录中,在Server2中,File2也被分割成4段,其中1、3在Server2中的exp3目录中,2.4在Server2中的exp4目录中。

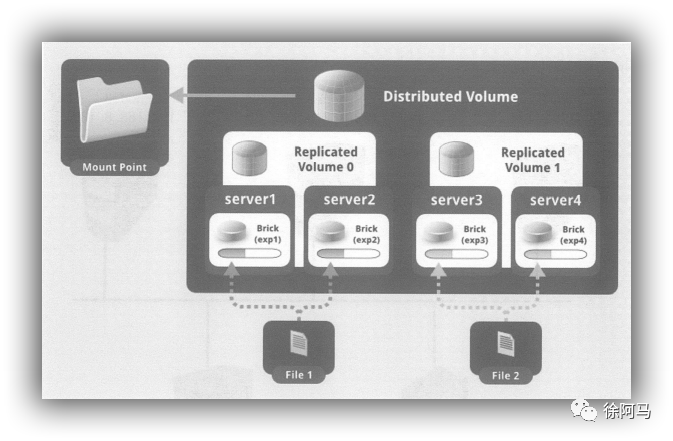

5.分布式复制卷

分布式复制卷兼顾分布式卷和复制卷的功能,主要用于需要冗余的情况下。如图所示,File1和File2通过分布式卷的功能分别定位到Server1和Server2。在存放File1时,File1根据复制卷的特性,将存在两个相同的副本,分别是Server1中的exp1目录和Server2中的exp2目录。在存放File2时,File2根据复制卷的特性,也将存在两个相同的副本,分别是Server3中的exp3目录和Server4中的exp4目录。

四, GlusterFS部署

部署群集环境

| 主机名 | IP地址 | 挂载磁盘 | 挂载点 |

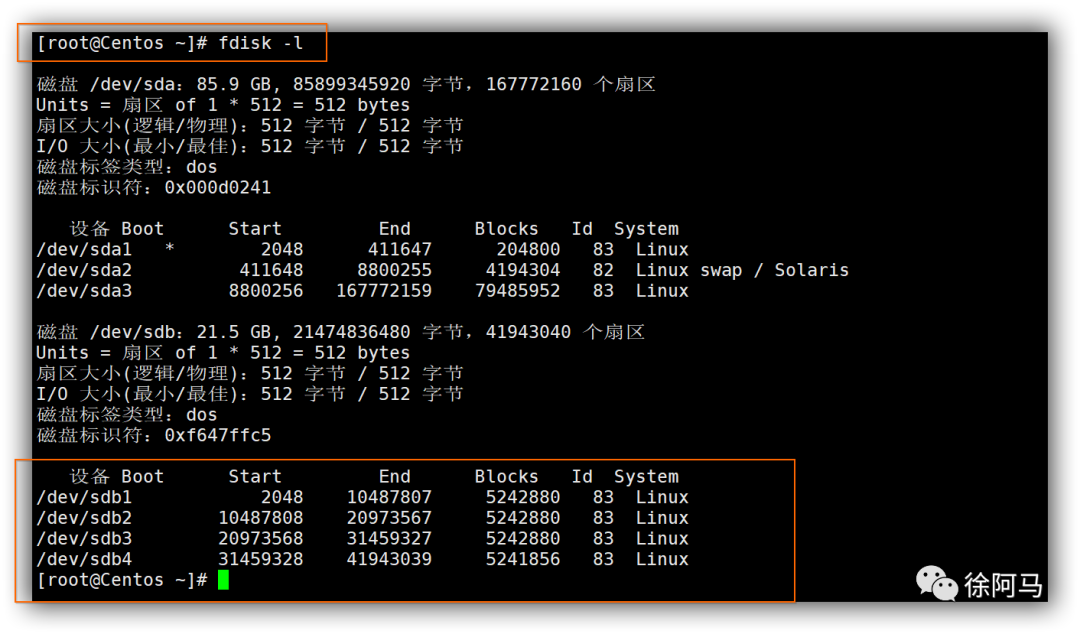

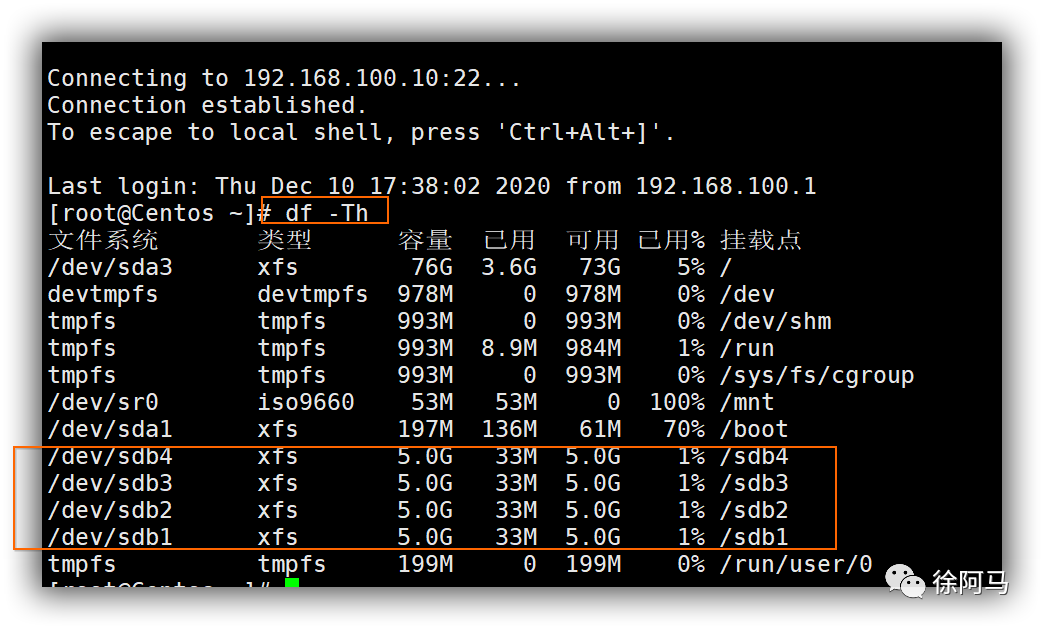

| centos01 | 192.168.100.10 | /dev/sdb1(5G) /dev/sdb2(5G) /dev/sdb3(5G) /dev/sdb4(5G) | /sdb1 /sdb2 /sdb3 /sdb4 |

| centos02 | 192.168.100.20 | /dev/sdb1(5G) /dev/sdb2(5G) /dev/sdb3(5G) /dev/sdb4(5G) | /sdb1 /sdb2 /sdb3 /sdb4 |

centos03 | 192.168.100.30 | /dev/sdb1(5G) /dev/sdb2(5G) /dev/sdb3(5G) /dev/sdb4(5G) | /sdb1 /sdb2 /sdb3 /sdb4 |

| centos04 | 192.168.100.40 | /dev/sdb1(5G) /dev/sdb2(5G) /dev/sdb3(5G) /dev/sdb4(5G) | /sdb1 /sdb2 /sdb3 /sdb4 |

| centos05(客户端) | 192.168.100.50 |

1.准备环境

在所有节点上执行以下操作。

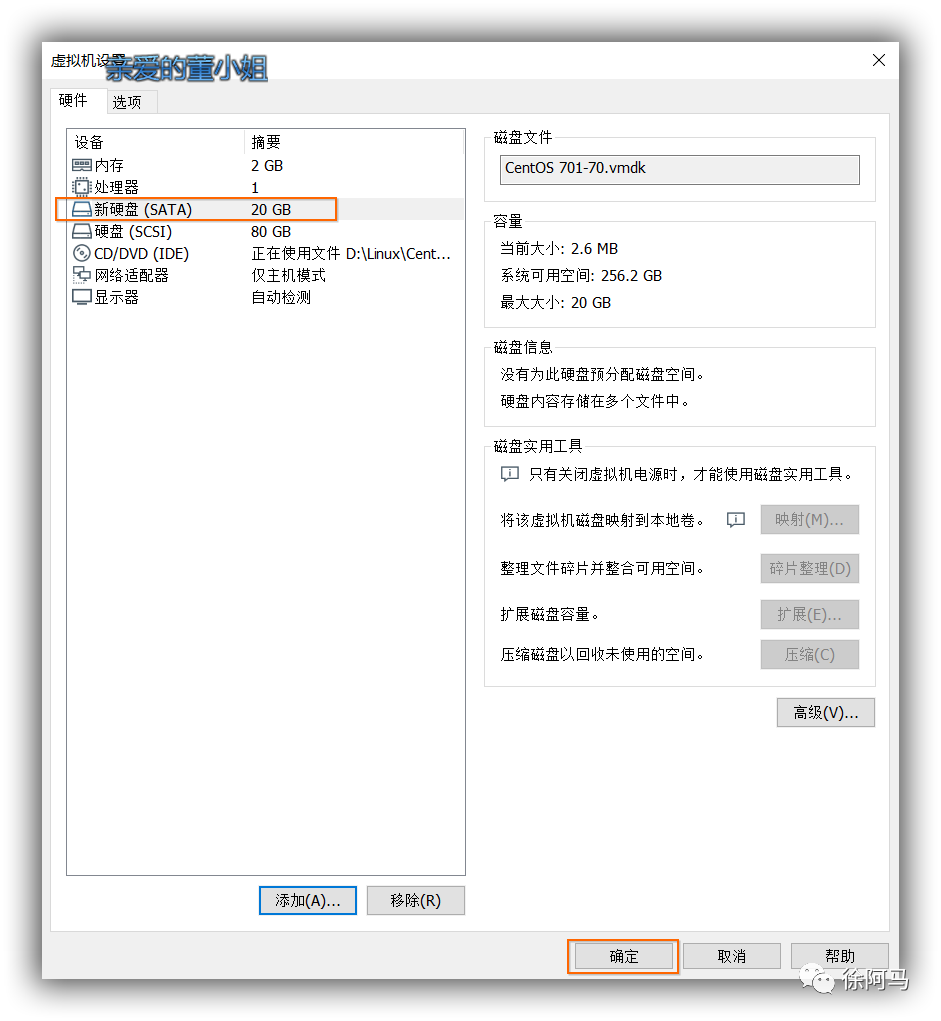

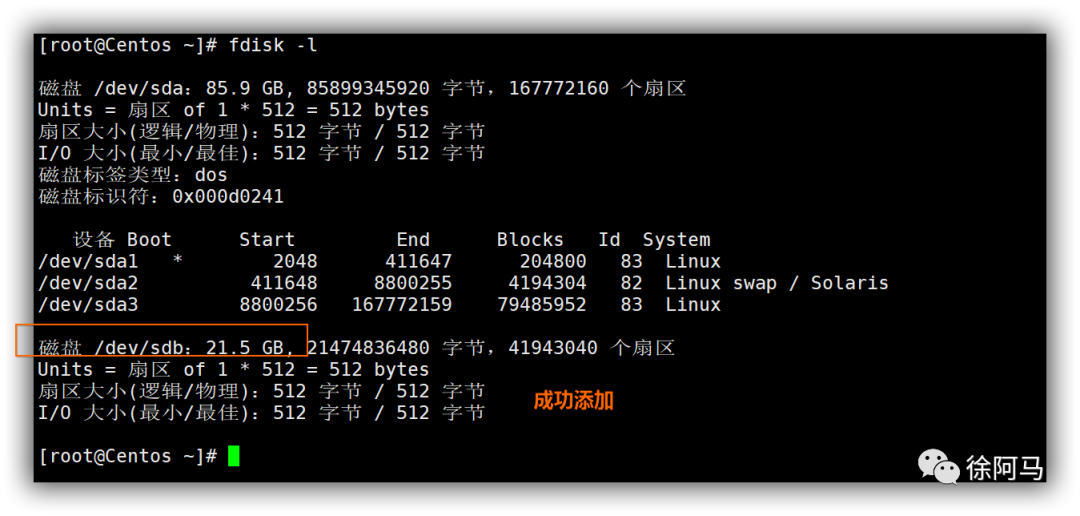

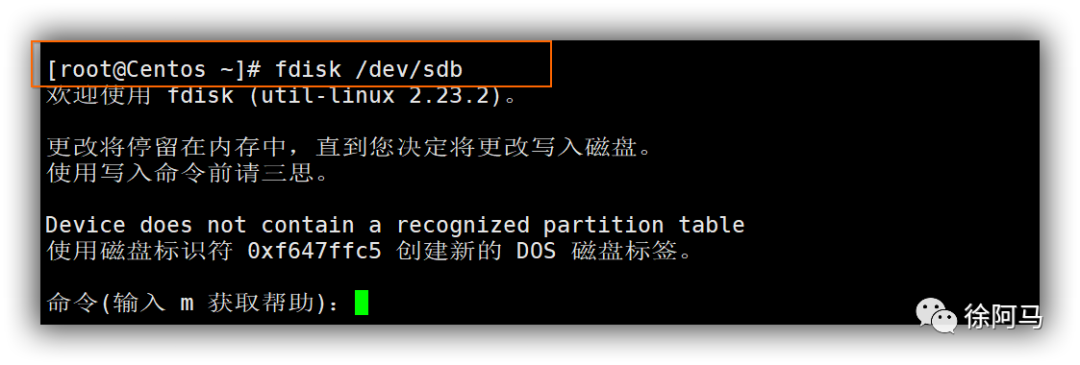

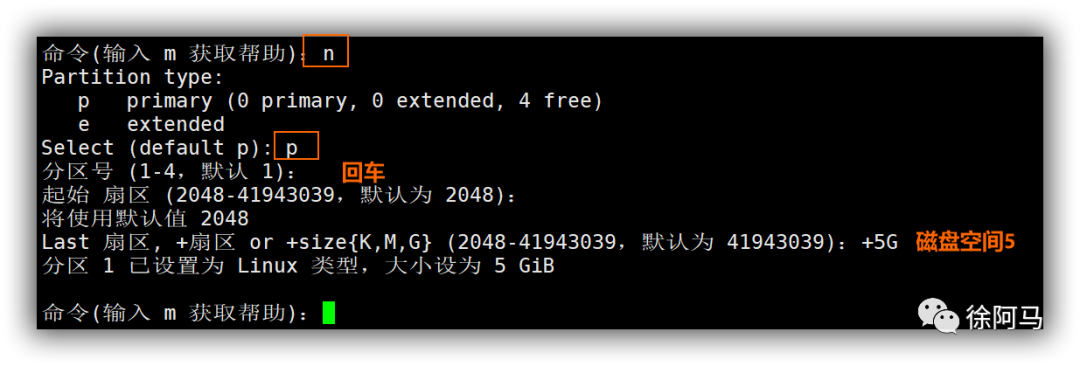

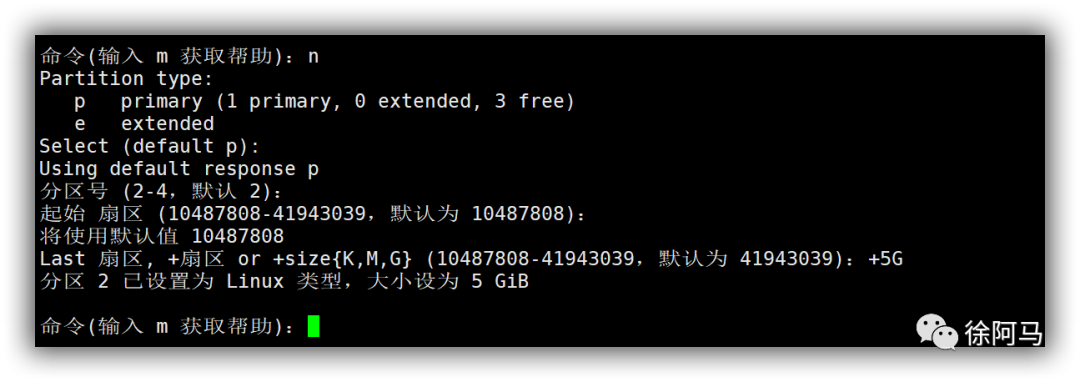

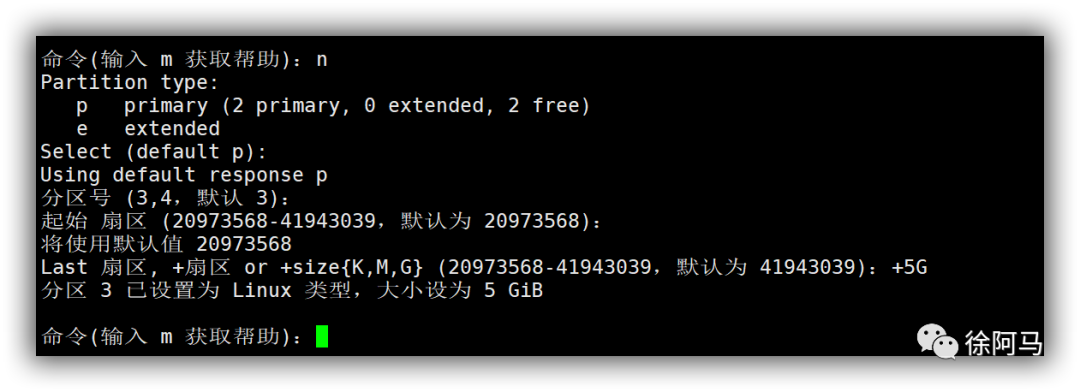

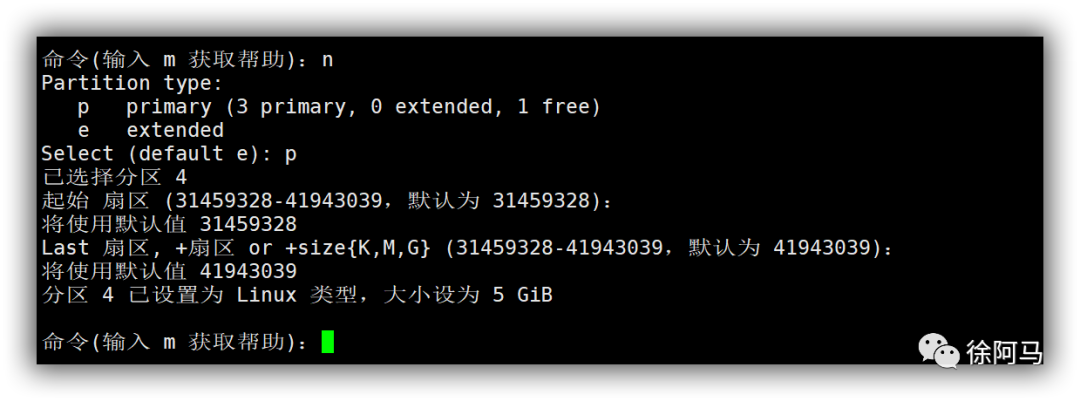

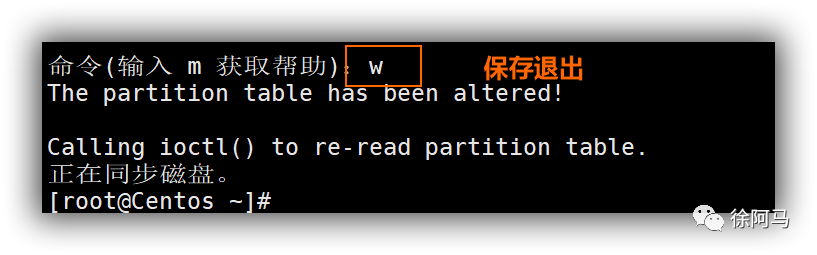

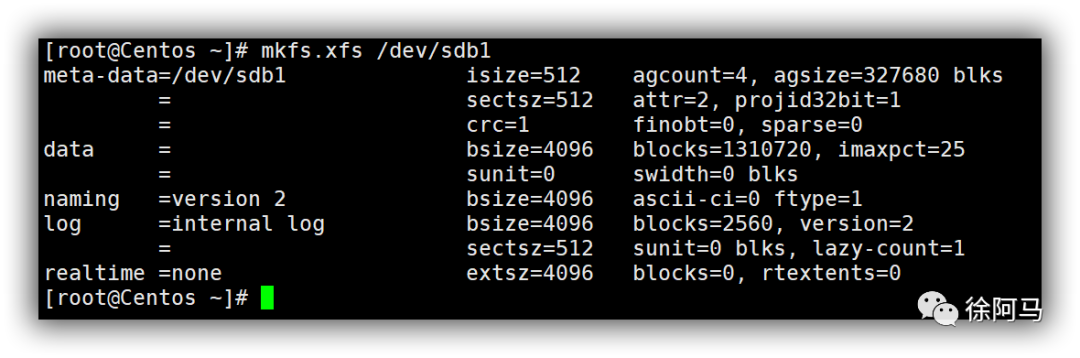

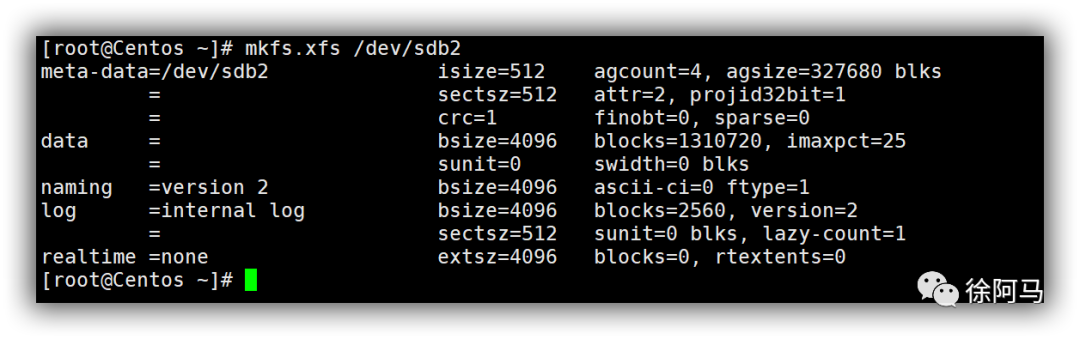

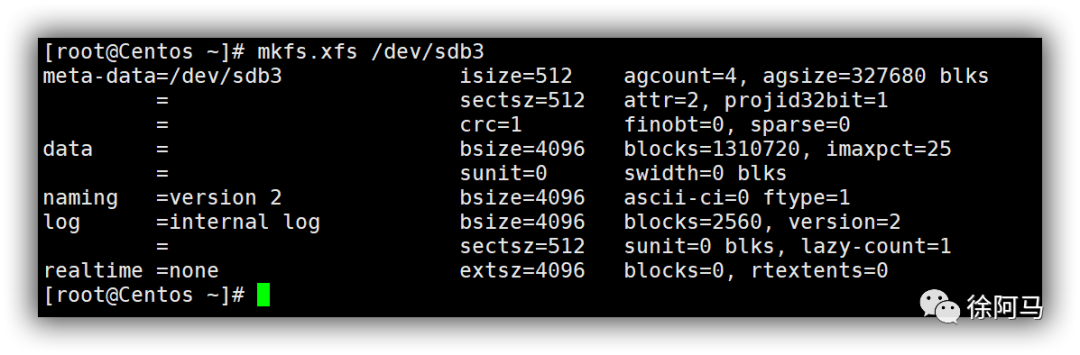

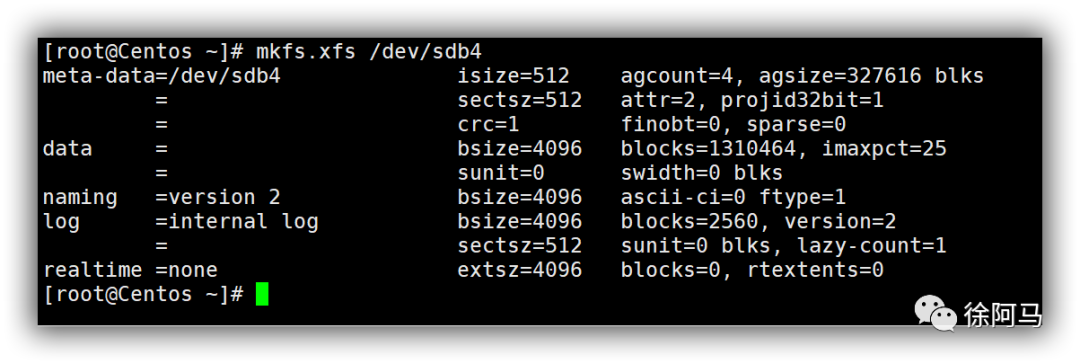

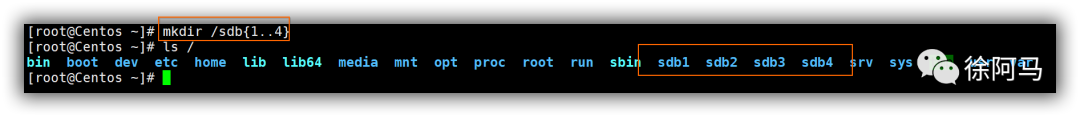

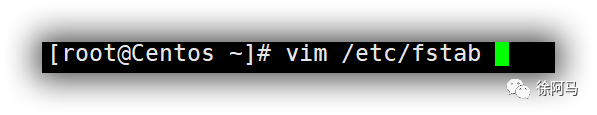

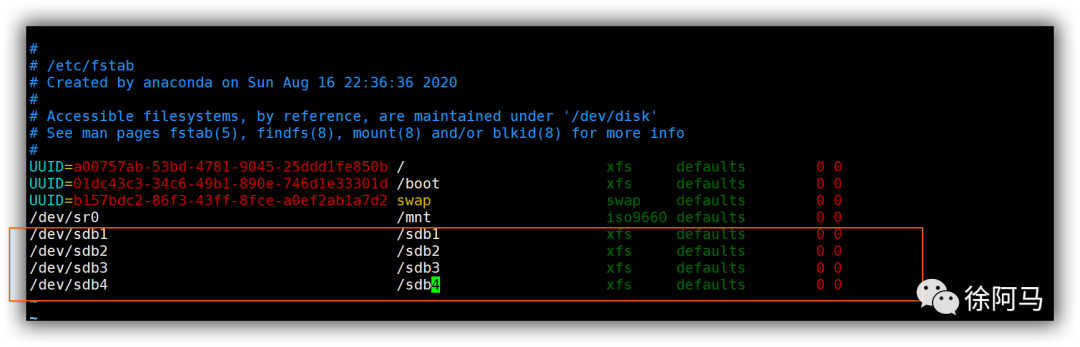

开启4台虚拟机,根据表添加磁盘,通过fdlisk分区,mkfs格式化,创建相应的挂载目录,并将格式化的磁盘挂载到相应的目录中,最后修改/etc/fstab配置文件,这里以centos01为例(一路如图)

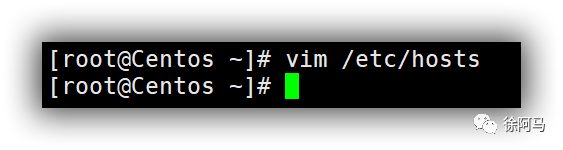

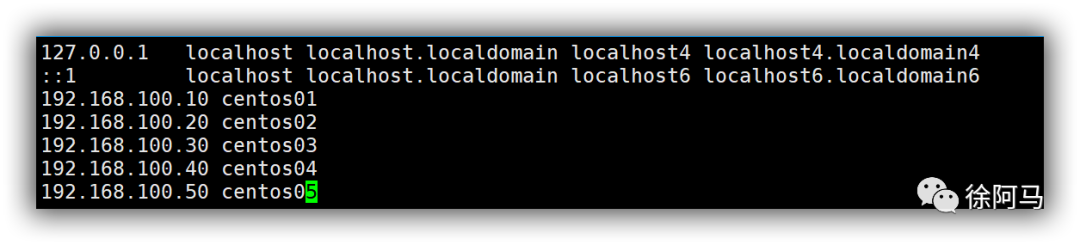

2.修改主机hosts文件

这里以centos01为例

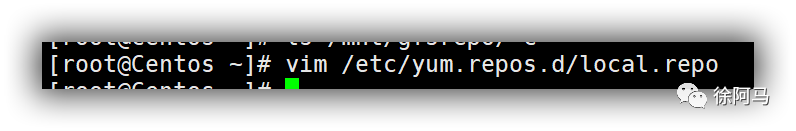

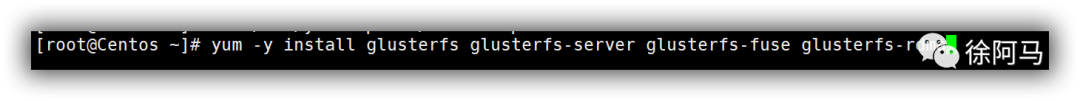

4.安装软件

复制提供的文件包gfsrepo(文件夹)到每个节点上,删除/etc/yum.repo.d/下面的所有仓库文件,并重新创建一个仓库文件指向gfsrepo目录(绝对路径),执行以下命令安装所需软件。

在所有节点上做如下操作:

如果实验环境是可以访问互联网环境的,也可以直接指向互联网仓库。

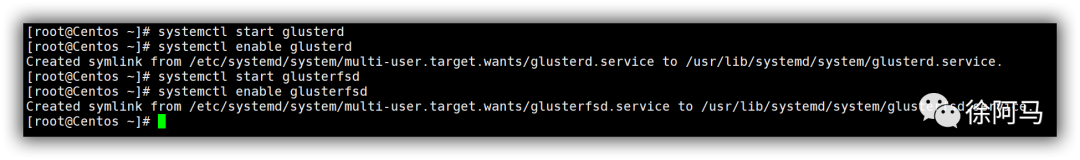

5.启动GlusterFS

在所有节点上执行以下操作:

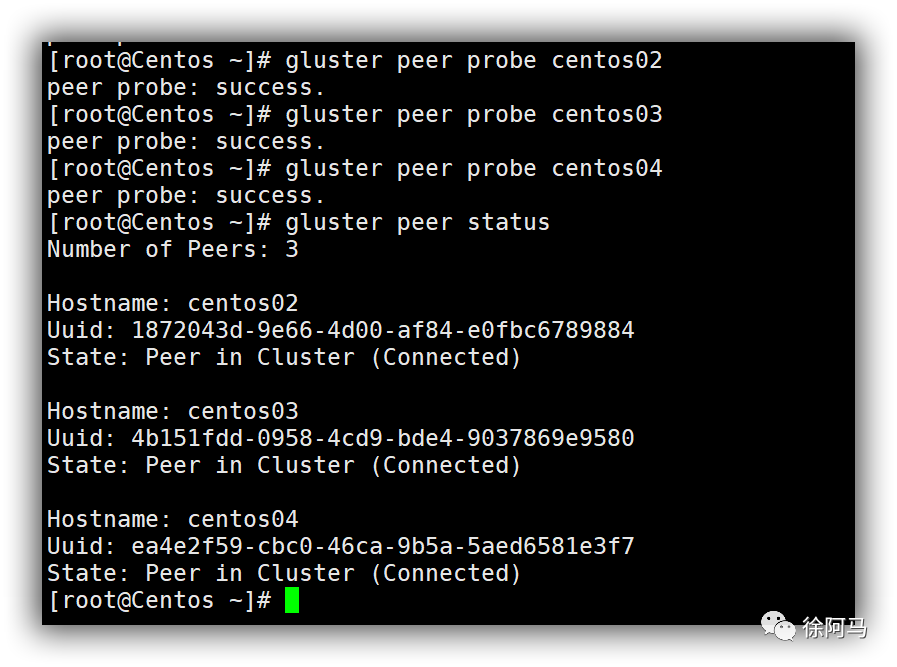

6.添加工作节点

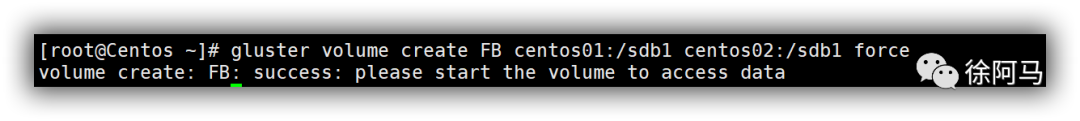

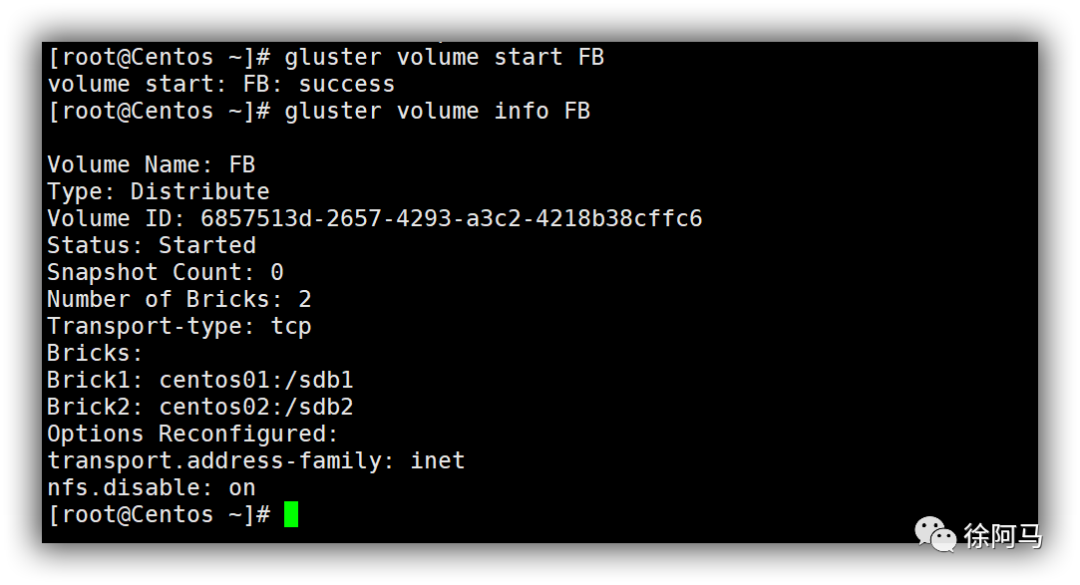

7.创建分布式卷

1)创建分布式卷

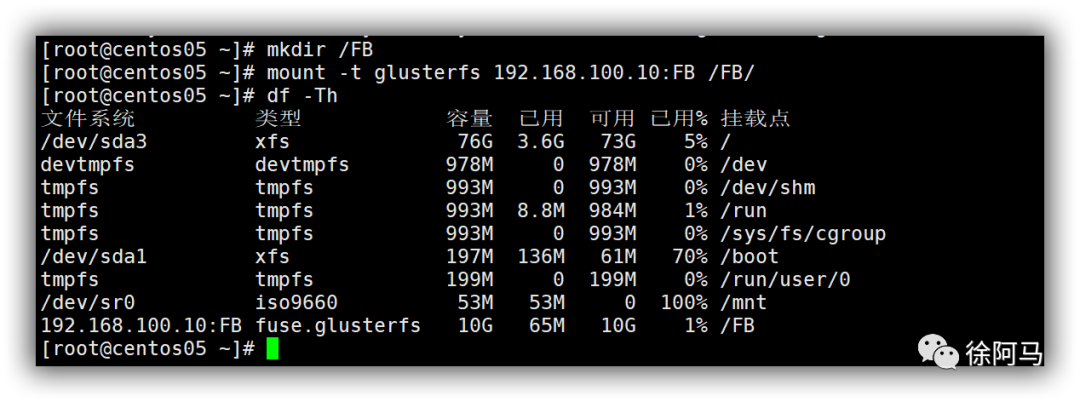

客户端进行挂载

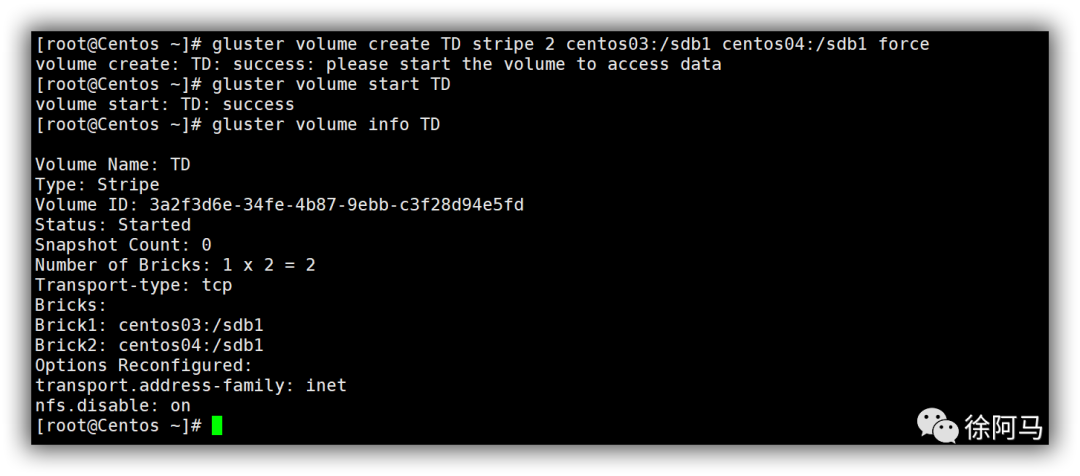

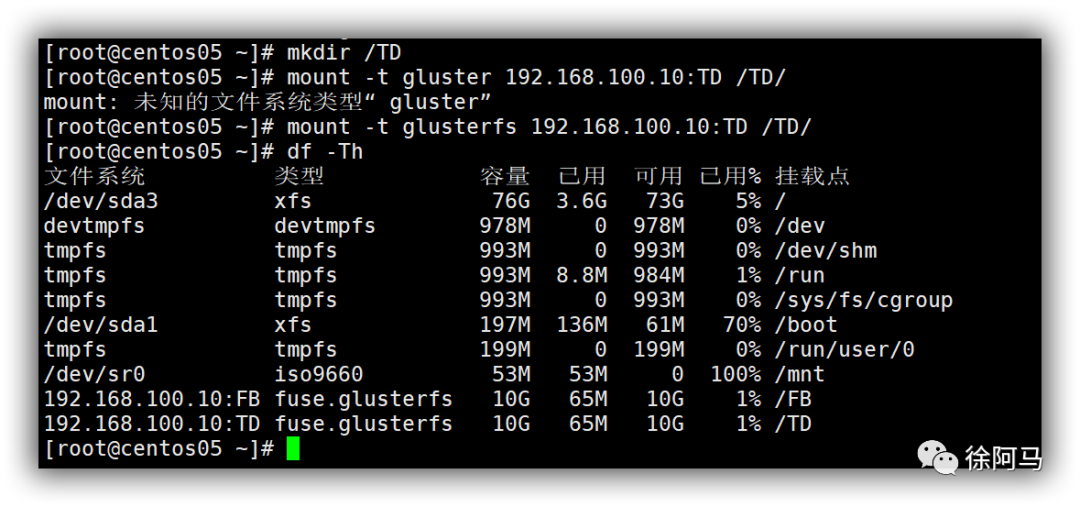

8.创建条带卷

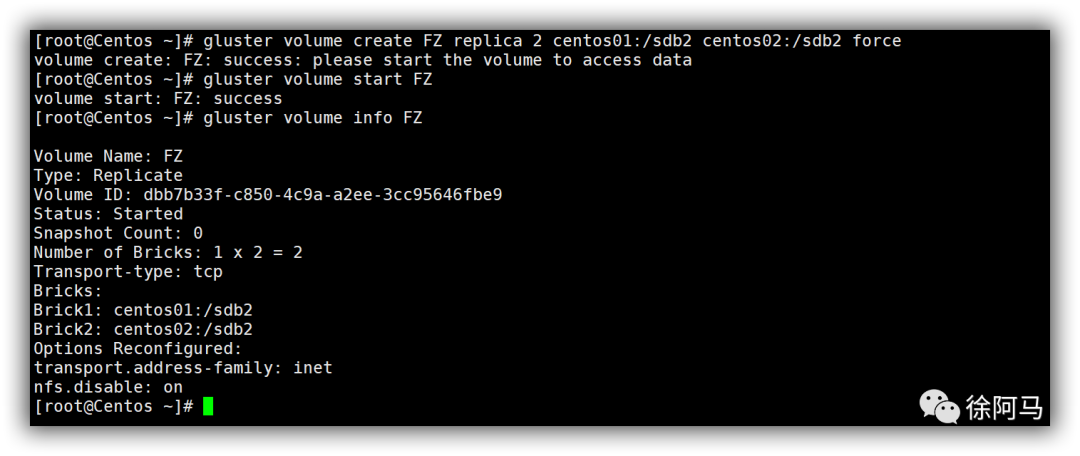

9.创建复制卷

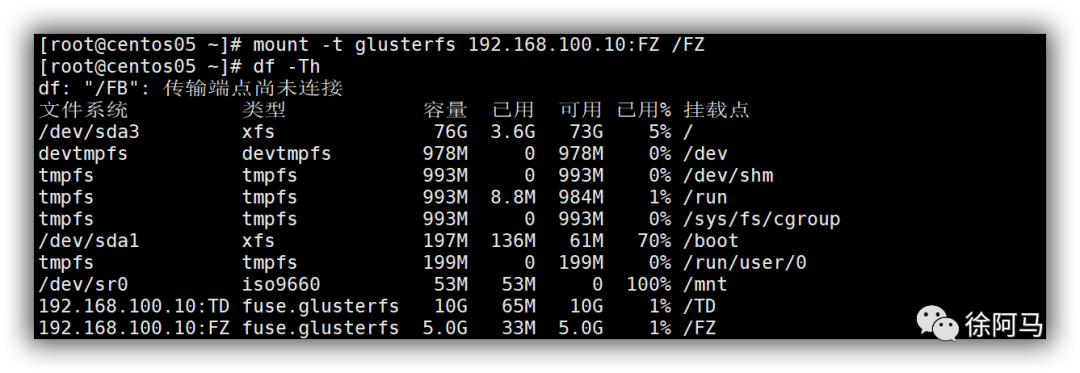

客户端挂载

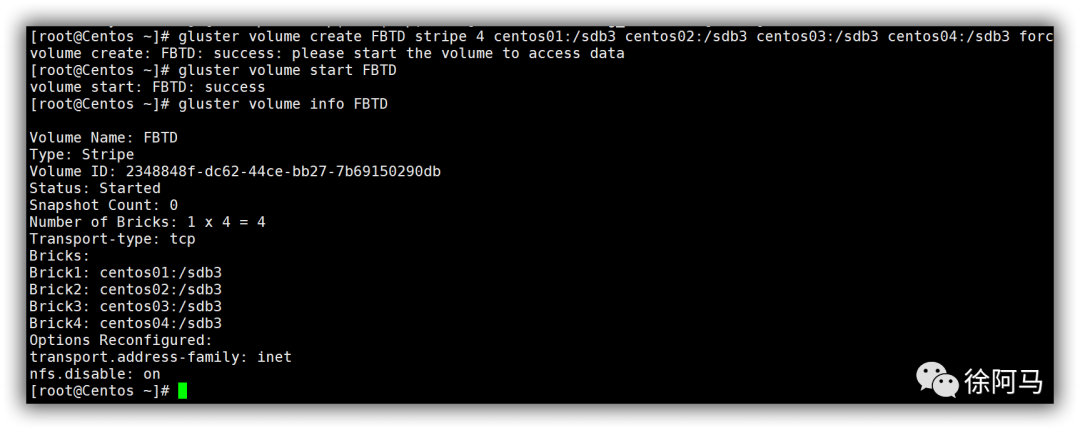

10.创建分布条带

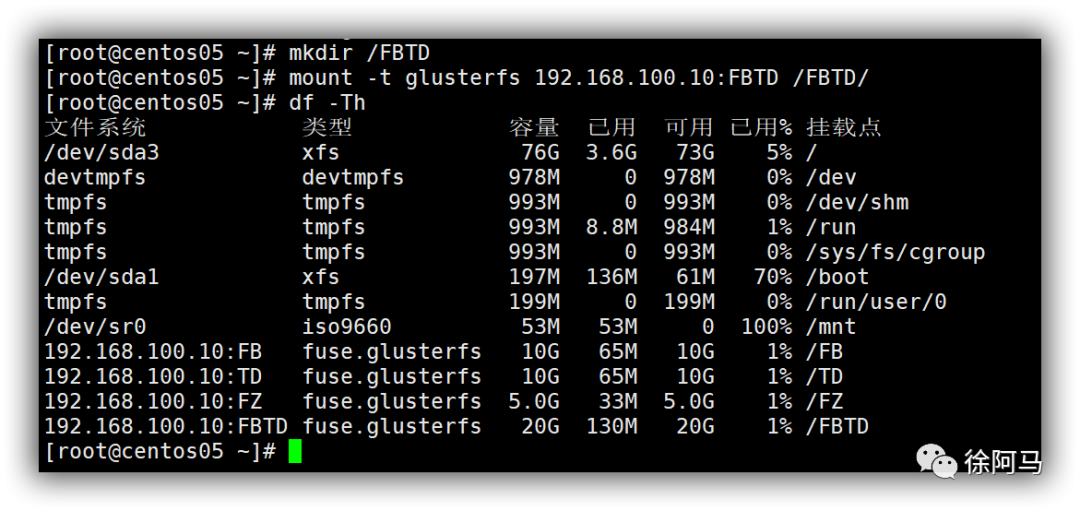

客户端挂载

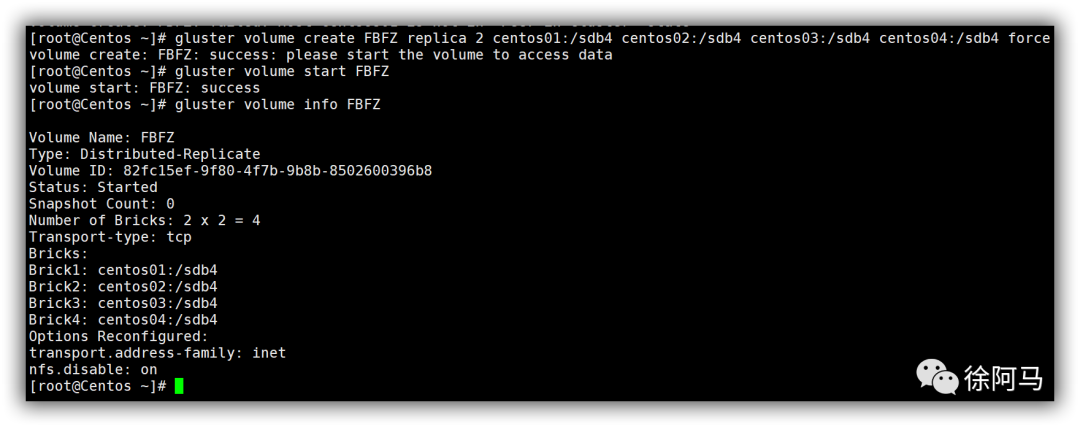

11.创建分布复制卷

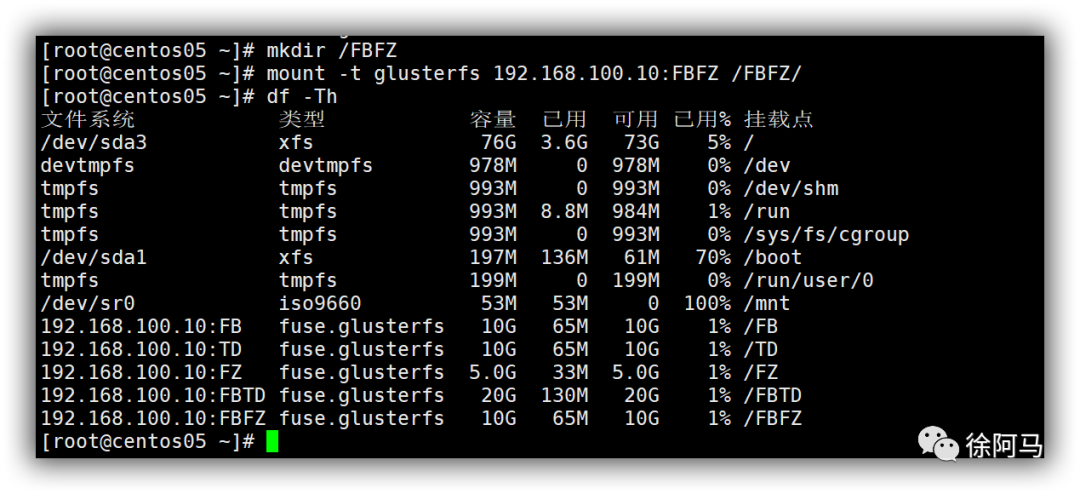

客户端挂载

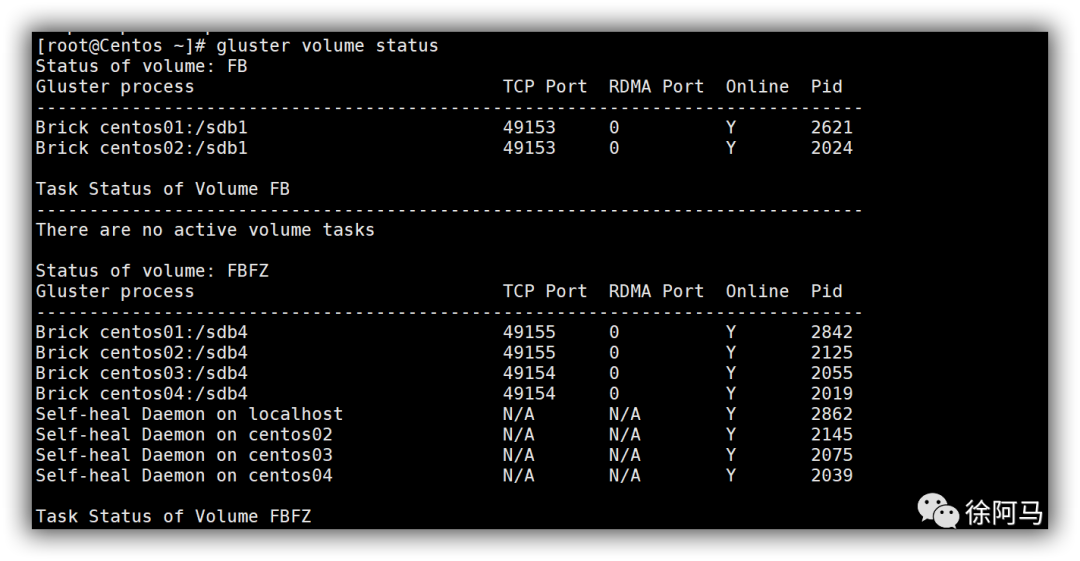

12.执行以下命令查看卷信息

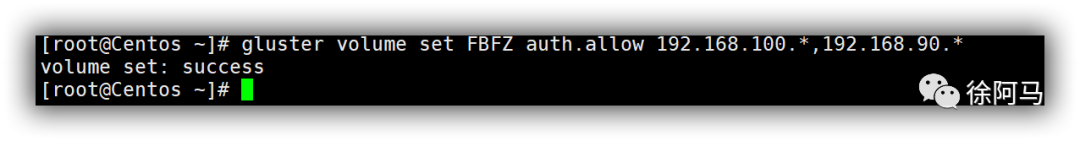

13.执行以下命令设置访问控制列表

以上命令是允许192.168.100段和90段允许访问分布复制卷

至此,结束~

故事很短,道理很长,学无止境,不忘初心,砥砺前行

微信搜索 “徐阿马” 关注公众号,期待你的关注!