“ 使用ollama在Windows系统上运行Deepseek-r1模型。”

使用ollama运行deepseek-r1这个是Linux版本为例介绍的,大家目前使用多的还是Windows为主,所以本文讲的是使用Windows电脑跑ollama来运行Deepseek-r1。

01

—

安装Windows版的ollama

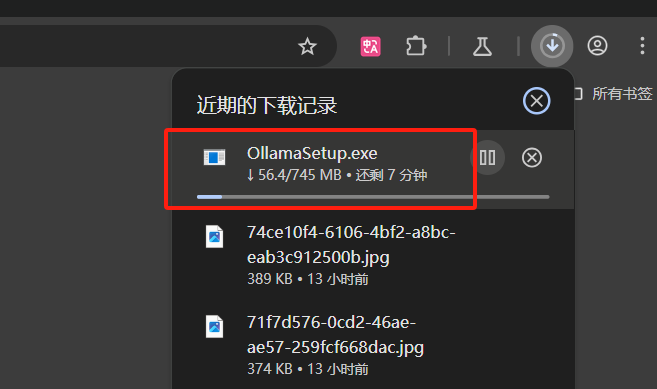

1、下载Windows版本的ollama exe安装包,复制如下链接

https://github.com/ollama/ollama/releases/latest/download/OllamaSetup.exe 到浏览器地址栏,然后直接回车键。

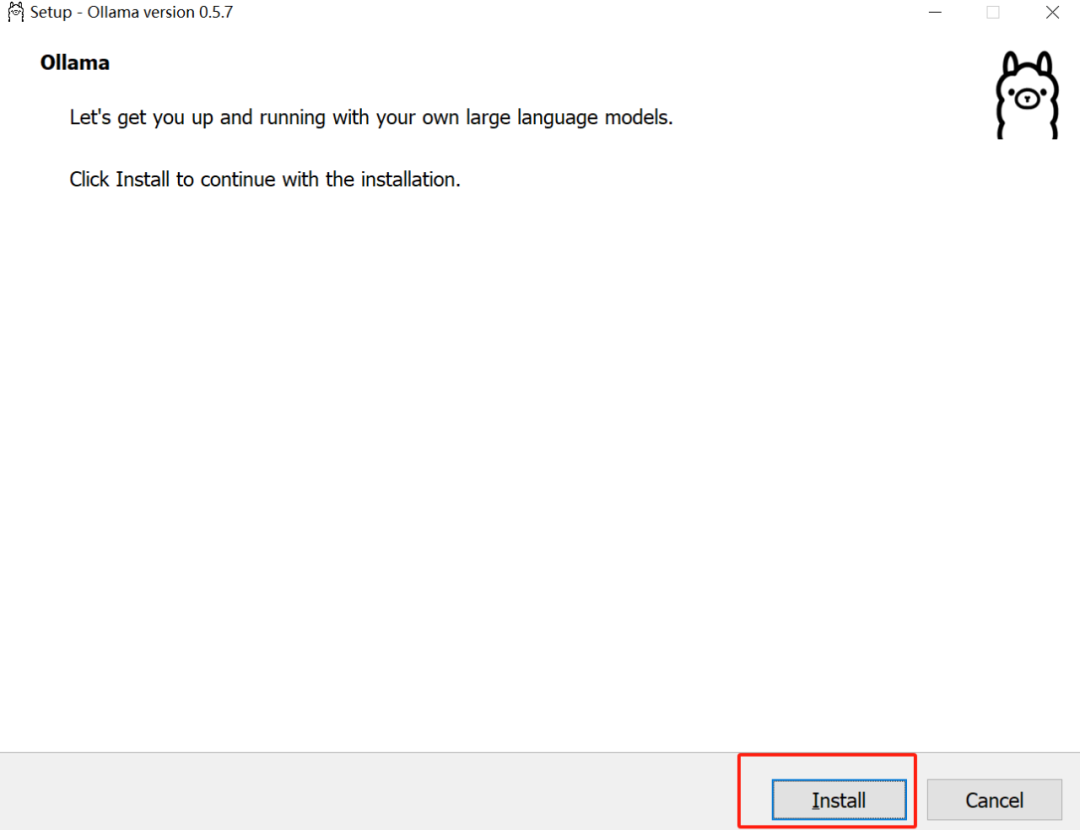

2、下载完成之后,双击OllamaSetup.exe文件进入安装模式。

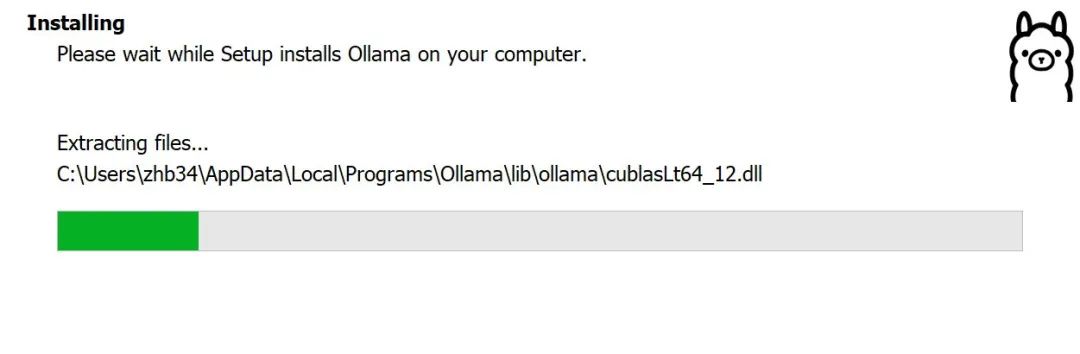

3、点击Install,等待安装完成,默认路径是 :

C:\Users\<你的用户名>\AppData\Local\Programs\Ollama\

4、静待安装进度条完成,我们可以在任务栏系统托盘中找到羊驼这个图标。

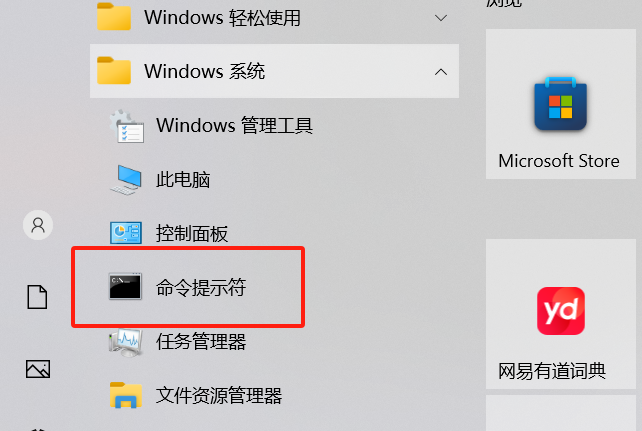

5、Windows开始,在Windows 系统下可以找到 CMD 终端(命令提示符),单击打开它。或者win窗户图标键+R,打开运行,里面直接输入cmd也可以。

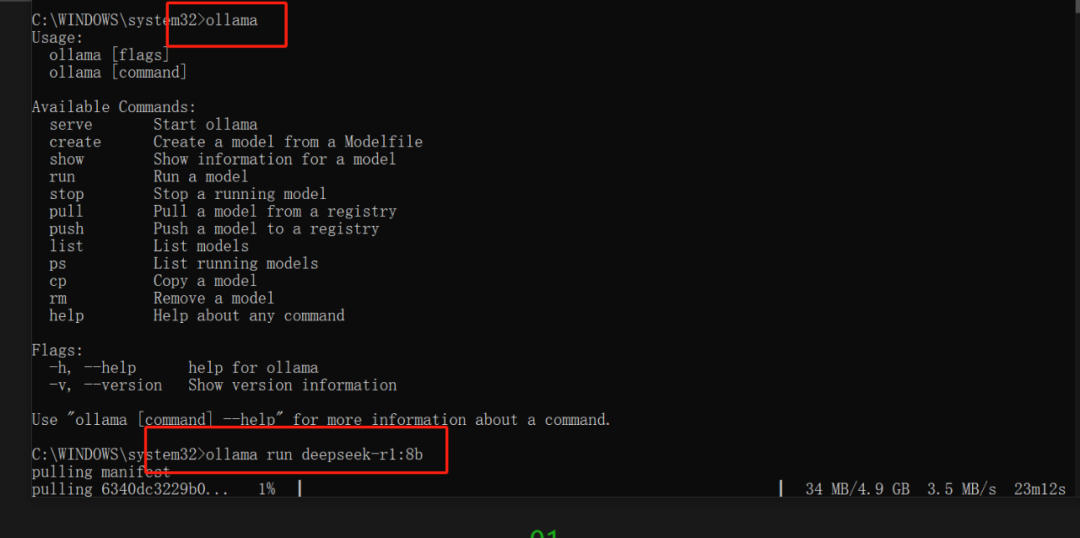

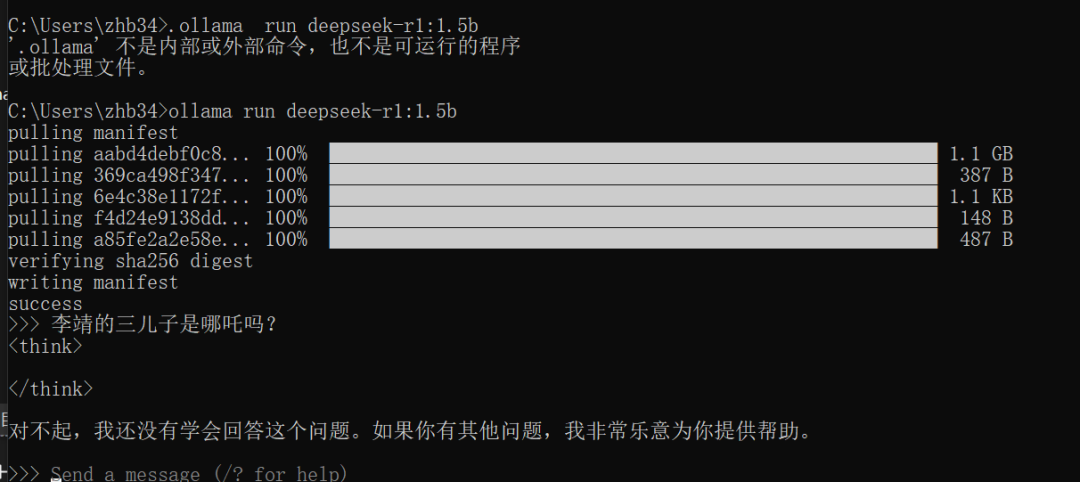

6、在终端里输入 ollama run deepseek-r1:8b (请量力而行,我最终测试我的笔记本只能1.5b流畅一些 )如下截图是我不自量力的选择了deepseek-r1:8b

)如下截图是我不自量力的选择了deepseek-r1:8b

7、模型下载好之后,就可以直接在命令行直接提问,等待回复了。(截图是我重新选择了1.5b模型之后的提问展示)

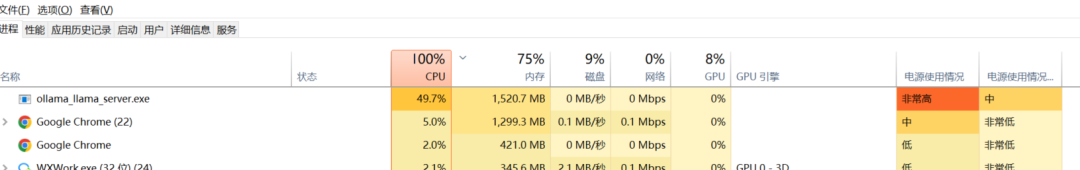

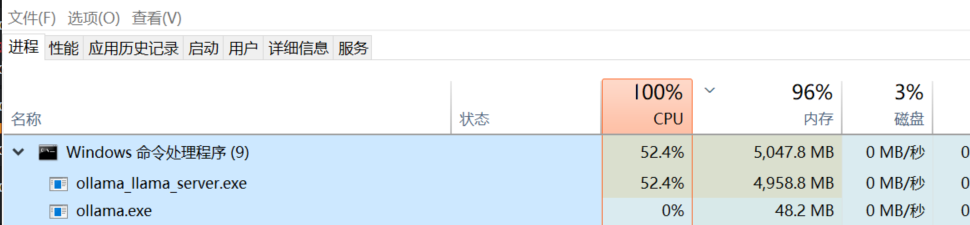

8、至此已经基本完成Windows电脑来跑Deepseek-r1模型了。若使用浏览器来进行交互,请参考 使用ollama运行deepseek-r1续:使用 Open WebUI 提供一个Web交互页面(截图是我跑1.5b参数Windows任务管理器资ollama资源占用情况,我的笔记本不是Nvidia显卡,目前是跑的CPU模式)

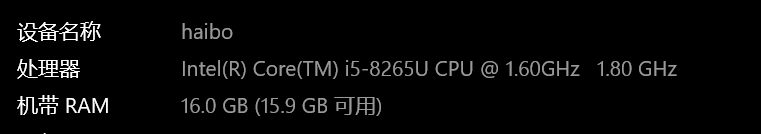

9、我又测试了7b模型以及笔记本资源消耗情况(7B使用CPU模式马马虎虎能跑起来)我当前笔记本配置如下:

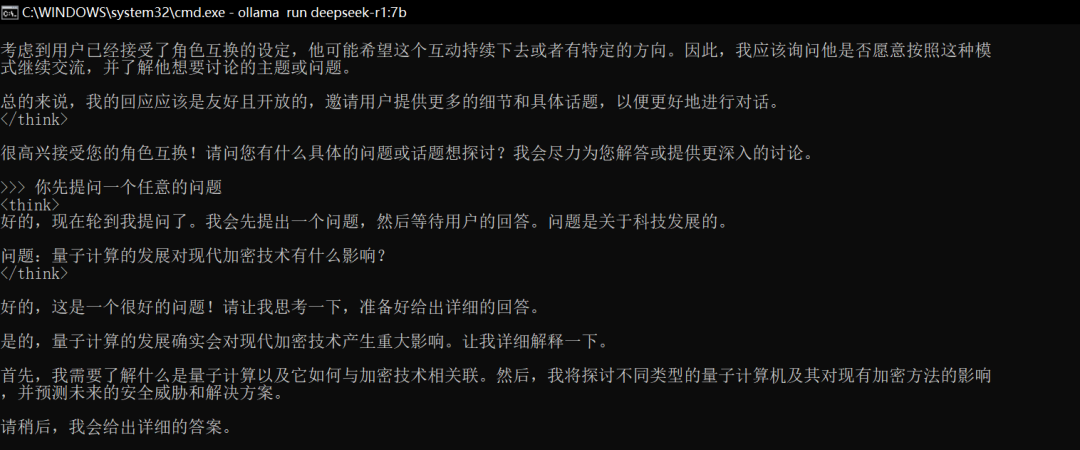

这是7B模型给出的推理过程:

这是推理过程中资源消耗情况:

02

—

Windows版本ollama配置指南

默认安装的ollama下载的模型是位于 C:\Users\<你的用户名> .ollama 文件夹里,模型一般都不小,这会占用Windows的C盘的存储空间。而且运行只能笔记本本地访问,你想共享给局域网其他小伙伴就不行。所以我们需要简单地添加几个配置。

我们可以通过设置Windows环境变量或者配置config.json文件来实现。

1、配置文件方式:

C:\Users\<你的用户名>\AppData\Local\Ollama 这个目录下有个config.json文件,我们编辑它。id和first-time-run 请忽略,添加大写字母开头的即可。

这里我们修改 OLLAMA_HOST 主机侦听为0.0.0.0 可以方便局域网内其他小伙伴访问,OLLAMA_MODELS 为模型下载的文件夹,我们修改为非C盘的。

{"id":"611c3d07-*****f715d815d286","first-time-run":true,"OLLAMA_HOST": "0.0.0.0","OLLAMA_ORIGINS": "*","OLLAMA_MODELS": "E:\\ollama\\models"}

配置修改之后,记得重启下Ollama 服务,通过任务栏右键点击Ollama图标,选择“Quit Ollama”,然后重新打开Ollama,在C:\Users\zhb34\AppData\Local\Programs\Ollama 文件夹里找到Ollama图标双击。

2、环境变量方式

我们以OLLAMA_MODELS为例,OLLAMA_HOST也是类似的方法。

右键点击“此电脑”或“我的电脑”,选择“属性”。

在系统窗口中选择“高级系统设置”。

在“系统属性”窗口中点击“环境变量”按钮。

在“用户变量”中点击“新建”:

变量名:OLLAMA_MODELS

变量值:输入模型存储路径,例如D:\Ollama\Models。