DeepSeek横空出世,以较低的成本提供了行业领先的模型能力,震撼了全球AI市场。凭借强大的推理能力和宽松的开源可商用条件,DeepSeek迅速成为开发者和企业用户的热门选择。

然而,部署一个高性能的推理模型往往涉及繁琐的配置和优化,需要Python编码、容器、推理框架、机器学习等专业知识,这让不少人望而却步。

别担心!今天,我们就来介绍一个省时省力的利器——AI Quick Action,它能让你在Oracle Cloud Infrastructure (OCI) 上轻松部署DeepSeek模型,体验推理模型的“Aha moment”。

AI Quick Action:极简的模型部署利器

AI Quick Actions是Oracle云上推出的大模型开发工具,用户可以轻松浏览基础模型,并借助Data Science的基础架构和开发环境来部署、微调和评估大模型。

主要优势

开箱即用:无需复杂环境配置,点击几下鼠标即可将开源模型或自有模型部署为推理服务。

高性能支持:依托 OCI(Oracle Cloud Infrastructure)强大的计算资源,支持GPU加速。

灵活自动扩展:可根据需求轻松调整资源,适应不同规模的应用场景。

高效便捷:相比传统手动部署方式,省时省力,减少踩坑。

简单来说,它的核心目标就是:用更少的步骤,高效部署AI模型,让开发者更专注于模型应用,而非环境配置。

浏览和注册模型

AI Quick Action支持多种模型注册方式:

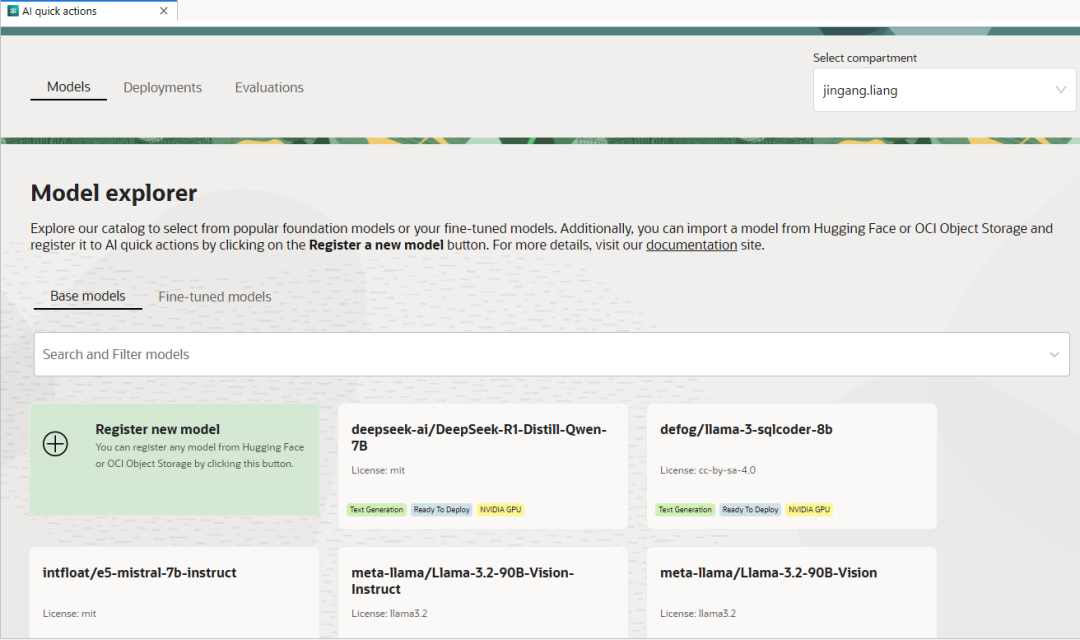

预配模型:已由OCI数据科学部门测试和配置(包括Llama、Mistral等),可直接部署,无需注册。

从云存储导入:如果你有自己的模型,可存储至对象存储,注册后再部署。

从Hugging Face导入:直接浏览开源存储库,引入模型以在AI Quick Actions中使用。

Hugging Face是一个流行的 AI 模型存储库,托管了许多先进的大语言模型 (LLM),包括 DeepSeek R1及其较小的R1蒸馏模型。

AI Quick Action是Data Science服务中的一组工具,启动方式可参考官方文档。进入界面后即可看到模型面板,其中列出的模型都是已经注册的模型,可以直接部署。

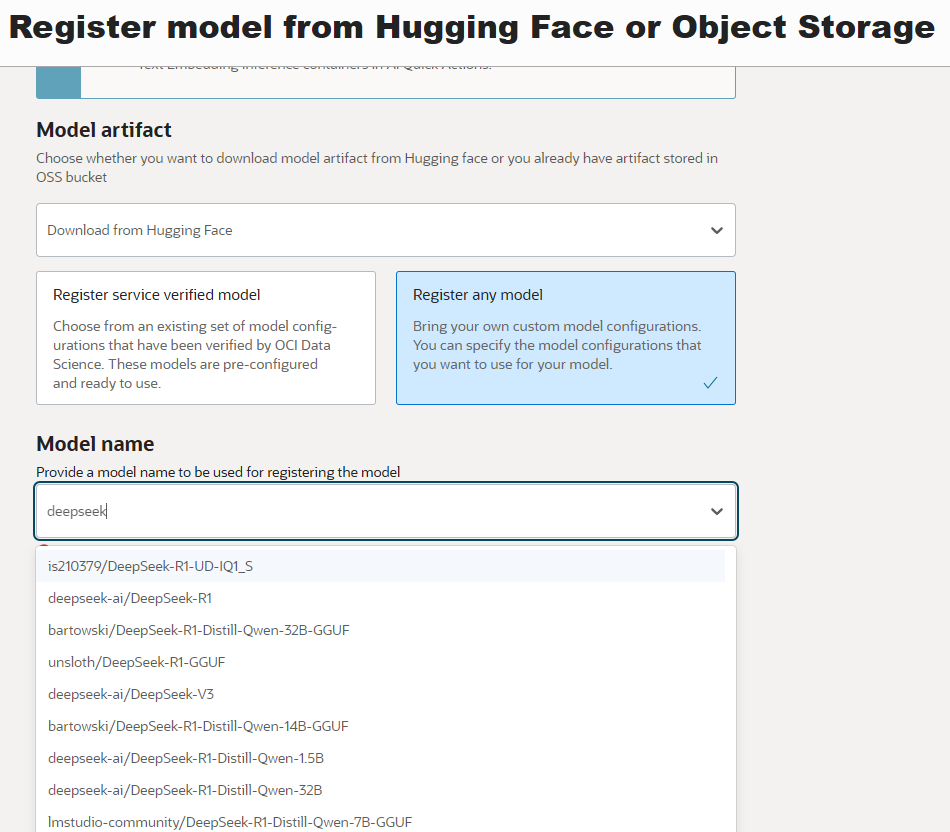

点击“Register new model”,选择“Download from Hugging Face” → “Register any model”,通过搜索模型名称查找Hugging Face存储库上的DeepSeek模型。

在这一步,我们选择 “deepseek-ai/DeepSeek-R1-Distill-Qwen-7B” 作为示例,部署一个较小的模型进行快速验证。

随后,选择“推理容器”和“对象存储位置”,设置完成后点击“Register”,即可注册模型。

DeepSeek,启动!

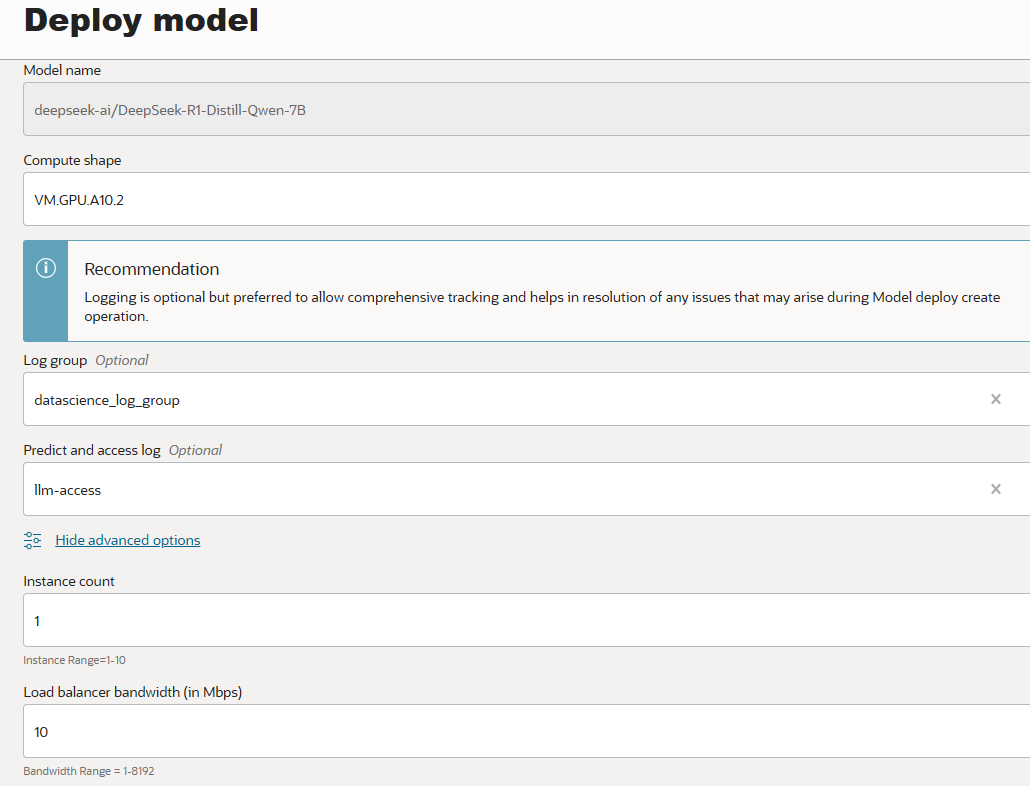

启动过程相当简单:在“Model Explorer”中找到已注册的DeepSeek模型,打开卡片后,点击“Deploy”。唯一必选配置是Compute shape(计算资源),可根据模型需求选择合适的GPU型号。

其他可配置选项包括:

开启日志记录 在多个计算实例上部署多套模型 负载均衡 推理容器参数 推理 API 格式等

体验推理模型

在 “Deployments” 标签页可查看已部署的模型列表,可随时启动和关闭计算实例。

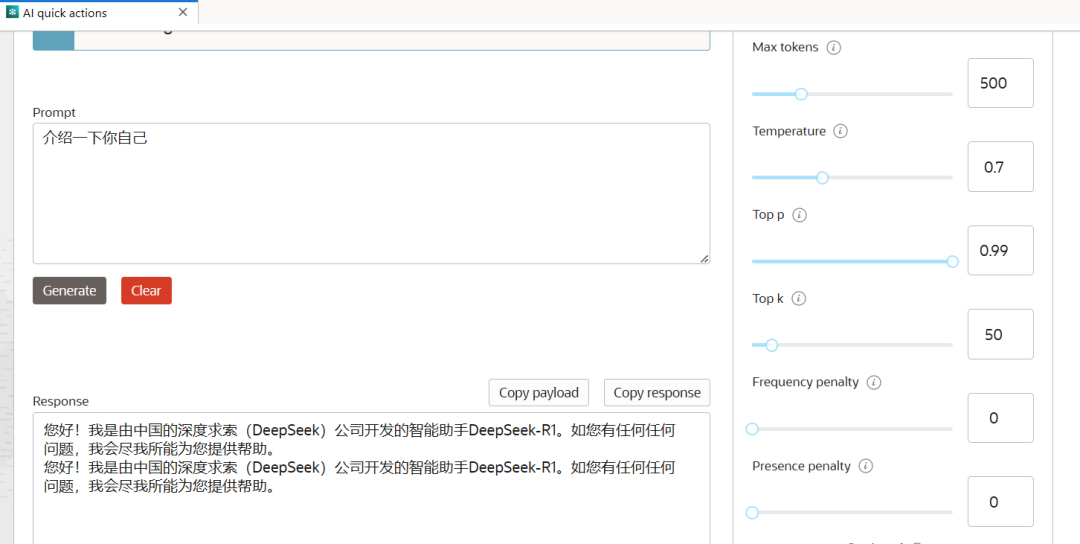

打开刚部署的 DeepSeek,可直接在界面上进行模型测试。

AI Quick Action 已为部署的模型构建了负载均衡器和 HTTPS 端点,可通过调用 https://modeldeployment.region.oci.customer-oci.com/xxxxx/predict 在生产环境下集成至客户自己的应用。

下面是基于AI Quick Action部署的DeepSeek模型构建的聊天机器人示例。可以看到AI在回答问题前进行详细思考和计划,答案更加准确、全面。这一能力将极大提升企业 AI 应用的深度和广度。

避坑指南

1. 注册模型阶段,对象存储列表为空?

储存大模型构件的存储桶必须开启 “对象版本控制” 才能正确显示。

2. 开始部署模型后,等待很长时间后失败?

可以从日志中查看报错原因。

3. 部署失败后,日志中显示GPU资源不足的报错?

此示例中,使用A10.2可直接部署Qwen-7B模型。在推理容器参数中指max_model_len(如27056),可减少GPU需求,避免资源不足导致的失败。添加参数后使用A10.1就可以部署。

结语

AI Quick Action 让AI模型的部署变得前所未有的简单,无需深厚的DevOps经验,就能快速上手。无论是企业用户还是个人开发者,都能借助这一工具,高效落地AI方案,专注于业务创新。

编辑:范宏伟