ollama -vollama version is 0.5.7复制

ollama pull复制

ollama run复制

ollama run deepseek-r1:1.5bpulling f4d24e9138dd... 100% ▕██████████████████████████████████████████████████████████████████████████▏ 148 Bpulling a85fe2a2e58e... 100% ▕██████████████████████████████████████████████████████████████████████████▏ 487 Bverifying sha256 digest复制

>>> hao are you<think></think>Hello! I'm DeepSeek-R1, an artificial intelligence assistant created by DeepSeek. I'm at your service and would be delighted toassist you with any inquiries or tasks you may have.>>> 地球直径是多少<think></think>地球的直径约为 **12,742公里**,从赤道到两极的距离略有不同。具体来说:- 从赤道测量:约 **12,742.0 km**- 从南北极测量:约 **12,742.0 km**复制

ollama pull nomic-embed-text复制

% ollama listNAME ID SIZE MODIFIEDnomic-embed-text:latest 0a109f422b47 274 MB 30 minutes agodeepseek-r1:1.5b a42b25d8c10a 1.1 GB 16 hours ago复制

聊天(Chat)端点:POST /api/chat功能:支持多轮对话,模型会记住上下文。请求格式:{"model": "<model-name>", // 模型名称"messages": [ // 消息列表{"role": "user", // 用户角色"content": "<input-text>" // 用户输入}],"stream": false, // 是否启用流式响应"options": { // 可选参数"temperature": 0.7,"max_tokens": 100}}响应格式:{"message": {"role": "assistant", // 助手角色"content": "<generated-text>" // 生成的文本},"done": true}复制

curl http://localhost:11434/api/generate -d '{"model": "deepseek-r1:1.5b","prompt": "你好,你能帮我写一段代码吗?","stream": false}'复制

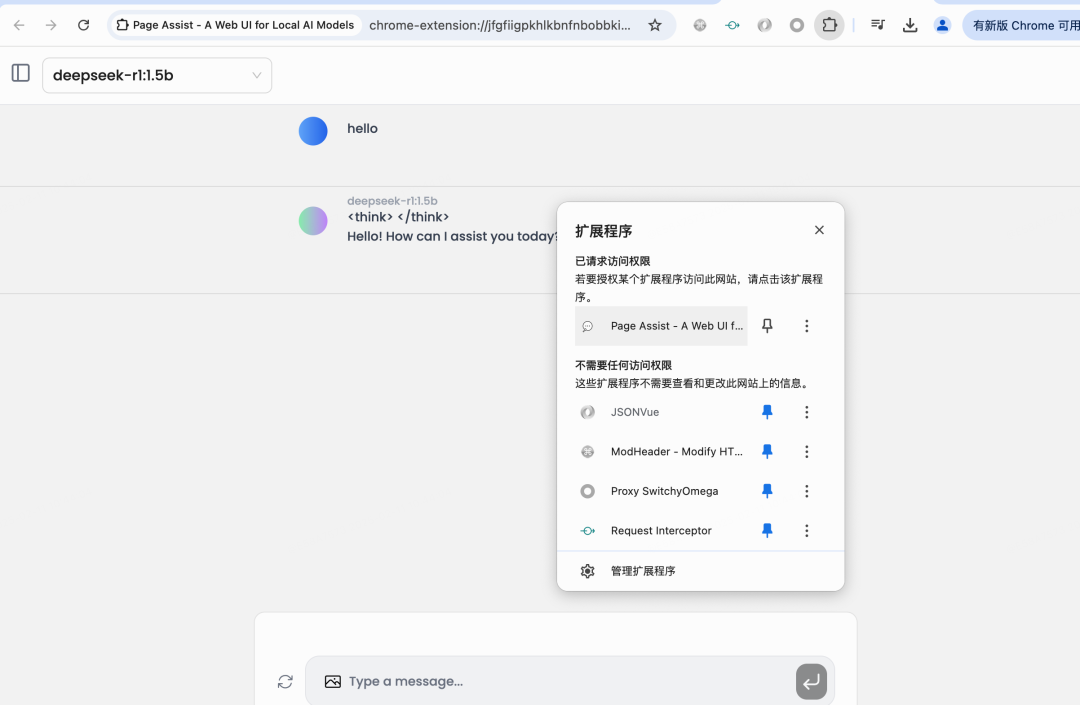

如果要部署一个服务给外界使用,可以使用open-webui:ollama run deepseek-coder:1.3b复制

文章转载自golang算法架构leetcode技术php,如果涉嫌侵权,请发送邮件至:contact@modb.pro进行举报,并提供相关证据,一经查实,墨天轮将立刻删除相关内容。

评论

相关阅读

2025年3月中国数据库排行榜:PolarDB夺魁傲群雄,GoldenDB晋位入三强

墨天轮编辑部

1626次阅读

2025-03-11 17:13:58

【专家观点】罗敏:从理论到真实SQL,感受DeepSeek如何做性能优化

墨天轮编辑部

1234次阅读

2025-03-06 16:45:38

【专家有话说第五期】在不同年龄段,DBA应该怎样规划自己的职业发展?

墨天轮编辑部

1215次阅读

2025-03-13 11:40:53

01. HarmonyOS Next应用开发实践与技术解析

若城

1175次阅读

2025-03-04 21:06:20

DeepSeek R1助力,腾讯AI代码助手解锁音乐创作新

若城

1160次阅读

2025-03-05 09:05:00

03 HarmonyOS Next仪表盘案例详解(二):进阶篇

若城

1158次阅读

2025-03-04 21:08:36

05 HarmonyOS NEXT高效编程秘籍:Arkts函数调用与声明优化深度解析

若城

1149次阅读

2025-03-04 22:46:06

04 高效HarmonyOS NEXT编程:ArkTS数据结构优化与属性访问最佳实践

若城

1140次阅读

2025-03-04 21:09:35

02 HarmonyOS Next仪表盘案例详解(一):基础篇

若城

1137次阅读

2025-03-04 21:07:43

06 HarmonyOS Next性能优化之LazyForEach 列表渲染基础与实现详解 (一)

若城

1128次阅读

2025-03-05 21:09:40