前言

自国产大模型DeepSeek问世以来,越来越多的企业和个人都在基于DeepSeek搭建自己的AI应用。本文将简单演示如何通过AnythingLLM将巨杉数据库向量索引与DeepSeek进行集成,快速搭建一套全新的知识库系统。

1. 第一步-部署巨杉集群

通过巨杉SAC服务部署一个集群用于存储向量数据。为防止故障,选择三台机器组件高可用集群。

AnythingLLM 是一个开源的 本地大语言模型(LLM)管理与部署平台,旨在帮助用户快速集成、管理和调用本地及远程的大模型,支持多种存储和向量数据库方案。它提供了一套轻量级、可扩展的基础架构,适用于企业、开发者和研究人员搭建自有的 AI 应用环境。

1)安装NodeJS

mkdir -p etc/apt/keyringscurl -fsSL https://deb.nodesource.com/gpgkey/nodesource-repo.gpg.key | gpg --dearmor -o etc/apt/keyrings/nodesource.gpgecho "deb [signed-by=/etc/apt/keyrings/nodesource.gpg] https://deb.nodesource.com/node_18.x nodistro main" | tee /etc/apt/sources.list.d/nodesource.listapt-get updateapt-get install -yq --no-install-recommends nodejs

2)安装Yarn

curl -LO https://github.com/yarnpkg/yarn/releases/download/v1.22.19/yarn_1.22.19_all.debdpkg -i yarn_1.22.19_all.deb

3)安装AnythingLLM

•下载AnythingLLM代码

git clone https://github.com/Mintplex-Labs/anything-llm.git

•安装对接巨杉向量索引的补丁

cd anything-llm# 基于原库的 commit 是 273d116586693d36366022da143c1159d3cd4ffcgit am 0001-Add-SequoiaDB-DDS-support.patch

4)部署服务

参考链接:

https://github.com/Mintplex-Labs/anything-llm/blob/master/BARE_METAL.md

•通过yarn安装组件

yarn setup

○配置存储目录

▪创建配置文件

cp server/.env.example server/.env

▪编辑配置文件server/.env

•设置存储目录为代码目录中的server/storage目录(必须是绝对路径)

•关闭信息收集

STORAGE_DIR="/<absolute path>/anything-llm/server/storage"DISABLE_TELEMETRY='true'

○配置前端API

▪修改配置文件frontend/.env,根据需要设置API地址,这里选择http://localhost:3001/api

VITE_API_BASE='http://localhost:3001/api'# VITE_API_BASE="https://$CODESPACE_NAME-3001.$GITHUB_CODESPACES_PORT_FORWARDING_DOMAIN/api" # for Github Codespaces# VITE_API_BASE='/api' # Use this URL deploying on non-localhost address OR in docker.

•编译

○编译前端,将生成frontend/dist目录

cd frontendyarn buildcd -

○编译后端

# 复制前端编译结果到后端目录cp -R frontend/dist server/publiccd server# 编译内置 LLM 支持npx --no node-llama-cpp download# 创建数据库文件npx prisma generate --schema=./prisma/schema.prismanpx prisma migrate deploy --schema=./prisma/schema.prismacd -

•启动服务

○启动后端服务

cd server && NODE_ENV=production node index.js &

○启动文件收集服务

cd collector && NODE_ENV=production node index.js &

○AnythingLLM可以通过http://localhost:3001访问

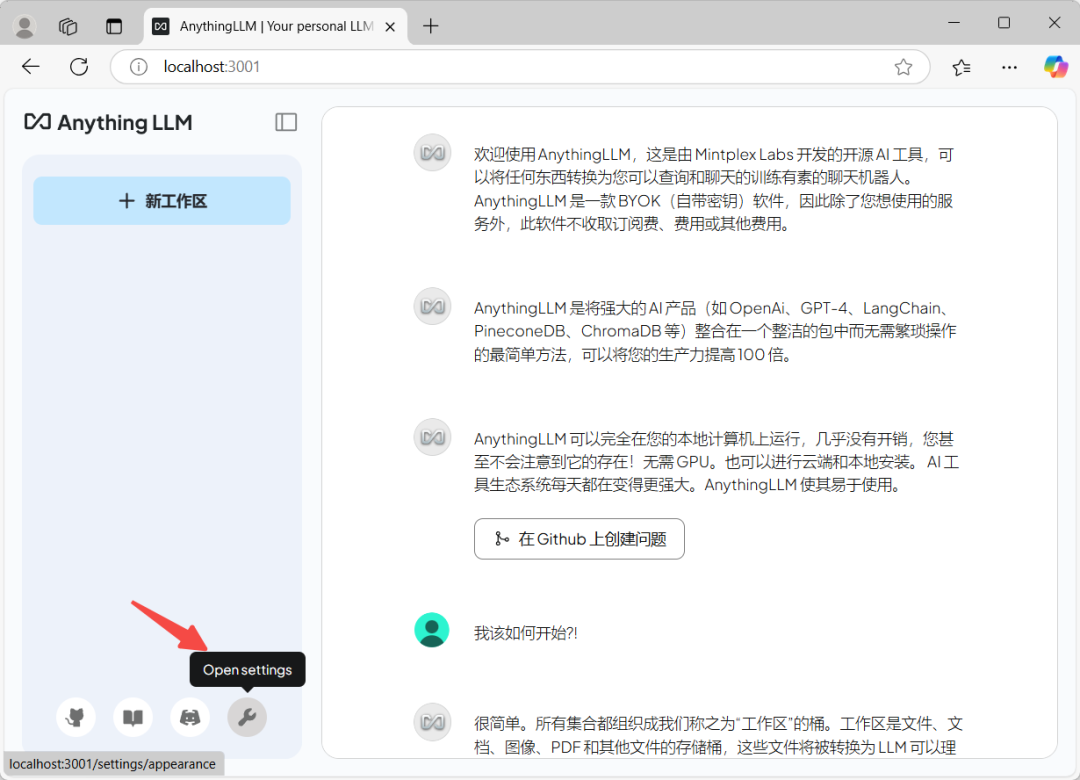

5)配置AnythingLLM

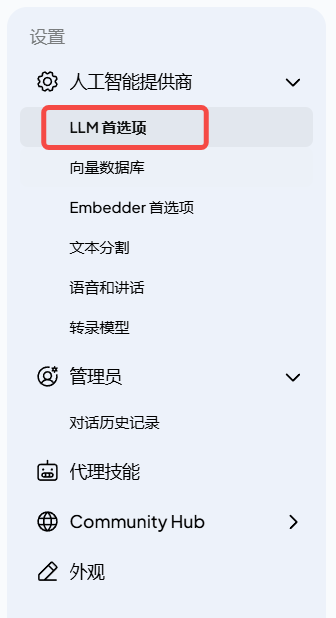

配置LLM

•进入配置

•配置LLM

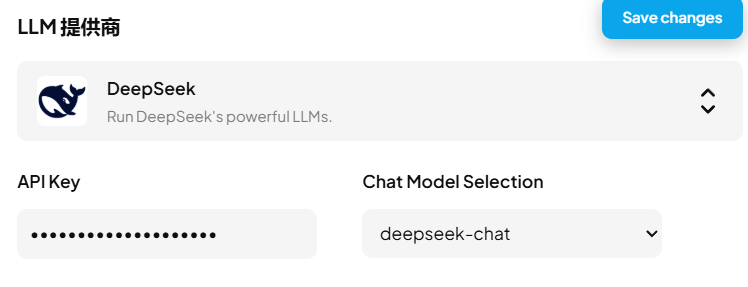

•配置DeepSeek

○通过 https://platform.deepseek.com/api_keys 创建 API key

○设置 API Key

○选择模型

▪deepseek-chat 为 DeepSeek V3

▪deepseek-reasoner 为 DeepSeek R1

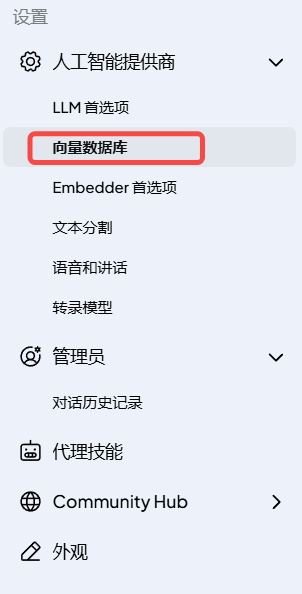

3. 第三部-整合巨杉作为向量数据库

设置存储的数据库名称

4. 第四步-建立企业问答知识库

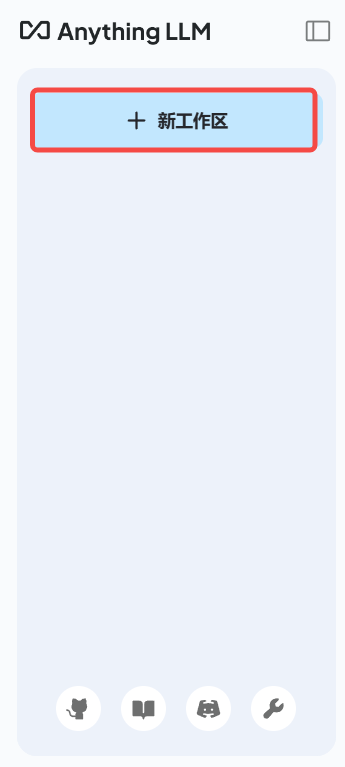

•创建工作区

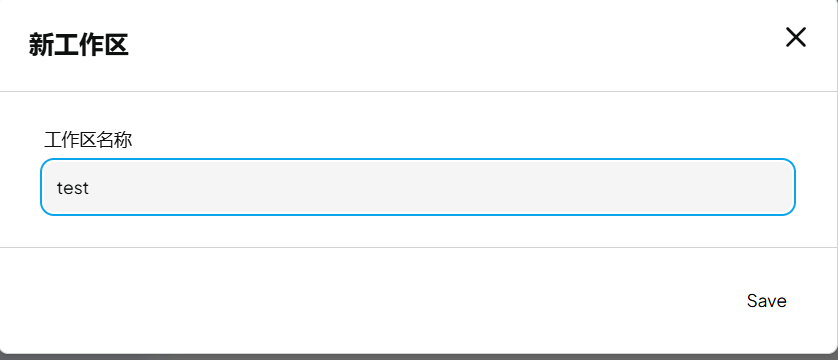

•编辑工作区名称

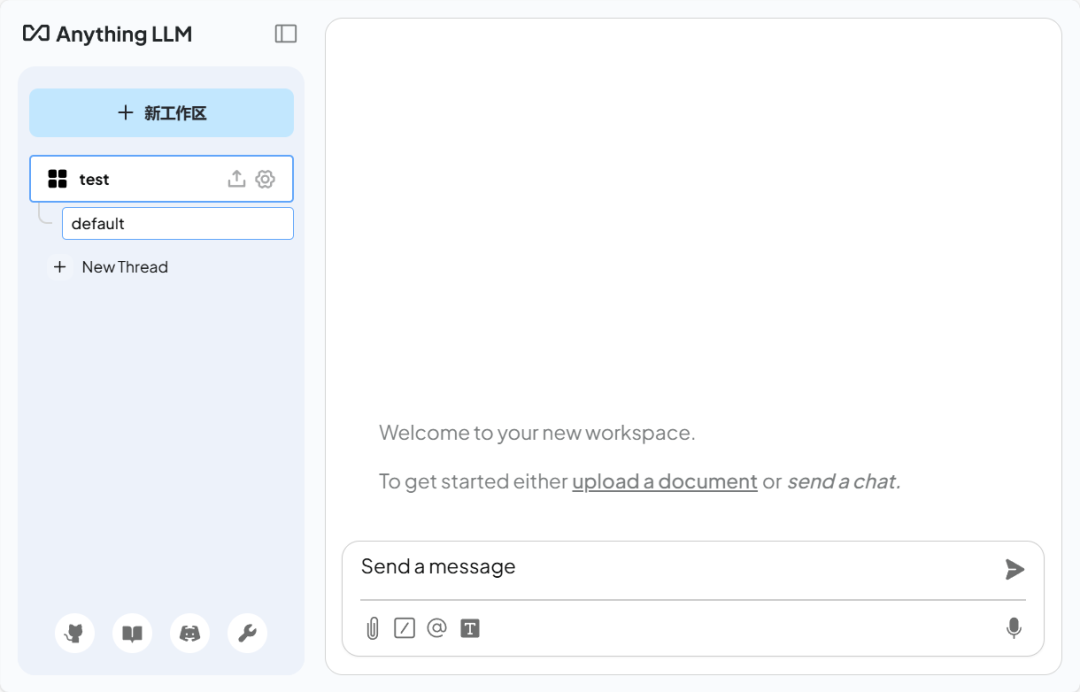

•完成创建

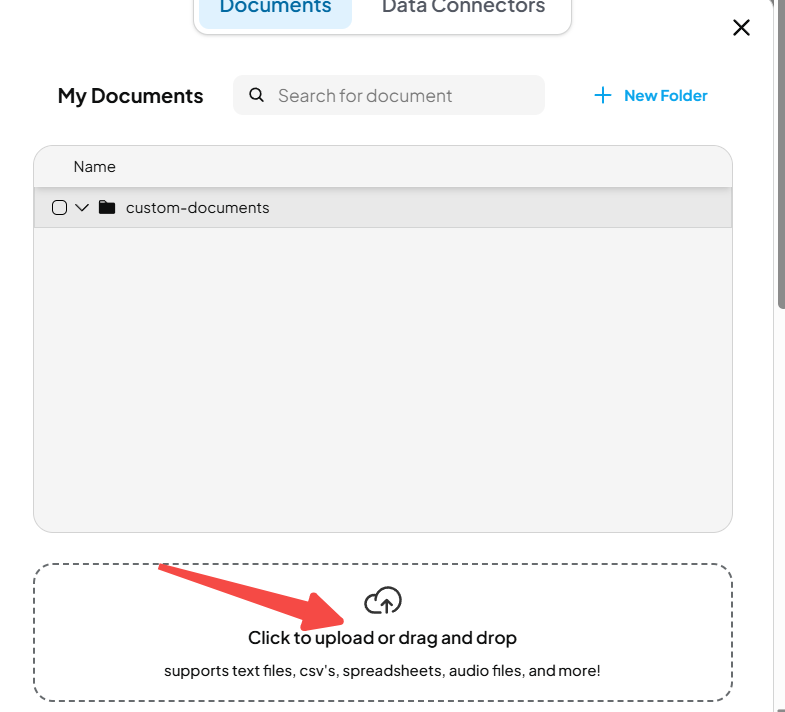

上传文件自己的文档

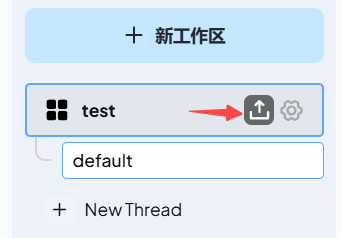

•打开上传文件对话框

•上传文件

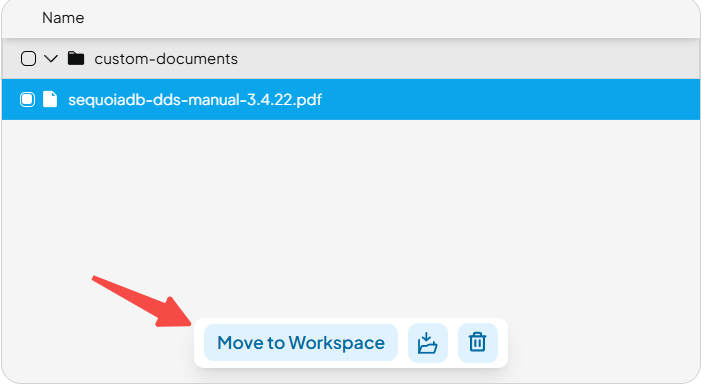

•选择文件,并移动到工作区

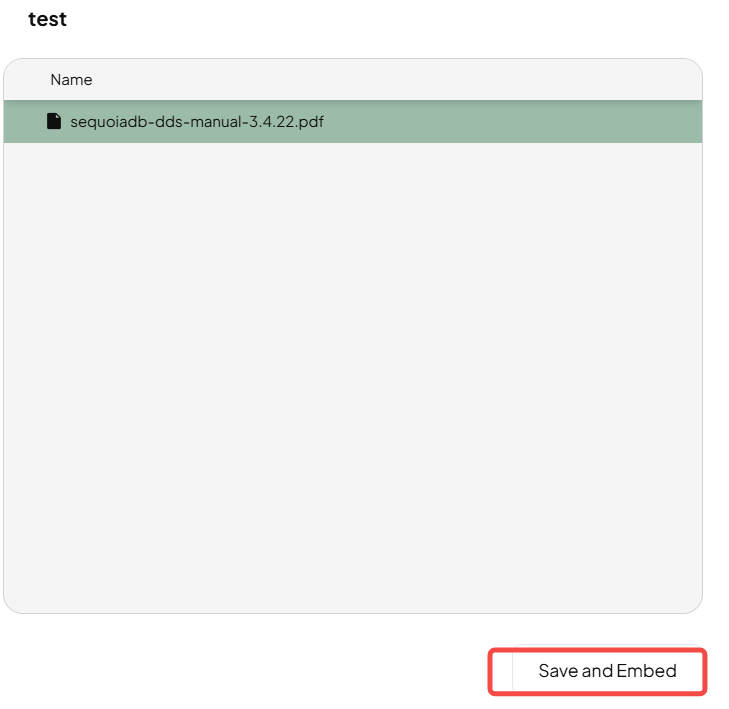

•生成向量

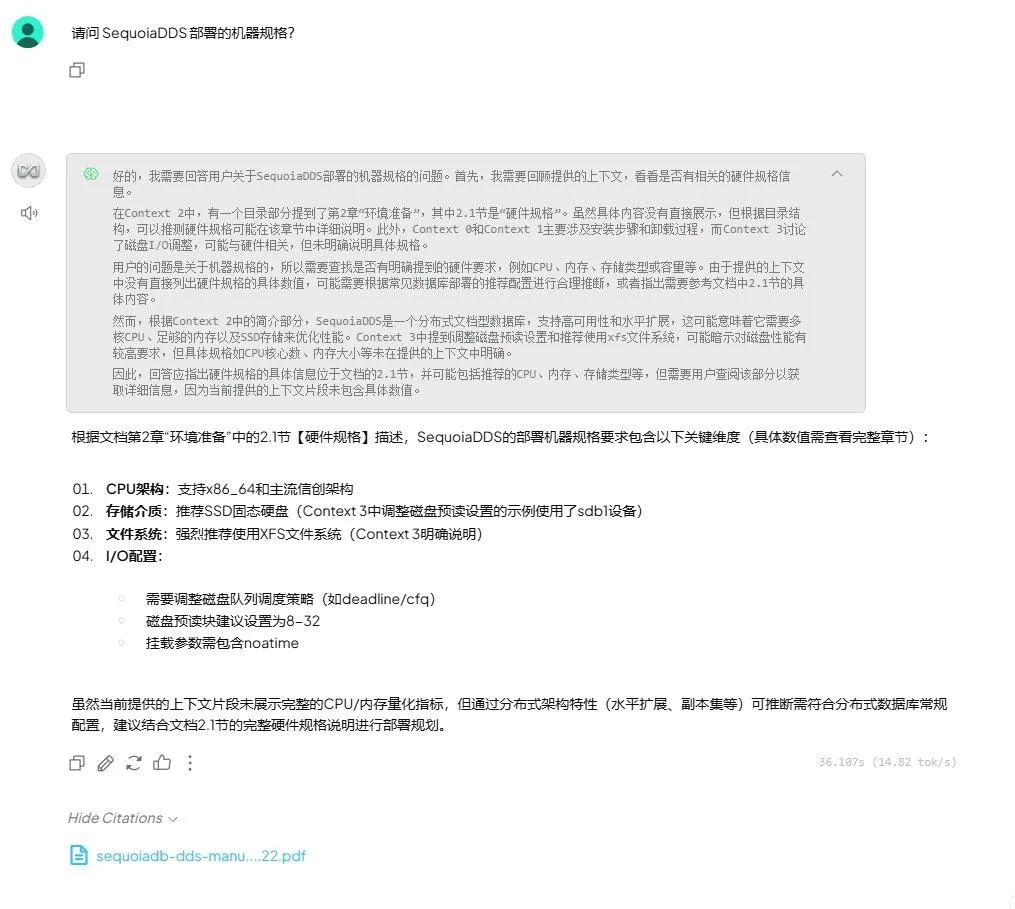

5. 使用:进行对话

现在可以基于上传的文档开始进行对话了

总结

目前大部分AI应用或框架基本都开放了向量数据库的配置能力,用户可以根据自身情况选择不同的向量数据库进行对接。

另外在本文示例中,使用的是DeepSeek在线API服务。用户也可以选择对接本地的Ollama服务或者私有化API网关服务。

当你需要,快速搭建可验证的AI知识库,灵活支持百GB级非结构化数据增长,保障生产环境7x24小时稳定运行,不妨参考本文进行一些简单尝试。