在上一篇文章《Microsoft、NVIDIA强强联合,全面提升AI研发与运算效能》中,我们介绍了微软与 NVIDIA 在 AI 领域的深入合作。随着智能体技术的快速发展,双方携手在 Azure AI Foundry(国际版)中推出多项全新服务,助力企业更高效地构建和运行 AI 智能体。本篇文章将详细解析这些新能力。

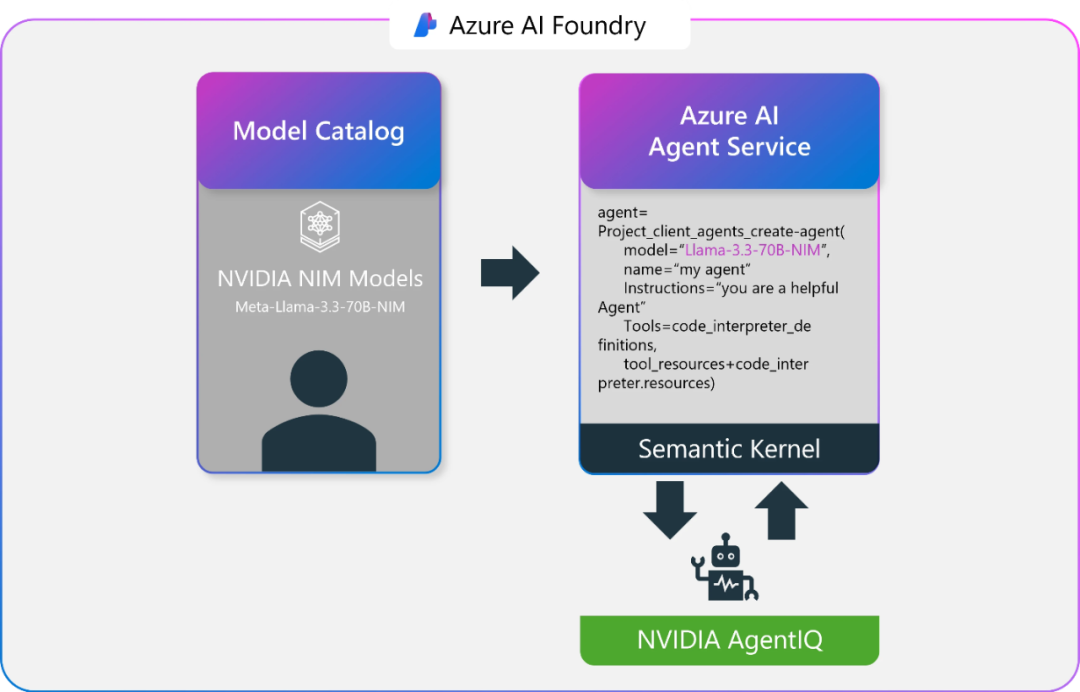

在 Azure AI Foundry 上使用 NVIDIA NIM

NVIDIA NIM™ 是 NVIDIA AI Enterprise 软件套件的一部分,提供了一套易于使用的微服务,专为安全、可靠、高性能的 AI 推理而设计。借助 NVIDIA Triton 推理服务器™、TensorRT™、TensorRT-LLM 和 PyTorch 等强大技术,NIM 微服务能够在 Azure(国际版)的托管计算环境中无缝扩展,为企业带来以下优势:

即刻部署,无需配置:开箱即用,自动优化,快速启用 AI 推理任务。

无缝 Azure 集成:与 Azure AI Agent Service 和 Semantic Kernel 完美兼容。

企业级可靠性:依托 NVIDIA AI Enterprise,确保 AI 推理的高可用性和安全性。

可扩展推理能力:利用 Azure 的 NVIDIA 加速基础设施,处理复杂的工作负载。

优化工作流:加速从大规模语言模型到高级分析的各类应用。

利用 NVIDIA AgentIQ 优化性能

NVIDIA AgentIQ 是一款开源工具包,专为优化 AI 智能体的运行效率而设计。它能够无缝连接智能体组件、分析系统状态,并提供优化建议,确保 AI 应用始终保持最佳性能。它提供以下功能:

性能分析与优化:基于实时遥测数据,精确调整 AI 智能体的部署策略,降低延迟并减少计算资源消耗。

动态推理增强:通过持续收集和分析元数据(如每次调用的预测输出令牌、下次推理的预计时间、预期令牌长度等),智能优化智能体性能。

与 Semantic Kernel 集成:与 Azure AI Foundry Agent Service(国际版)深度集成,为您的智能体提供更强大的语义推理和任务执行能力。

这种智能分析不仅能降低计算成本,还能提升推理准确性和响应速度,优化 AI 智能体的每个环节,确保更稳定高效的工作流。

此外,我们还将集成 NVIDIA Llama Nemotron Reason——一款专为复杂推理任务打造的强大 AI 模型。根据 NVIDIA 介绍,Nemotron 在编码、复杂数学和科学推理方面表现出色,能够精准理解用户意图,并智能调用搜索、翻译等工具,助力更高效的任务执行。

来自行业领袖们的真实反馈

“Azure AI Foundry(国际版)中的 NVIDIA NIM 微服务,为 Epic 提供了一种安全高效的方式来部署开源智能 AI 模型,从而改善患者护理,提升临床和运营效率,并挖掘医疗创新的新机遇。此外,我们正与 UW Health 和 UC San Diego Health 合作,探索如何利用这些 AI 模型改进临床报告评估。我们正一同使用最新的 AI 技术,真正改善临床医护人员和患者的体验。”

——Drew McCombs

Epic 云计算与分析副总裁

“ServiceNow 的 AI 平台与 NVIDIA NIM 以及 Microsoft Azure AI Foundry(国际版)和 Azure AI Agent Service(国际版)的结合,帮助我们将行业特定的开箱即用 AI 智能体推向市场,提供全栈的 AI 智能体解决方案,帮助更快地解决问题,提供卓越的客户体验,并加速提升企业的生产力和效率。”

——Jon Sigler,

EVP, Platform and AI at ServiceNow

立即体验

在 Azure AI Foundry(国际版)上部署 NVIDIA NIM 微服务,并利用 NVIDIA AgentIQ 工具包优化您的 AI 智能体。浏览 Azure AI Foundry(国际版)模型目录,激发创新、探索更多可能。让我们一起打造更智能、更快速、更高效的未来。