点击上方“IT那活儿”,关注后了解更多内容,不管IT什么活儿,干就完了!!!

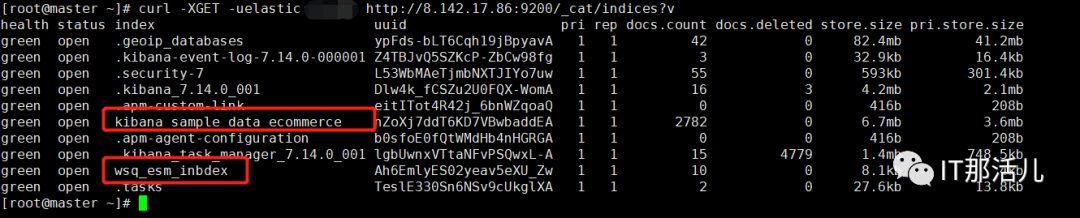

在使用Elasticsearch的时候不可避免的会涉及到集群的升级或者是业务的迁移等场景,此时就需要对数据进行迁移,es数据迁移的工具有很多比如reindex、esm、elasticdump、logstash和快照等方式。

使用ESM的优势是针对少数业务迁出,索引和数据相对较少,不需要修改ES配置文件不用重启集群,降低数据迁移对集群其他业务的影响的背景下相对来说速度较快的一种方案。

有数据测试表示迁移100W条数据ESM的速度仅次于reindex,接近logstash的两倍之快,当然这些与网络环境和硬件有必然的关系,我们在这里仅做参考即可。

01

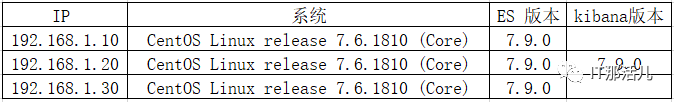

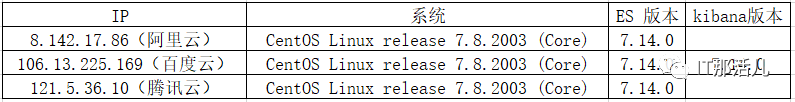

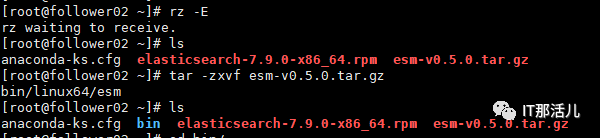

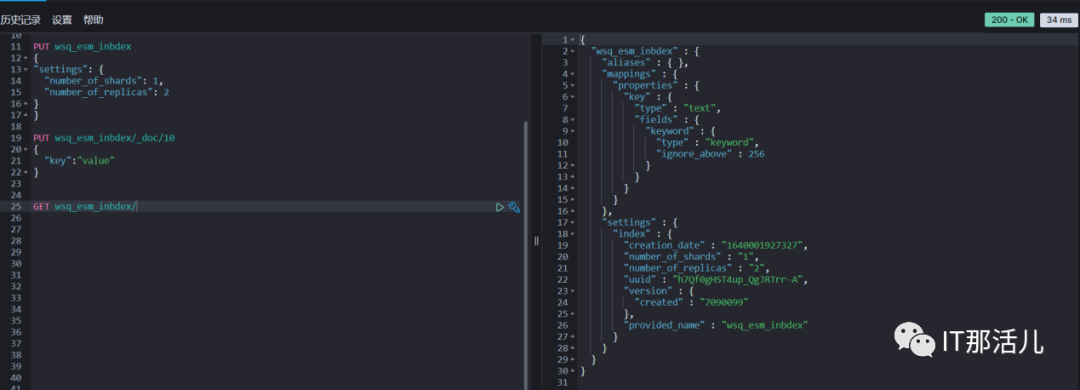

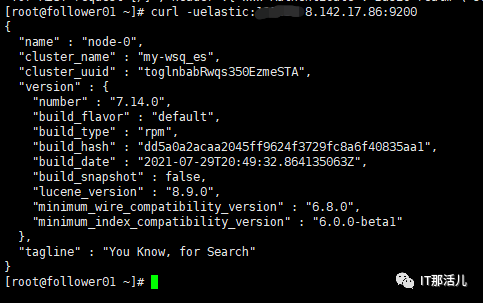

实验环境及准备

02

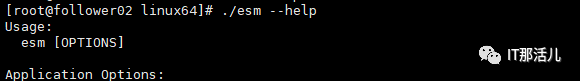

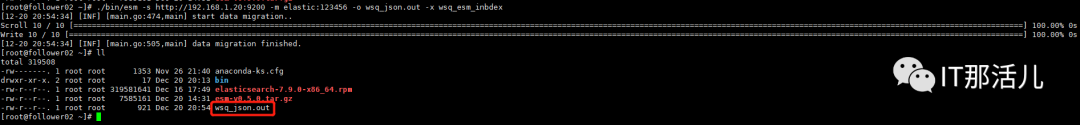

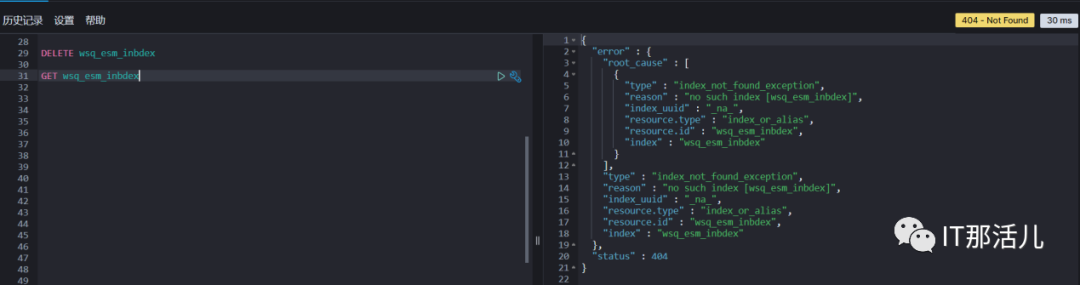

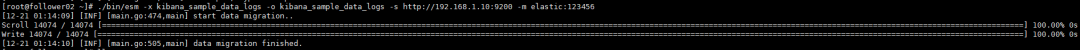

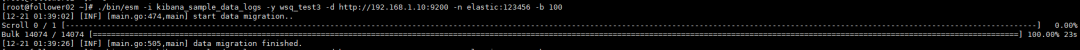

实验案例

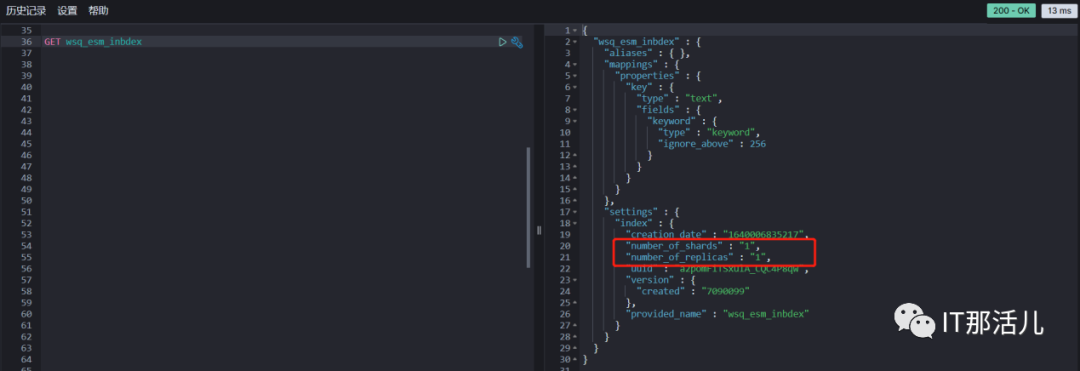

./bin/esm -s http://192.168.1.20:9200 -m elastic:123456 -o wsq_json.out -x wsq_esm_inbdex

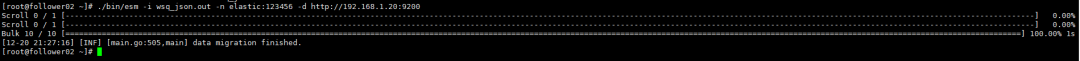

./bin/esm -i wsq_json.out -n user:paswd -d http://192.168.1.20:9200

03

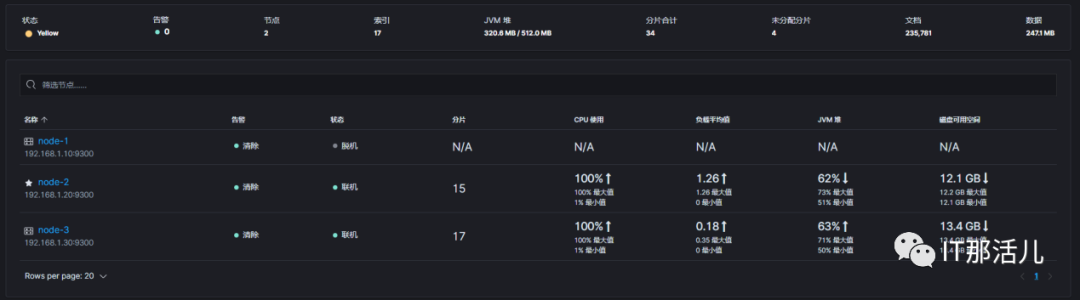

总结分析

end

本文作者:王思强

本文来源:IT那活儿(上海新炬王翦团队)

文章转载自IT那活儿,如果涉嫌侵权,请发送邮件至:contact@modb.pro进行举报,并提供相关证据,一经查实,墨天轮将立刻删除相关内容。