本文首发于 Nebula Graph 官网:https://nebula-graph.com.cn/posts/how-to-deploy-nebula-graph-in-kubernetes/

Kubernetes 是什么

Kubernetes 是一个开源的,用于管理云平台中多个主机上的容器化的应用,Kubernetes 的目标是让部署容器化的应用简单并且高效,Kubernetes 提供了应用部署,规划,更新,维护的一种机制。

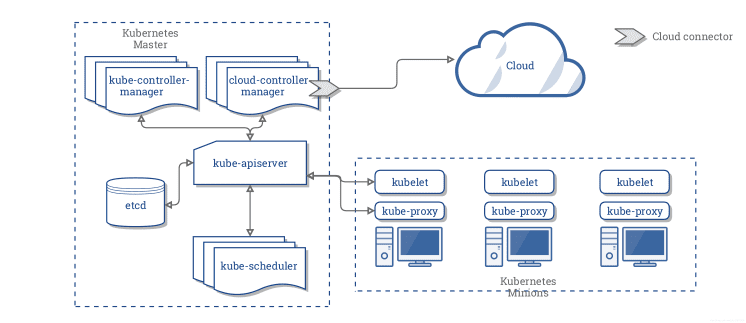

Kubernetes 在设计结构上定义了一系列的构建模块,其目的是为了提供一个可以部署、维护和扩展应用程序的机制,组成 Kubernetes 的组件设计理念为松耦合和可扩展的,这样可以使之满足多种不同的工作负载。可扩展性在很大程度上由 Kubernetes API 提供,此 API 主要被作为扩展的内部组件以及 Kubernetes 上运行的容器来使用。

Kubernetes 主要由以下几个核心组件组成:

etcd保存了整个集群的状态kube-apiserver提供了资源操作的唯一入口,并提供认证、授权、访问控制、API 注册和发现等机制kube-controller-manager负责维护集群的状态,比如故障检测、自动扩展、滚动更新等kube-scheduler负责资源的调度,按照预定的调度策略将Pod调度到相应的机器上kubelet负责维护容器的生命周期,同时也负责 Volume和网络的管理kube-proxy负责为 Service 提供 cluster 内部的服务发现和负载均衡

Kubernetes 和数据库

数据库容器化是最近的一大热点,那么 Kubernetes 能为数据库带来什么好处呢?

- 故障恢复:Kubernetes 提供故障恢复的功能,数据库应用如果宕掉,Kubernetes 可以将其自动重启,或者将数据库实例迁移到集群中其他节点上

- 存储管理:Kubernetes 提供了丰富的存储接入方案,数据库应用能透明地使用不同类型的存储系统

- 负载均衡:Kubernetes Service 提供负载均衡功能,能将外部访问均衡到不同的数据库实例副本上

- 水平拓展:Kubernetes 可以根据当前数据库集群的资源利用率情况,缩放副本数目,从而提升资源的利用率

目前很多数据库,如:MySQL,MongoDB 和 TiDB 在 Kubernetes 集群中都能运行良好。

Nebula Graph 在 Kubernetes 中的实践

Nebula Graph 是一个分布式的开源图数据库,主要组件有:Query Engine 的 graphd,数据存储的 storaged,和元数据的 meted。在 Kubernetes 实践过程中,它主要给图数据库 Nebula Graph 带来了以下的好处:

- Kubernetes 能均衡 nebula graphd,metad 和 storaged 不同副本之间的负载。graphd,metad 和 storaged 可以通过 Kubernetes 的域名服务自动发现彼此。

- 通过 StorageClass,PVC 和 PV 可以屏蔽底层存储细节,无论使用本地卷还是云盘,Kubernetes 均可以透明对接。

- 通过 Kubernetes 可以在数秒内成功部署一套 Nebula 集群,Kubernetes 也可以无感知地实现 Nebula 集群的升级。

- Nebula 集群通过 Kubernetes 可以做到自我恢复,单体副本 crash,Kubernetes 可以重新将其拉起,无需运维人员介入。

- Kubernetes 可以根据当前 Nebula 集群的资源利用率情况弹性伸缩集群规模,从而提升集群的性能。

下面来讲解下具体的实践内容。

集群部署

硬件和软件要求

这里主要罗列下本文部署涉及到的机器、操作系统参数

- 操作系统使用的 CentOS-7.6.1810 x86_64

- 虚拟机配置

- 4 CPU

- 8G 内存

- 50G 系统盘

- 50G 数据盘 A

- 50G 数据盘 B

- Kubernetes 集群版本 v1.14+

- Nebula 版本为 v2.0.0-rc1

- 使用本地 PV 作为数据存储

- CoreDNS 版本 1.6.0+

K8s 集群规划

以下为集群清单

| 服务器 IP | nebula 实例 | role |

|---|---|---|

| 192.168.0.1 | master | |

| 192.168.0.2 | graphd, metad-0, storaged-0 | node |

| 192.168.0.3 | graphd, metad-1, storaged-1 | node |

| 192.168.0.4 | graphd, metad-2, storaged-2 | node |

K8s 待部署组件

- 安装 Helm3

- 准备本地磁盘,并安装本地卷插件

- 安装 nebula 集群

安装 Helm3

Helm 是 Kubernetes 集群上的包管理工,使用 Helm 可以极大地降低使用 Kubernetes 部署应用的门槛。本文不做 Helm 详细介绍,有兴趣的小伙伴可自行阅读《Helm 入门指南》。

下载安装 Helm

使用下面命令在终端执行即可安装 Helm

$ wget https://get.helm.sh/helm-v3.5.2-linux-amd64.tar.gz $ tar -zxvf helm/helm-v3.5.2-linux-amd64.tgz $ mv linux-amd64/helm /usr/bin/helm

查看 Helm 版本

执行 helm version 命令即可查看对应的 Helm 版本,以文本为例,以下为输出结果:

version.BuildInfo{Version:"v3.5.2", GitCommit:"167aac70832d3a384f65f9745335e9fb40169dc2", GitTreeState:"dirty", GoVersion:"go1.15.7"}

设置本地磁盘

在每台机器上做如下配置

创建 mount 目录

$ sudo mkdir -p /mnt/disks

格式化数据盘

$ sudo mkfs.ext4 /dev/diskA $ sudo mkfs.ext4 /dev/diskB

挂载数据盘

$ DISKA_UUID=$(blkid -s UUID -o value /dev/diskA)

$ DISKB_UUID=$(blkid -s UUID -o value /dev/diskB)

$ sudo mkdir /mnt/disks/$DISKA_UUID

$ sudo mkdir /mnt/disks/$DISKB_UUID

$ sudo mount -t ext4 /dev/diskA /mnt/disks/$DISKA_UUID

$ sudo mount -t ext4 /dev/diskB /mnt/disks/$DISKB_UUID

$ echo UUID=`sudo blkid -s UUID -o value /dev/diskA` /mnt/disks/$DISKA_UUID ext4 defaults 0 2 | sudo tee -a /etc/fstab

$ echo UUID=`sudo blkid -s UUID -o value /dev/diskB` /mnt/disks/$DISKB_UUID ext4 defaults 0 2 | sudo tee -a /etc/fstab

部署本地卷插件

$ curl https://github.com/kubernetes-sigs/sig-storage-local-static-provisioner/archive/v2.4.0.zip $ unzip v2.4.0.zip

修改 v2.4.0/helm/provisioner/values.yaml classes 部分:

- 将

hostDir: /mnt/fast-disks改成hostDir: /mnt/disks,# storageClass: true改成storageClass: true。然后执行:

$ helm install local-static-provisioner --namespace default sig-storage-local-static-provisioner/helm/provisioner

# 查看 local-static-provisioner 部署情况

$ helm list

NAME NAMESPACE REVISION UPDATED STATUS CHART APP VERSION

local-volume-provisioner default 1 2021-02-10 11:06:34.3540341 +0800 CST deployed provisioner-2.4.0 2.4.0

部署 nebula 集群

下载 nebula helm chart

# 下载 nebula chart

$ helm repo add nebula-charts https://vesoft-inc.github.io/nebula-docker-compose

$ helm pull nebula-charts/nebula

$ tar -zxvf nebula-v2.0.0.tgz

设置 Kubernetes node节点

下面是 Kubernetes 节点列表,我们需要设置 node 节点的调度标签。可以将 192.168.0.2,192.168.0.3,192.168.0.4 打上 nebula: "cloud" 的标签。

| 服务器 IP | kubernetes roles | nodeName |

|---|---|---|

| 192.168.0.1 | master | 192.168.0.1 |

| 192.168.0.2 | node | 192.168.0.2 |

| 192.168.0.3 | node | 192.168.0.3 |

| 192.168.0.4 | node | 192.168.0.4 |

具体操作如下:

$ kubectl label node 192.168.0.2 nebula="cloud" --overwrite

$ kubectl label node 192.168.0.3 nebula="cloud" --overwrite

$ kubectl label node 192.168.0.4 nebula="cloud" --overwrite

调整 values 默认值

nebula helm chart 目录如下:

nebula ├── Chart.yaml ├── README.md ├── templates │ ├── configmap.yaml │ ├── deployment.yaml │ ├── _helpers.tpl │ ├── NOTES.txt │ ├── pdb.yaml │ ├── serviceaccount.yaml │ ├── service.yaml │ └── statefulset.yaml └── values.yaml 1 directory, 11 files

可以根据运行环境需求修改 charts/nebula/values.yaml 里面的默认值

通过 helm 安装 nebula

$ helm install nebula charts/nebula

# 查看部署状态

$ helm status nebula

NAME: nebula

LAST DEPLOYED: Fri Feb 19 12:58:16 2021

NAMESPACE: default

STATUS: deployed

REVISION: 1

TEST SUITE: None

NOTES:

Nebula Graph Cluster installed!

1. Watch all containers come up.

$ kubectl get pods --namespace=default -l app.kubernetes.io=nebula -w

# 查看 K8s 集群上 nebula 部署情况

$ kubectl get pods --namespace=default -l app.kubernetes.io=nebula

NAME READY STATUS RESTARTS AGE

nebula-graphd-676cfcf797-4q7mk 1/1 Running 0 6m

nebula-graphd-676cfcf797-whwqp 1/1 Running 0 6m

nebula-graphd-676cfcf797-zn5l6 1/1 Running 0 6m

nebula-metad-0 1/1 Running 0 6m

nebula-metad-1 1/1 Running 0 6m

nebula-metad-2 1/1 Running 0 6m

nebula-storaged-0 1/1 Running 0 6m

nebula-storaged-1 1/1 Running 0 6m

nebula-storaged-2 1/1 Running 0 6m

访问 nebula 集群:

$ kubectl get service nebula-graphd

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

nebula-graphd NodePort 10.105.47.116 <none> 9669:31646/TCP,19669:30554/TCP,19670:32386/TCP 22m

# 使用 nebula-console 测试

$ docker run --rm -ti --entrypoint=/bin/sh vesoft/nebula-console:v2-nightly

# 通过 NodePort 连接到 graphd 组件

/ $ nebula-console -addr 192.168.0.4 -port 31646 -u root -p vesoft

2021/02/19 05:04:55 [INFO] connection pool is initialized successfully

Welcome to Nebula Graph v2.0.0-rc1!

(root@nebula) [(none)]> show hosts;

+---------------------------------------------------------------+------+----------+--------------+----------------------+------------------------+

| Host | Port | Status | Leader count | Leader distribution | Partition distribution |

+---------------------------------------------------------------+------+----------+--------------+----------------------+------------------------+

| "nebula-storaged-0.nebula-storaged.default.svc.cluster.local" | 9779 | "ONLINE" | 0 | "No valid partition" | "No valid partition" |

+---------------------------------------------------------------+------+----------+--------------+----------------------+------------------------+

| "nebula-storaged-1.nebula-storaged.default.svc.cluster.local" | 9779 | "ONLINE" | 0 | "No valid partition" | "No valid partition" |

+---------------------------------------------------------------+------+----------+--------------+----------------------+------------------------+

| "nebula-storaged-2.nebula-storaged.default.svc.cluster.local" | 9779 | "ONLINE" | 0 | "No valid partition" | "No valid partition" |

+---------------------------------------------------------------+------+----------+--------------+----------------------+------------------------+

| "Total" | | | 0 | | |

+---------------------------------------------------------------+------+----------+--------------+----------------------+------------------------+

Got 4 rows (time spent 2608/4258 us)

FAQ

如何搭建一套 Kubernetes 集群?

搭建高可用的 Kubernetes 可以参考社区文档:https://kubernetes.io/docs/setup/production-environment/tools/kubeadm/high-availability/

如何调整 nebula 集群的部署参数?

在使用 helm install 时,使用 --set 可以设置部署参数,从而覆盖掉 helm chart 中 values.yaml 中的变量。参考文档:https://helm.sh/docs/intro/using_helm/

能否兼容 nebula v1.0.0+ 集群部署?

v1.0.0+ 不支持内部域名解析,需要修改 charts/nebula/values.yaml,配置如下:

hostNetwork: true

metadEndpoints: []

- 192.168.0.2:9559

- 192.168.0.3:9559

- 192.168.0.4:9559

如何在 K8s 集群外部访问 nebula 内部组件?

本文使用 NodePort 的方式访问 graphd 组件,其他的访问方式还有 hostPort、hostNetwork、Ingress、LoadBalancer,需要您根据实际的部署环境来定制。

如何查看 nebula 集群状况?

使用kubectl get pods --namespace=default -l app.kubernetes.io=nebula命令,或者直接在 Kubernetes dashboard 上查看 nebula 集群的运行状况。

如何使用其他类型的存储?

参考文档:https://kubernetes.io/zh/docs/concepts/storage/storage-classes/