ICML 2022 | Local Augmentation for Graph Neural Networks

“文章信息

来源:Proceedings of the 39th International Conference on Machine Learning(ICML) 2022

”

标题:Local Augmentation for Graph Neural Networks

作者:Songtao Liu, Rex Ying, Hanze Dong, Lanqing Li, Tingyang Xu, Yu Rong, Peilin Zhao, Junzhou Huang, Dinghao Wu

链接:https://proceedings.mlr.press/v162/liu22s.html

代码:https://github.com/SongtaoLiu0823/LAGNN

内容简介

图神经网络(GNN)在基于图的任务上取得了显著的性能。GNN 的关键思想是通过聚合来自本地邻域的信息来获得信息表示。然而,邻域信息是否被充分聚合以学习具有少数邻居的节点的表示仍然是一个悬而未决的问题。为了解决这个问题,本文提出了一种简单有效的数据增强策略,局部增强,以学习以中心节点表示为条件的邻居节点表示的分布,并通过生成的特征增强 GNN 的表达能力。局部增强是一个通用框架,可以以即插即用的方式应用于任何 GNN 模型。它从学习的条件分布中对与每个节点相关联的特征向量进行采样,作为每次训练迭代中主干模型的附加输入。广泛的实验和分析表明,当应用于各种基准的各种 GNN 架构时,局部增强始终会产生性能改进。例如,实验表明,在 Cora、Citeseer 和 Pubmed 上的测试准确性方面,将局部增强插入 GCN 和 GAT 平均提高了 3.4% 和 1.6%。此外,本文在大图(OGB)上的实验结果表明模型持续提高了骨干网的性能。

作者认为,局部邻域中有限数量的邻居限制了 GNN 的表达能力并阻碍了它们的性能,尤其是在某些节点的邻居很少的样本匮乏情况下。堆叠图层以扩大感受野可以合并多跳相邻信息,但会导致过度平滑(Li et al., 2018)而没有与输入的残余连接,并且不是解决此问题的直接解决方案。现有的 GNN 模型架构工作无法解决非常有限的邻居不利于学习节点表示的问题。因此,本文专注于丰富低度节点的局部信息以获得有效的表示。

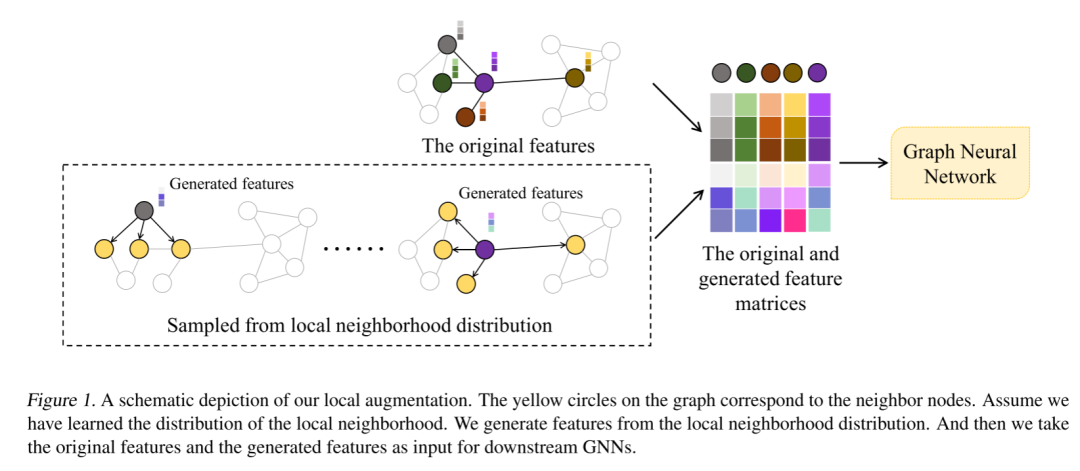

为了促进在本地邻域中生成更多样本的聚合方案,本文提出了一种新颖高效的数据增强框架:图神经网络的局部增强 (LA-GNN)。术语“局部增强”是指通过以局部结构和节点特征为条件的生成模型生成邻域特征。具体来说,本文提出的框架包括一个预训练步骤,该步骤通过生成模型学习给定一个中心节点特征的连接邻居节点特征的条件分布。如下图所示,然后利用该分布生成与该中心节点相关的特征向量,作为每次训练迭代的附加输入。此外,将生成模型的预训练和下游 GNN 训练解耦,允许数据增强模型以即插即用的方式应用于任何 GNN 模型。 本文的主要贡献如下:

本文的主要贡献如下:

本文提出了一种通用的增强策略,以在局部邻域中生成更多特征,以增强现有 GNN 的表达能力; 本文探索了图的预训练生成模型以提高下游任务性能的新方向; 本文提出的框架是灵活的,可以应用于各种流行的骨干网。广泛的实验结果表明,本文提出的框架可以提高 GNN 变体在不同基准数据集上的性能。

准备工作

许多流行的图神经网络 (GNN) 直接对图结构进行操作,并通过图节点之间的消息传递来捕获图的依赖关系。他们反复聚合节点 的表示,并将聚合的信息与其表示向量结合起来,得到一个表示向量 。GNN 消息传递方案的第 层是:

其中COM(·)和AGG(·)分别表示COMBINE和AGGREGATE函数,是节点 在第 层的表示向量, 是节点 和节点 之间的边向量. 具体来说,。

图神经网络的局部增强(LAGNN)

局部增强

动机:现有的 GNN 专注于设计一种消息传递方案,以利用局部信息来获取节点表示。作者探索了一个新的方向,即可以在局部邻域中生成更多样本,特别是对于具有较少邻居的节点,以增强各种 GNN 的表达能力。为了在节点 的邻域 中产生更多样本,需要知道其邻居节点表示的分布。由于这个分布与中心节点 有关,可以通过生成模型根据中心节点的表示来学习它。

效果:与为每个节点训练生成模型相比,为所有节点训练单个生成模型有三个好处 1)通过生成模型学习图上所有节点的条件分布降低了计算成本。2)在生成阶段,可以应用特定节点的特征向量作为输入(条件)并生成与该节点相关的特征向量。3)具有更好的可扩展性和泛化性。对于添加到动态图中的新节点,可以直接生成特征向量,而无需重新训练新的生成模型,因为生成模型包含这样的泛化信息。所以局部增强模型可以应用于归纳学习任务,例如图分类。

方法:作者利用条件变分自动编码器 (CVAE) (Kingma & Welling, 2013; Sohn et al., 2015) 来学习给定中心节点 的连接邻居 的节点特征的条件分布。关于CVAE设置,作者使用 作为条件,因为 的分布与 有关。潜在变量 是从先验分布 生成的,数据 是通过以 和 为条件的生成分布 生成的:,。令 表示变分参数, 表示生成参数,存在如下关系:

并且证据下界(ELBO)可以写成:

将生成模型训练与下游图学习解耦

大多数现有的 GNN 模型都遵循消息传递机制 (Gilmer et al., 2017),可以看作是学习的分类或回归函数。为了进行预测,GNN 模型需要估计关于图结构 和特征矩阵 的后验分布 。例如,·可以是节点分类任务上的类标签 。可以使用最大似然估计 (MLE) 通过优化以下似然函数来估计参数 :

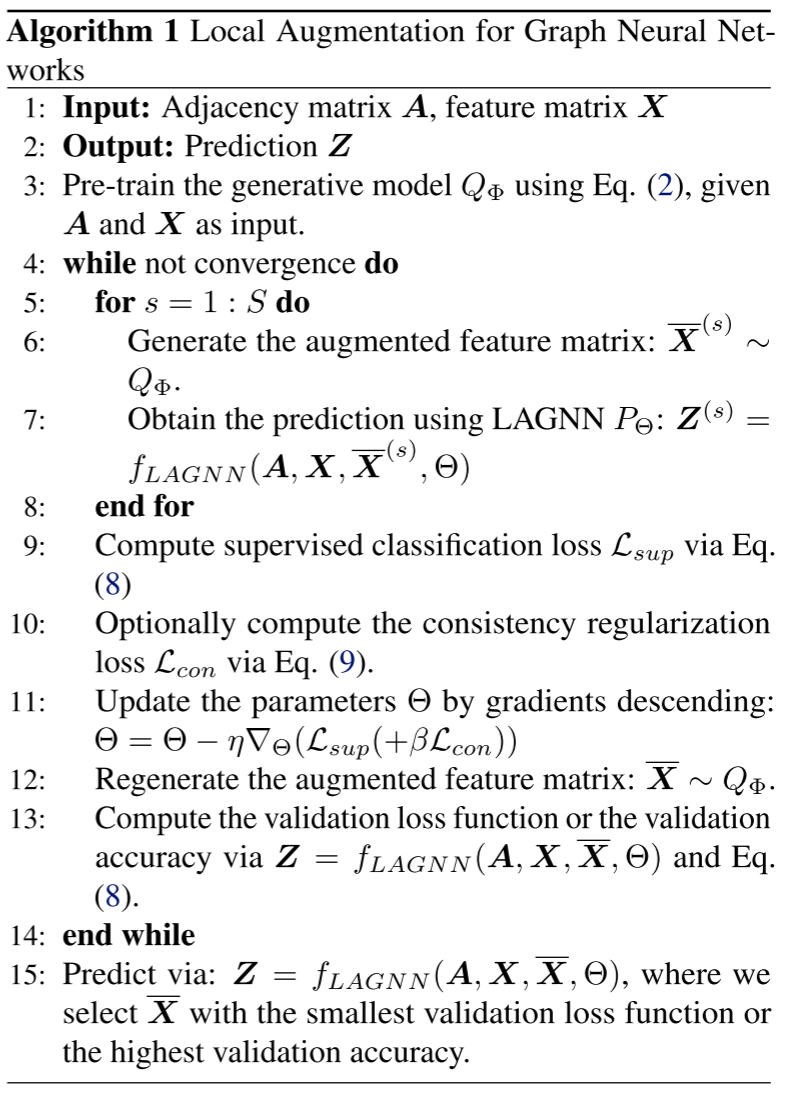

训练过程

本文的训练和推理过程的细节在下图算法中进行了概述: 首先,训练 CVAE,即局部增强模型。然后在每次训练迭代中采样一个由 CVAE 生成的不同特征矩阵作为附加输入来训练 GNN 模型。但是对于 GRAND (Feng et al., 2020),作者只在训练阶段对一个特征矩阵进行采样,因为作者研究发现使用这种采样策略可以获得更好的性能。

首先,训练 CVAE,即局部增强模型。然后在每次训练迭代中采样一个由 CVAE 生成的不同特征矩阵作为附加输入来训练 GNN 模型。但是对于 GRAND (Feng et al., 2020),作者只在训练阶段对一个特征矩阵进行采样,因为作者研究发现使用这种采样策略可以获得更好的性能。

实验分析

本文评估了局部增强模型在各种任务上的性能,包括节点分类、链接预测和图分类。所有的实验都是在开放的图数据集上进行的。

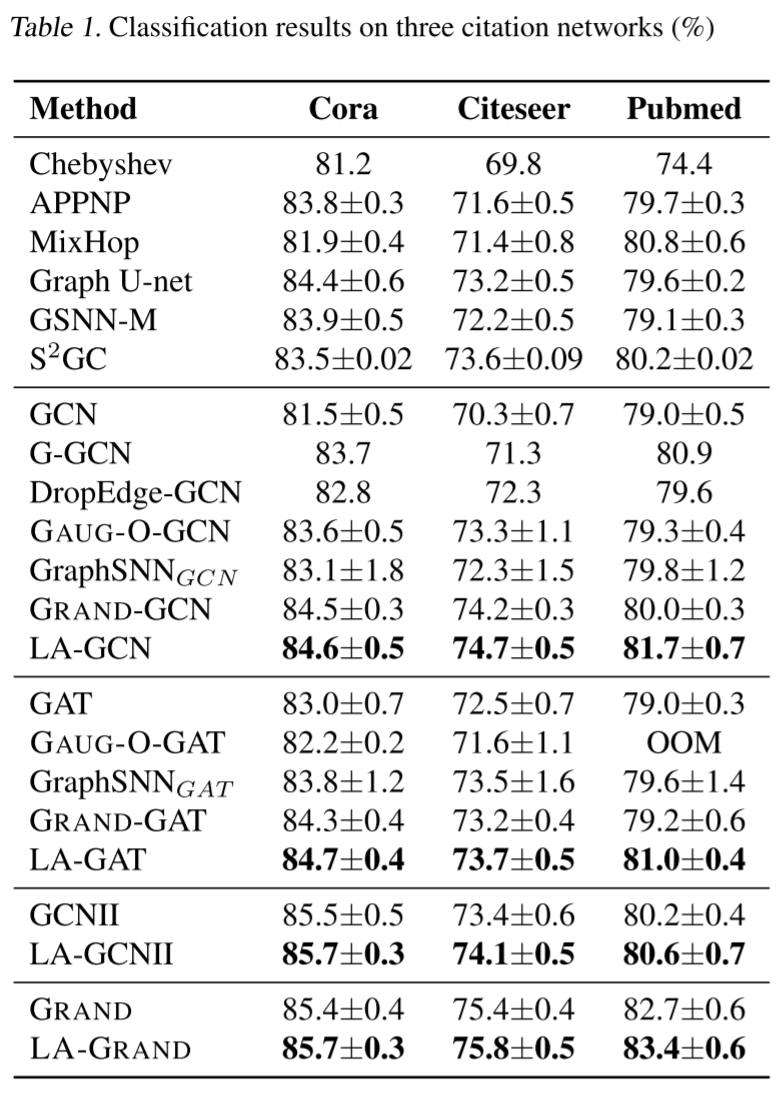

半监督学习

本文在下表中报告了 100 次运行后的平均节点分类精度。作者重用了相应论文中已经报告的基线指标。结果表明,配备本文方法的主干模型在所有三个数据集上都取得了更好的性能。

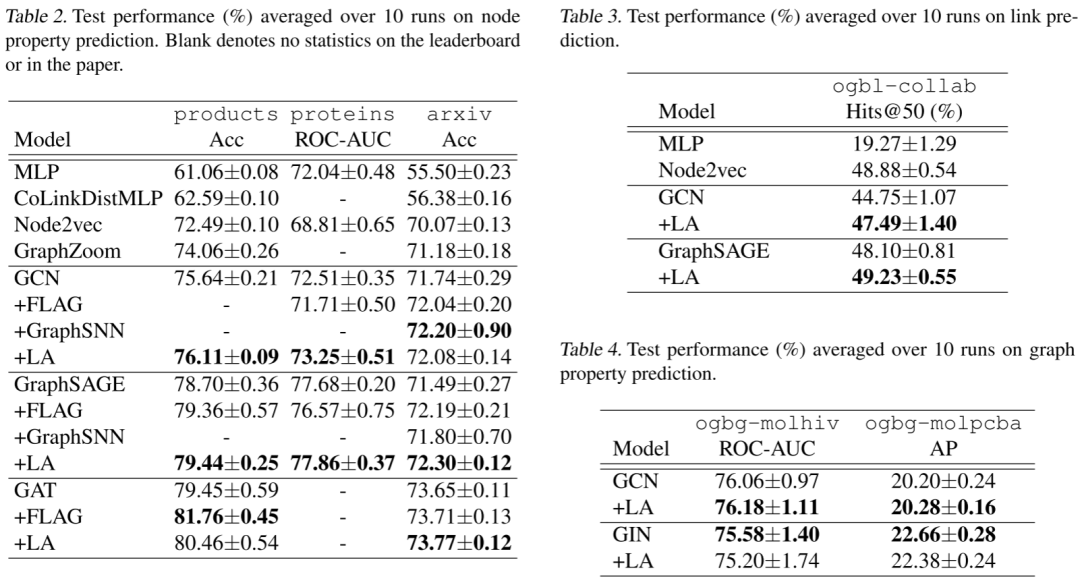

全监督学习

本文遵循 OGB 中的实验设置 (Hu et al., 2020)。对于详细的设置,例如拆分比率和评估指标,只需遵循 OGB 实现中的相同设置。请注意,基线的测试结果来自官方 OGB 排行榜网站或相应论文。为了公平比较,作者从开放资源代码中实现 OGB 任务模型,只触及第一层。实验结果总结在下表中。按照惯例,作者报告了与最佳验证性能相关的测试准确性。节点和链路预测的结果表明,本文增强模型始终如一地提高了骨干网的性能。

总结

本文提出了局部增强,这是一种利用生成模型来学习给定中心节点特征的中心节点邻居特征的条件分布的新技术。作者将生成的特征矩阵从训练有素的生成模型馈送到一些修改过的主干 GNN 模型,以提高它们的性能。实验表明,本文模型可以提高各种 GNN 架构和基准数据集的性能。此外,本文模型在各种半监督节点分类任务上取得了新的最先进的结果。本文提出的框架的一个限制是不利用 2 跳邻居或使用随机游走来为中心节点找到更多相关的邻居。未来的一项工作是如果中心节点的度数较小,则提取更多的 2/3 跳邻居,如果图较大,则学习随机采样节点的条件分布。