点击上方“IT那活儿”公众号,关注后了解更多内容,不管IT什么活儿,干就完了!!!

Ceph OSD Daemon将数据写入磁盘和日志。因此,需要为 OSD 提供一个磁盘和日志分区的路径(即,这是最常见的配置,也可以根据自己的需要配置系统)。

准备工作

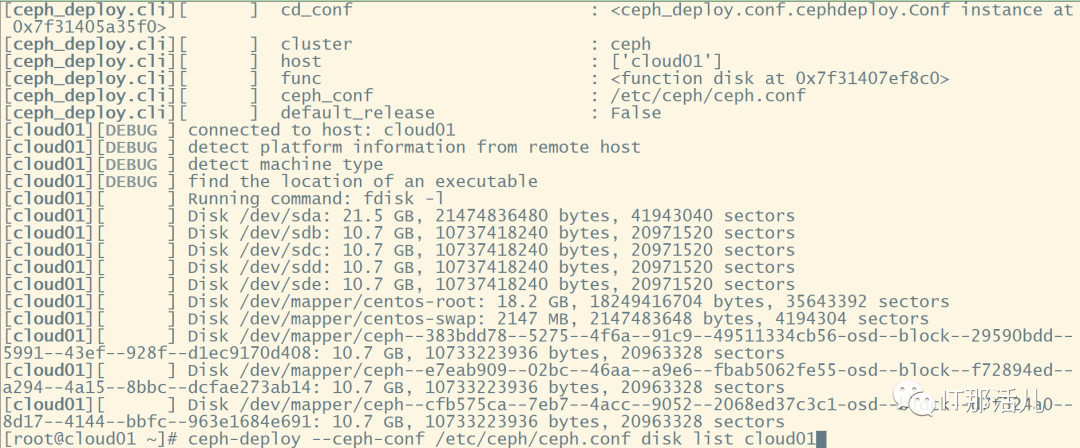

ceph-deploy disk list {node-name [node-name]...}复制

ceph-deploy disk zap {osd-server-name} {disk-name}

ceph-deploy disk zap osdserver1 dev/sdb

ceph-deploy disk zap osdserver1 dev/sdb dev/sdc dev/sdd复制

ceph-deploy osd create --data {data-disk} {node-name}复制

ceph-deploy osd create --data /dev/ssd osd-server1复制

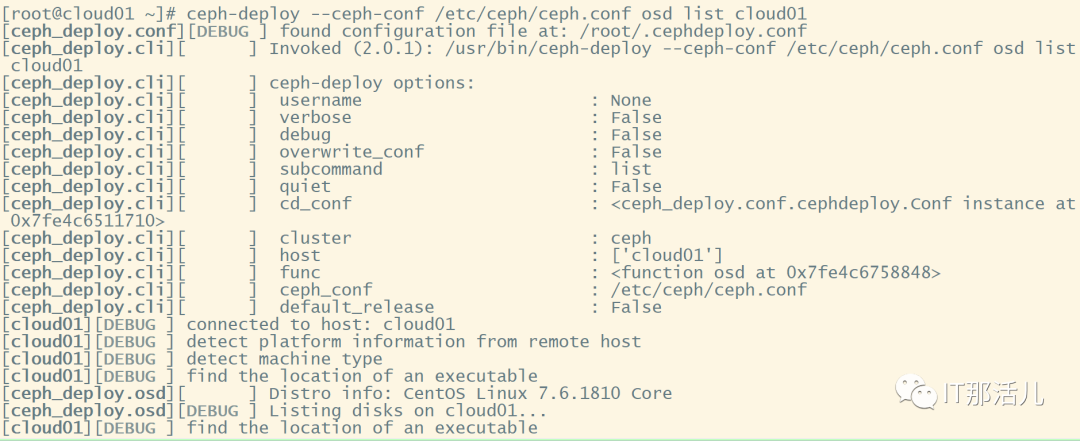

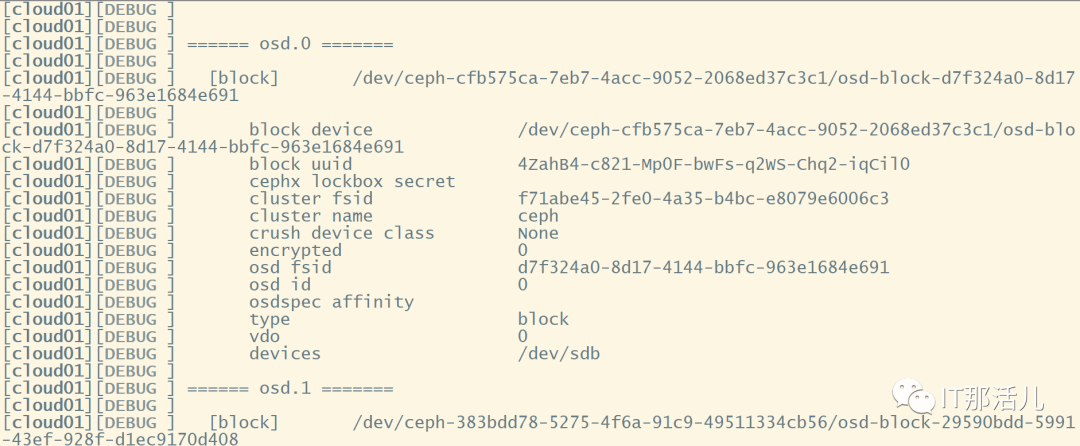

ceph-deploy osd list {node-name}复制

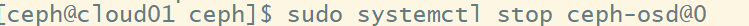

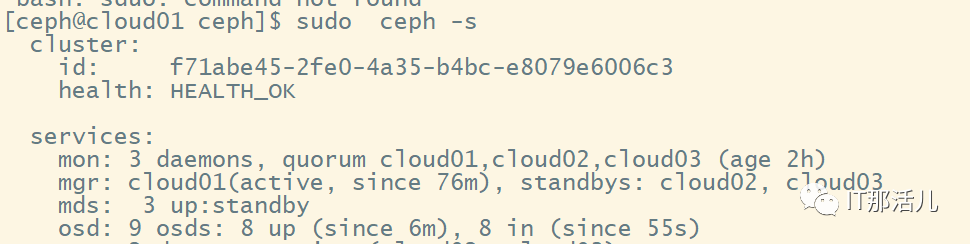

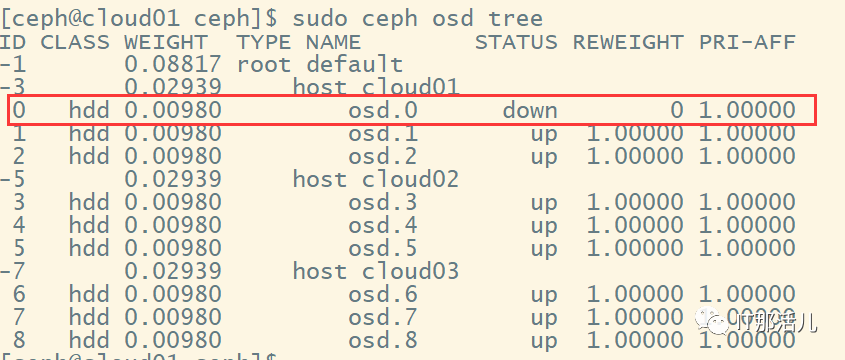

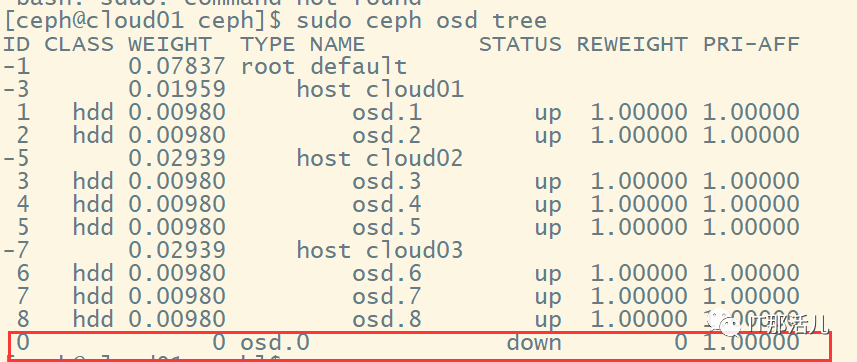

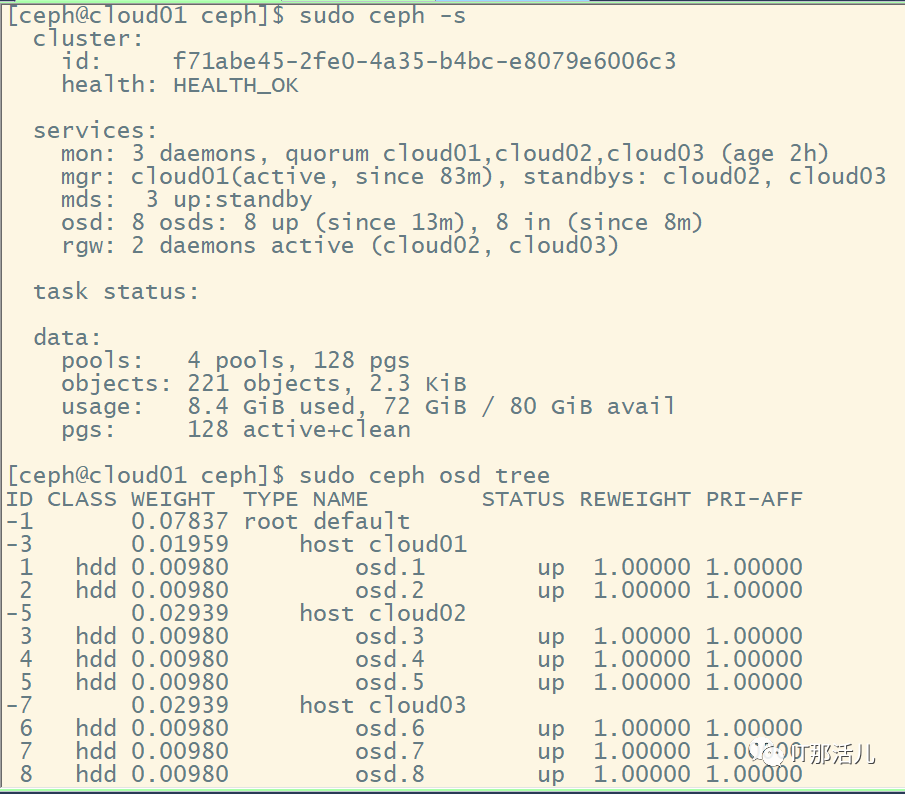

删除osd

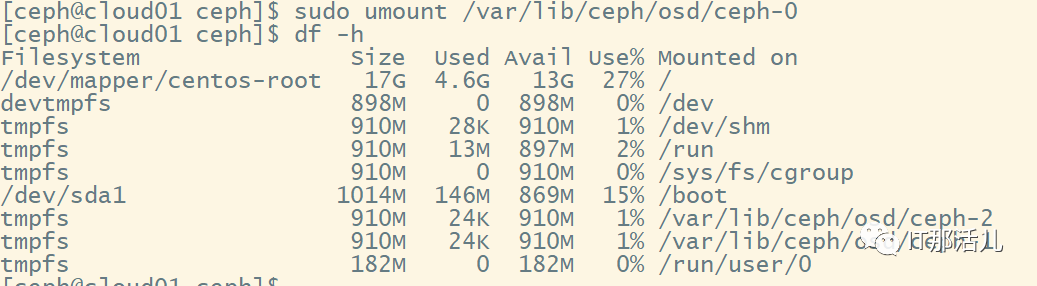

sudo systemctl stop ceph-osd@0

复制

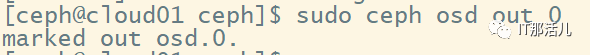

sudo ceph osd out 0复制

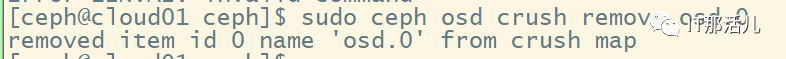

sudo ceph osd crush remove osd.0复制

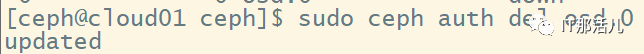

sudo ceph auth del osd.0复制

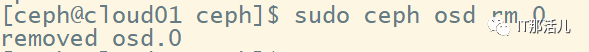

sudo ceph osd rm 0复制

umount /var/lib/ceph/osd/ceph-0复制

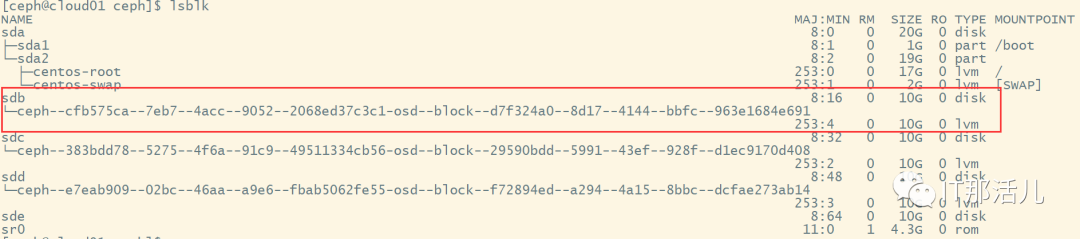

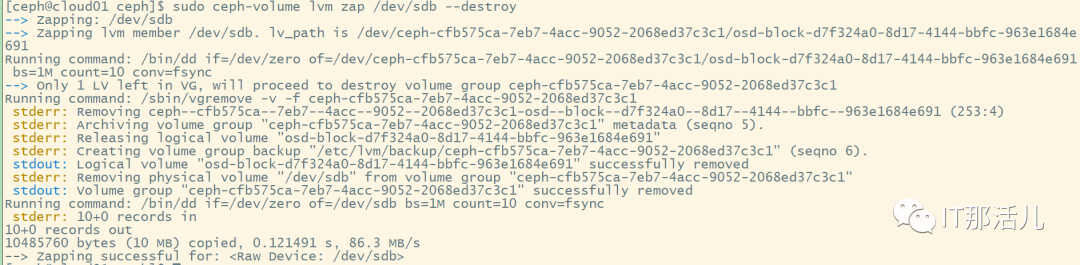

sudo ceph-volume lvm zap /dev/sdb --destroy复制

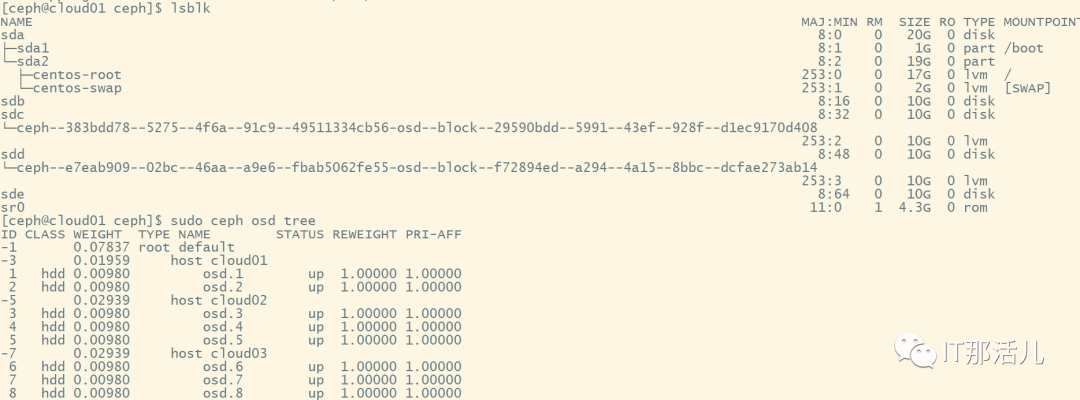

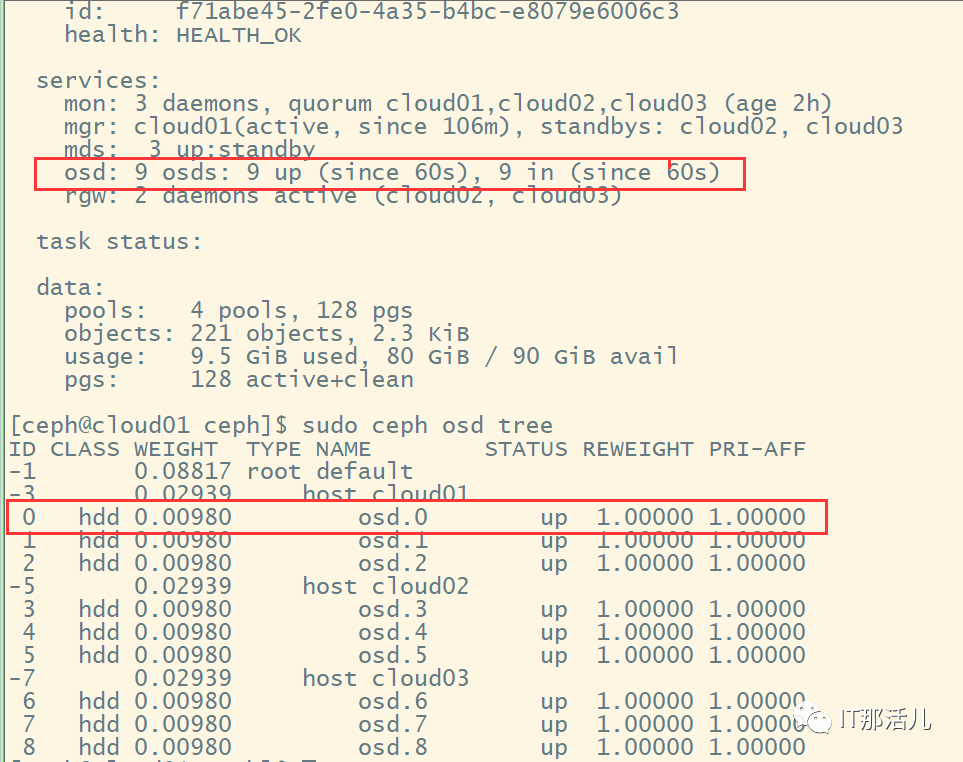

恢复/添加回osd

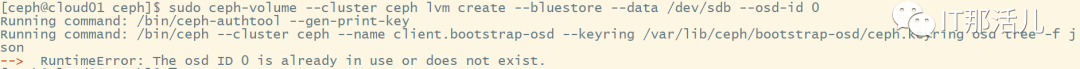

sudo ceph-volume --cluster ceph lvm create --bluestore --data /dev/sdb --osd-id 0复制

The osd ID 0 is already in use or does not exist.复制

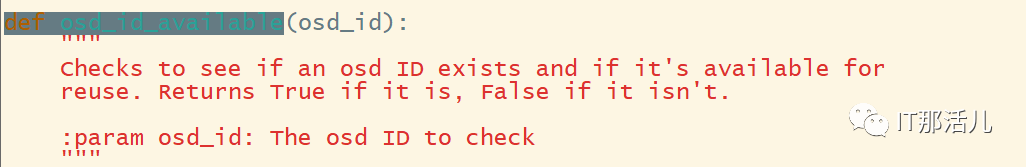

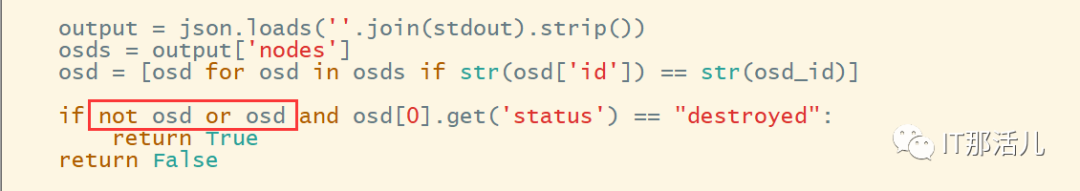

vi /usr/lib/python2.7/site-packages/ceph_volume/util/prepare.py复制

not osd or复制

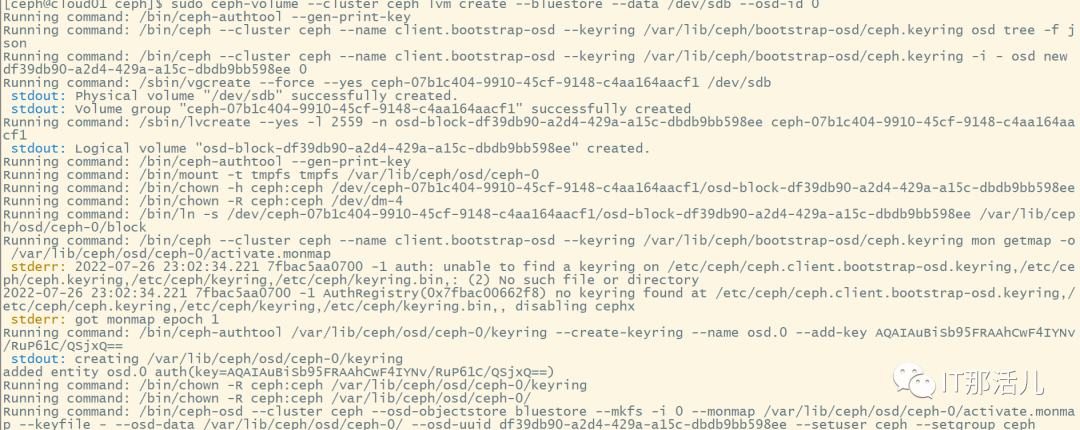

sudo ceph-volume --cluster ceph lvm create --bluestore --data /dev/sdb --osd-id 0复制

本文作者:王思强(上海新炬王翦团队)

本文来源:“IT那活儿”公众号

文章转载自IT那活儿,如果涉嫌侵权,请发送邮件至:contact@modb.pro进行举报,并提供相关证据,一经查实,墨天轮将立刻删除相关内容。

评论

相关阅读

Linux日志管理-Rsyslog简介

IT那活儿

30次阅读

2025-03-31 10:00:43

oracle安装与配置

芃芃

29次阅读

2025-04-08 19:06:10

OceanBase挂载NFS磁盘

IT那活儿

18次阅读

2025-04-11 15:34:20

UEFI深度解析

老柴杂货铺

15次阅读

2025-04-04 18:44:11

Linux 时区选择与配置指南

老柴杂货铺

10次阅读

2025-04-10 15:41:40

MinIO高性能对象存储安装手册

老柴杂货铺

10次阅读

2025-04-13 00:14:52

安装完操作系统后建议做这些优化工作!

运维李哥不背锅

10次阅读

2025-04-02 09:35:00

CEPH参数Deep Scrub引发的故障

IT那活儿

10次阅读

2025-04-07 09:44:51