引言

Hadoop保姆级部署手册-2-安装前准备工作

Hadoop保姆级部署手册-3-部署hadoop集群

公众号回复关键字“hadoop”获取最新hadoop保姆级部署手册,一起从头开始操练起来

4、集群可用性验证

4.1、hdfs验证

4.1.1、上传文件

#上传小文件

hadoop fs -mkdir input hadoop fs -put data/jpsall input |

备注:将本地路径/data/jpsall文件上传到hdfs的/input文件夹

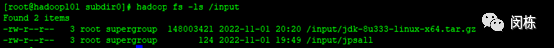

#上传大文件

hadoop fs -put /data/jdk-8u333-linux-x64.tar.gz /input |

备注:将本地路径/data/jdk-8u333-linux-x64.tar.gz文件上传到hdfs的/input文件夹下

4.1.2、上传文件后查看文件存放在什么位置

4.1.2.1、hdfs命令查看本地文件是否上传成功

通过hadoop fs -ls /input 命令查看:

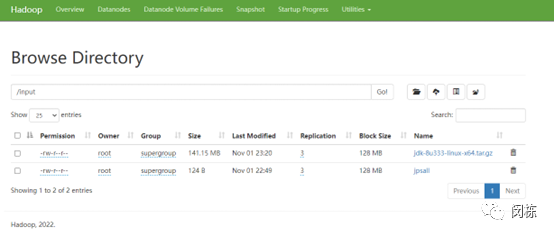

4.1.2.2、网页查看HDFS文件存储路径

通过http://hadoop101:9870/explorer.html#/input页面可以查看jpsall是否上传成功

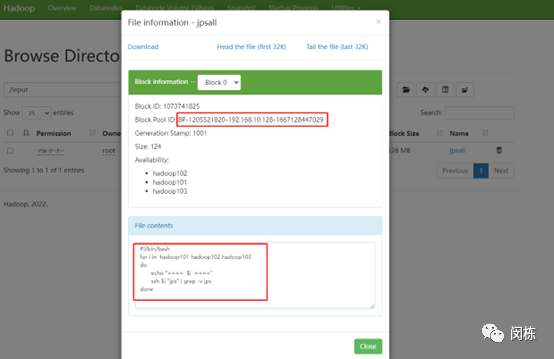

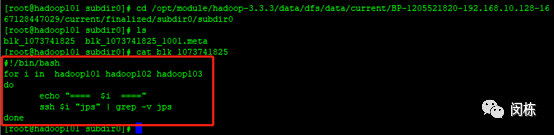

4.1.2.3、本地查看HDFS文件存储路径

本地查看HDFS文件存储路径,在路径/opt/module/hadoop-3.3.3/data/dfs/data/current下面逐层寻找,

大致路径如:

/opt/module/hadoop-3.3.3/data/dfs/data/current/BP-1205521820-192.168.10.128-1667128447029/current/finalized/subdir0/subdir0

备注: 文件路径中斜体和上图中Block Pool ID一致。

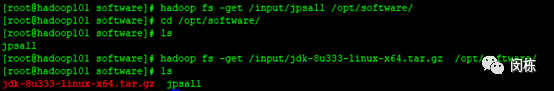

4.1.3、下载文件

#下载jpsall到本地/opt/software文件夹下

hadoop fs -get /input/jpsall /opt/software/ |

#下载jdk-8u333-linux-x64.tar.gz到到本地/opt/software文件夹下

hadoop fs -get /input/jdk-8u333-linux-x64.tar.gz /opt/software/ |

如下图:

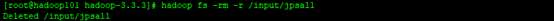

4.1.4、删除文件

#删除hdfs上jpsall文件

hadoop fs -rm -r /input/jpsall |

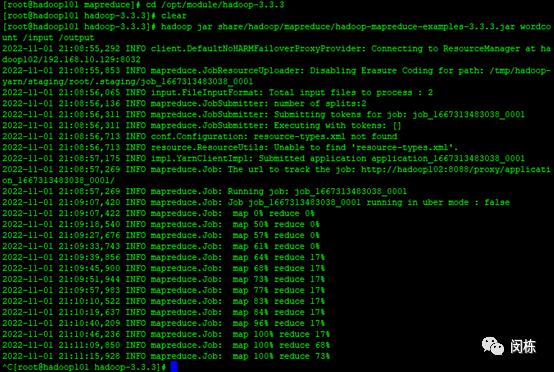

4.1.5、执行mapreduce任务-wordcount程序

#在hadoop安装路径下执行wordcount程序

cd /opt/module/hadoop-3.3.3 hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-3.3.3.jar wordcount /input /output |

4.1.6、hdfs常用命令

1、查看帮助 hadoop fs -help 2、查看目录信息 hadoop fs -ls /hdfs路径 3、上传文件到hdfs上 hadoop fs -put /本地路径/文件名/hdfs路径 4、上传文件夹到hdfs上 hadoop fs -put /本地路径/文件夹名/hdfs路径 5、从hdfs上删除文件 hadoop fs -rm -r /hdfs路径/文件名 6、从hdfs上删除文件夹 hadoop fs -rm -r /hdfs路径/文件夹名 1、剪切文件 hadoop fs -moveFromLocal a.txt /aa.txt 2、下载文件到本地 hadoop fs -get /hdfs路径/文件名 /本地路径 3、合并下载 hadoop fs -getmerge /hdfs路径文件夹 /合并后的文件 10、创建文件夹 hadoop fs -mkdir /hello 11、创建多级文件夹 hadoop fs -mkdir -p /hello/world 12、移动hdfs文件 hadoop fs -mv /hdfs路径 /hdfs路径 13、复制hdfs文件 hadoop fs -cp /hdfs路径 /hdfs路径 14、查看hdfs中的文件 hadoop fs -cat / hdfs路径/文件 hadoop fs -tail -f / hdfs路径/文件 15、查看文件夹中有多少个文件 hadoop fs -count / hdfs路径/文件夹 16、查看hdfs的总空间 hadoop fs -df / hadoop fs -df -h / 17、修改副本数 hadoop fs -setrep 1 / hdfs路径/a.txt |

4.2、mapreduce验证

4.2.1、上传大文本文件到hdfs路径下

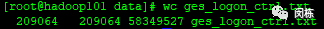

#上传大文本文件ges_logon_ctrl.txt到hadoop101服务器上,使用下面命令统计文件

wc ges_logon_ctrl.txt |

行数为209064

单词个数为:209064

文件大小为:58349527 bytes

#上传改文件到hdfs 的/input路径下

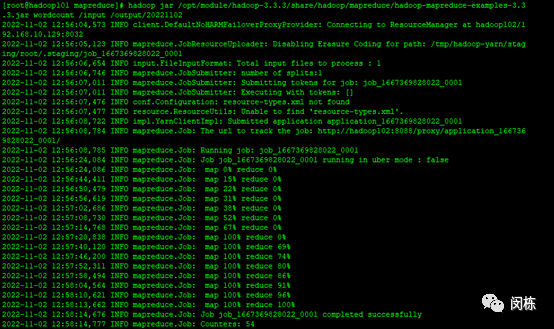

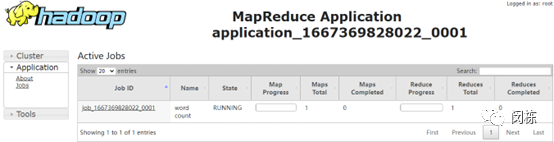

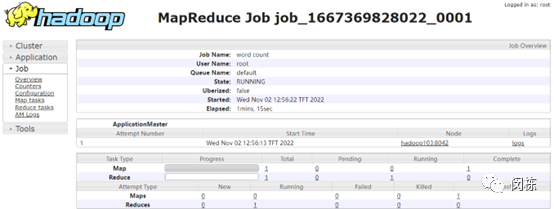

4.2.2、执行mapreduce程序验证

执行下面命令

hadoop jar /opt/module/hadoop-3.3.3/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.3.3.jar wordcount /input /output/20221102 |

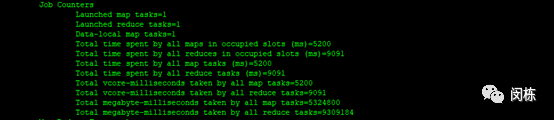

4.2.3、执行结果分析

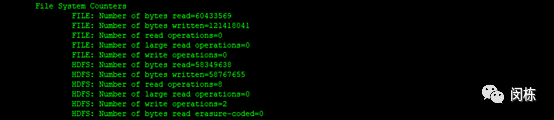

#文件系统信息:

#任务配置信息

1个map任务,1个reduce任务

备注:map个数是由文件大小而定,即为分片的个数,reduce个数配置文件中为1个。

修改reduce配置的个数,配置文件为mapred-sit.xml,其中的配置项为 mapred.reduce.tasks

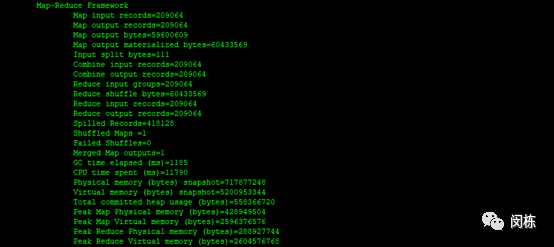

#Map-Reduce的一个整体描述

在reduce输出的记录数为209064,即为209064个不同的单词

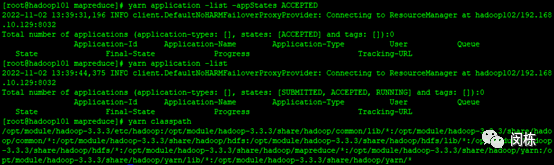

4.3、yarn验证

参考章节 3.4.2.5和3.4.2.6

Hadoop101机器上执行下面命令:

yarn application -list -appStates ACCEPTED yarn application -list yarn classpath |

进一步验证参考网络相关网页