什么是Hive?

- Hive是在Hadoop分布式文件系统上运行的开源分布式数据仓库数据库,用于查询和分析大数据。

- 数据以表格的形式存储(与关系型数据库十分相似)。数据操作可以使用名为HiveQL的SQL接口来执行。

- HiveQL默认情况下会转换成MapReduce进行计算(降低了开发难度),所以比较慢,常用于做离线数据分析场景,不适合做实时查询。

为什么选择Hive?

- Hive是运行在Hadoop上的SQL接口。此外,它还降低了使用MapReduce框架编程的复杂性。

- Hive帮助企业在HDFS上执行大规模数据分析,使其成为一个水平可伸缩的数据库。

- 通过HiveSQL使具有RDBMS背景的开发人员能够快速构建符合自己业务需求的数据仓库。

- Hive直接将数据存储在HDFS系统中,扩容等事宜都交由HDFS系统来维护。

如何将Hive中的分析数据导到业务系统中?

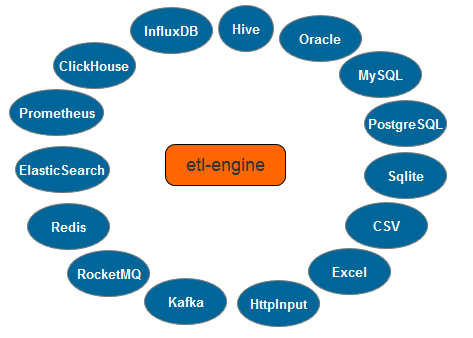

etl-engine支持对Hive的读取,并输出到以下目标数据源:

- 消息中间件(Kafka | RocketMQ);

- 关系型数据库( Oracle | MySQL | PostgreSQL | Sqlite);

- NoSQL(Elasticsearch | Redis);

- 时序数据库( InfluxDB | ClickHouse | Prometheus);

- 文件( Excel );

etl-engine支持None和Kerberos认证方式,适合测试环境及企业应用生产环境中的认证场景。

只需要二步 就完成 读Hive写DB操作

编写配置文件 hive_to_db.grf

<?xml version="1.0" encoding="UTF-8"?>

<Graph>

<Node id="HIVE_READER_01" dbConnection="CONNECT_02"

type="HIVE_READER" desc="读Hive节点1" fetchSize="1000" >

<Script name="sqlScript"><![CDATA[

select uuid,name,height,writetime from db_hive_edu.t_u_info

]]></Script>

</Node>

<Node id="DB_OUTPUT_01" type="DB_OUTPUT_TABLE" desc="写数据表节点1" dbConnection="CONNECT_01" outputFields="uuid;name;height;writetime" renameOutputFields="uuid;name;height;writetime" >

<Script name="sqlScript"><![CDATA[

insert into db1.t_hive_u_info (uuid,name,height,writetime) values (?,?,?,?)

]]></Script>

</Node>

<Line id="LINE_01" type="STANDARD" from="HIVE_READER_01" to="DB_OUTPUT_01" order="0" metadata="METADATA_01"></Line>

<Metadata id="METADATA_01">

<Field name="uuid" type="int" default="-1" nullable="false"/>

<Field name="name" type="string" default="-1" nullable="false"/>

<Field name="height" type="float" default="-1" nullable="false"/>

<Field name="writetime" type="string" default="-1" nullable="false"/>

</Metadata>

<Connection id="CONNECT_02" dbURL="hadoop01:10000" database="db_hive_edu" username="Administrator" password="******" batchSize="1000" type="HIVE"/>

<Connection id="CONNECT_01" dbURL="127.0.0.1:3306" database="db1" username="root" password="******" batchSize="1000" type="MYSQL"/>

<!--

<Connection sortId="1" id="CONNECT_1" type="ORACLE" dbURL="127.0.0.1:1521" database="orcl" username="c##u1" password="******" />

-->

</Graph>

复制执行命令

etl_engine -fileUrl hive_to_db.grf -logLevel debug复制

** 如此简单就完成了 读 hive 数据表 、写 mysql 数据表 操作。**

参考资料

[免费下载](https://github.com/hw2499/etl-engine/releases) [etl-engine使用手册](https://github.com/hw2499/etl-engine) [etl-crontab使用手册](https://github.com/hw2499/etl-engine/wiki/etl-crontab%E8%B0%83%E5%BA%A6) [嵌入脚本开发](https://github.com/hw2499/etl-engine/wiki/%E5%B5%8C%E5%85%A5%E8%84%9A%E6%9C%AC%E5%BC%80%E5%8F%91)复制

最后修改时间:2023-02-28 11:21:32

「喜欢这篇文章,您的关注和赞赏是给作者最好的鼓励」

关注作者

【版权声明】本文为墨天轮用户原创内容,转载时必须标注文章的来源(墨天轮),文章链接,文章作者等基本信息,否则作者和墨天轮有权追究责任。如果您发现墨天轮中有涉嫌抄袭或者侵权的内容,欢迎发送邮件至:contact@modb.pro进行举报,并提供相关证据,一经查实,墨天轮将立刻删除相关内容。

评论

相关阅读

智能问数系统技术架构解析:从自然语言到业务洞察的自动化之路

会飞的一十六

40次阅读

2025-04-14 09:40:51

顺丰科技:从 Presto 到 Doris 湖仓构架升级,提速 3 倍,降本 48%

SelectDB

24次阅读

2025-05-09 16:54:18

大数据从业者必知必会的Hive SQL调优技巧

京东云开发者

18次阅读

2025-04-30 17:10:37

原来可以拖拉拽实现ETL,还兼容Doris!

一臻数据

14次阅读

2025-05-06 10:17:02

Flink自研特性: yarn application运行模式租户权限与yarn本地化资源可见性整合实践总结

大数据从业者

11次阅读

2025-05-07 10:06:03