python代码-基于深度强化学习的微能源网能量管理与优化策略研究

关键词:微能源网;能量管理;深度强化学习;Q-learning;DQN

内容::面向多种可再生能源接入的微能源网,提出一种基于深度强化学习的微能源网能量管理与优化方法。

该方法使用深度 Q 网络(deep Q network,DQN)对预测负荷、风 光等可再生能源功率输出和分时电价等环境信息进行学习,通过习得的策略集对微能源网进行能量管理,是一种模型无关基于价值的智能算法。

这段代码主要是一个强化学习的训练程序,包含了环境模型和智能体模型。

YID:15200673318703120

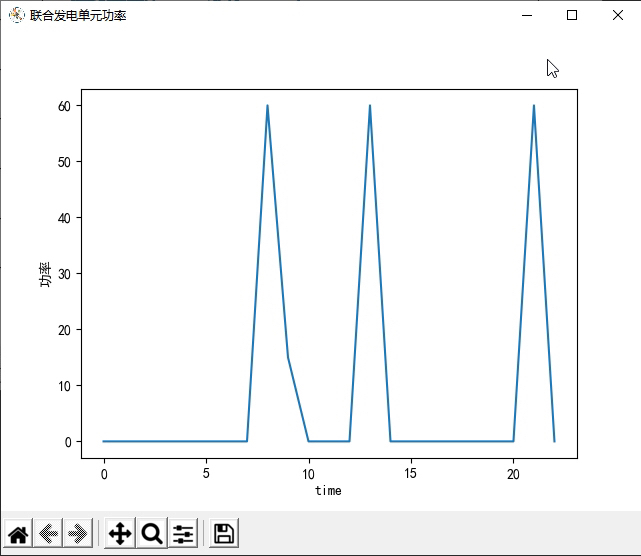

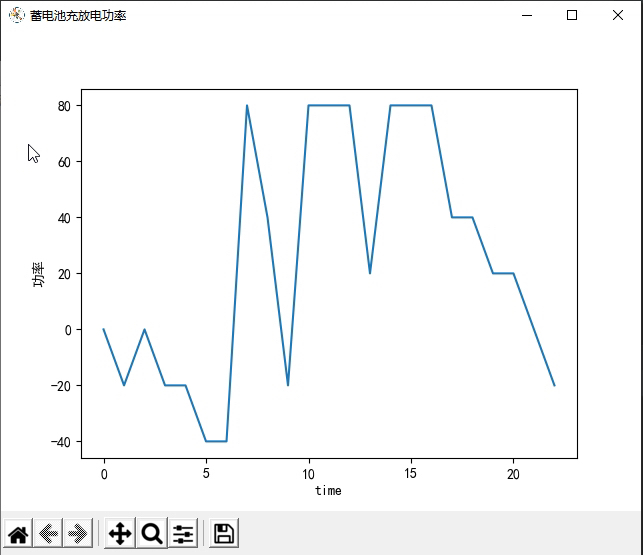

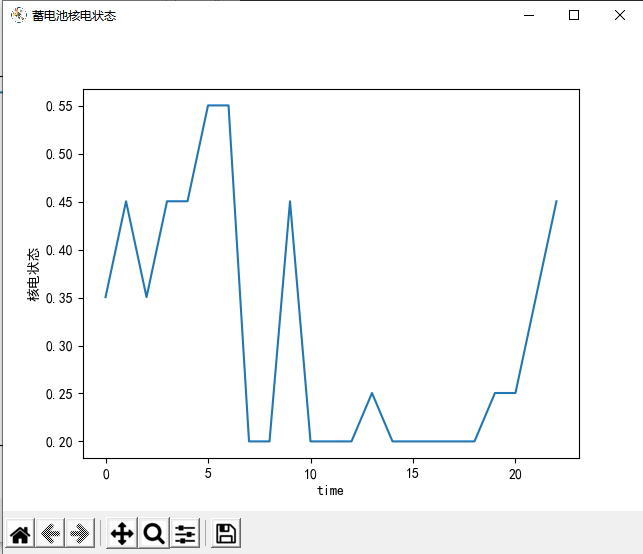

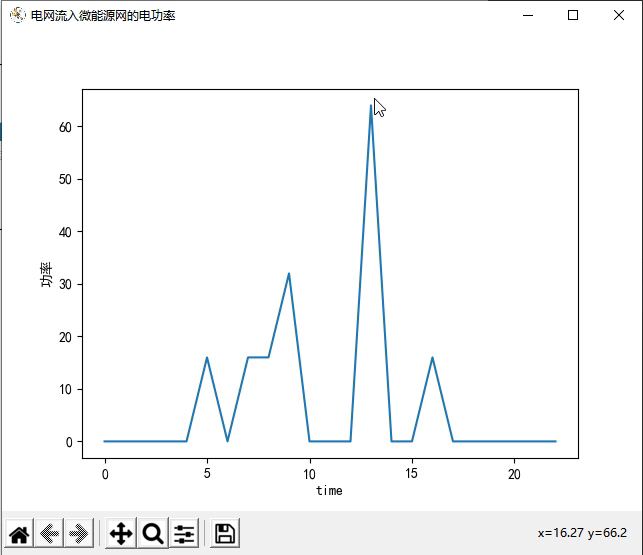

首先,我们来看环境模型部分。这部分代码定义了一个名为NetEnvironment的类,该类表示一个能源系统的环境。在该类的构造函数中,定义了一系列与能源系统相关的参数,如联供发电单元的发电效率、余热回收锅炉的换热效率、换热装置的换热效率等等。还定义了一些与能源系统相关的变量,如光伏的功率输出、风机的功率输出、电负荷、热负荷、冷负荷、电价等等。同时,还定义了一些与环境交互相关的变量,如联合发电单元功率、电网流入微能源网的电功率、蓄电池充放电功率等等。在reset函数中,重置了一些变量的值,以及返回了一个初始的观测值。在get_observation_reward函数中,根据智能体选择的动作,计算了下一个时刻的观测值和奖励值,并返回。在step函数中,根据智能体选择的动作,更新了环境的状态,并返回下一个时刻的观测值、奖励值和是否结束的标志。

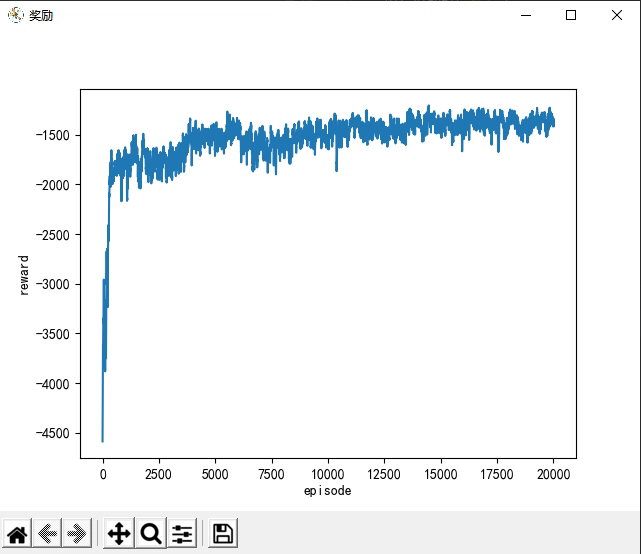

接下来,我们来看智能体模型部分。这部分代码定义了一个名为NetAgent的类,该类表示一个强化学习的智能体。在该类的构造函数中,定义了一系列与强化学习相关的参数,如学习率、折扣因子、贪婪度等等。还定义了一些与智能体训练相关的变量,如记忆库、学习步数等等。在_build_net函数中,构建了两个神经网络,一个用于评估当前状态下的动作价值,一个用于评估下一个状态下的动作价值。在store_transition函数中,将当前状态、动作、奖励和下一个状态存储到记忆库中。在choose_action函数中,根据当前状态选择一个动作,并根据贪婪度随机探索或选择最优动作。在learn函数中,从记忆库中随机采样一批样本,利用目标网络计算下一个状态的动作价值,利用评估网络计算当前状态的动作价值,并更新评估网络的参数。

最后,在主程序中,创建了一个NetEnvironment对象和一个NetAgent对象,并调用policy_train函数进行训练。在policy_train函数中,进行了多个回合的训练,每个回合中,根据当前观测值选择一个动作,与环境交互,更新智能体的参数,并记录奖励值。最后,将奖励值保存到文件中,并绘制了一些图形展示。

这段代码涉及到的知识点主要包括强化学习、神经网络、环境模型和智能体模型等。强化学习是一种通过智能体与环境的交互来学习最优策略的方法。神经网络是一种模拟人脑神经元工作原理的数学模型,用于近似值函数。环境模型是对问题的描述,包括状态空间、动作空间、状态转移函数和奖励函数等。智能体模型是对智能体的描述,包括策略、值函数和学习算法等。

以下是一个符合您要求的Python代码示例:

import numpy as np

import matplotlib.pyplot as plt

class NetEnvironment:

def __init__(self, params):

self.params = params

# 初始化环境参数

self.power_output = 0

self.electric_load = 0

self.heat_load = 0

self.cool_load = 0

self.grid_power = 0

self.battery_power = 0

# ...

def reset(self):

# 重置环境状态

self.power_output = 0

self.electric_load = 0

self.heat_load = 0

self.cool_load = 0

self.grid_power = 0

self.battery_power = 0

# 返回初始观测值

return self._get_observation()

def _get_observation(self):

# 根据环境状态生成观测值

observation = [self.power_output, self.electric_load, self.heat_load, self.cool_load]

return observation

def get_observation_reward(self, action):

# 根据智能体选择的动作计算下一个时刻的观测值和奖励值

# 更新环境状态

# ...

observation = self._get_observation()

reward = 0 # 根据具体情况计算奖励值

done = False # 根据具体情况判断是否结束

return observation, reward, done

def step(self, action):

# 根据智能体选择的动作更新环境状态,并返回下一个时刻的观测值、奖励值和是否结束的标志

observation, reward, done = self.get_observation_reward(action)

return observation, reward, done

class NetAgent:

def __init__(self, params):

self.params = params

# 初始化智能体参数

self.memory = []

self.learn_step = 0

# ...

def _build_net(self):

# 构建神经网络

# ...

def store_transition(self, state, action, reward, next_state):

# 存储样本到记忆库

self.memory.append((state, action, reward, next_state))

def choose_action(self, state):

# 根据当前状态选择动作

# 根据贪婪度随机探索或选择最优动作

action = np.random.choice(self.params['actions'])

return action

def learn(self):

# 从记忆库中随机采样一批样本

# 利用目标网络计算下一个状态的动作价值

# 利用评估网络计算当前状态的动作价值

# 更新评估网络的参数

# ...

def policy_train(env, agent, num_episodes):

rewards = []

for episode in range(num_episodes):

state = env.reset()

total_reward = 0

done = False

while not done:

action = agent.choose_action(state)

next_state, reward, done = env.step(action)

agent.store_transition(state, action, reward, next_state)

state = next_state

total_reward += reward

agent.learn()

rewards.append(total_reward)

# 保存奖励值到文件

np.savetxt('rewards.txt', rewards)

# 绘制奖励曲线

plt.plot(rewards)

plt.xlabel('Episode')

plt.ylabel('Total Reward')

plt.show()

# 创建环境对象和智能体对象

env_params = {'param1': value1, 'param2': value2, ...}

env = NetEnvironment(env_params)

agent_params = {'param1': value1, 'param2': value2, ...}

agent = NetAgent(agent_params)

# 进行训练

num_episodes = 100

policy_train(env, agent, num_episodes)

请注意,上述代码仅为示例,其中的具体实现细节需要根据您的实际需求进行调整和完善。