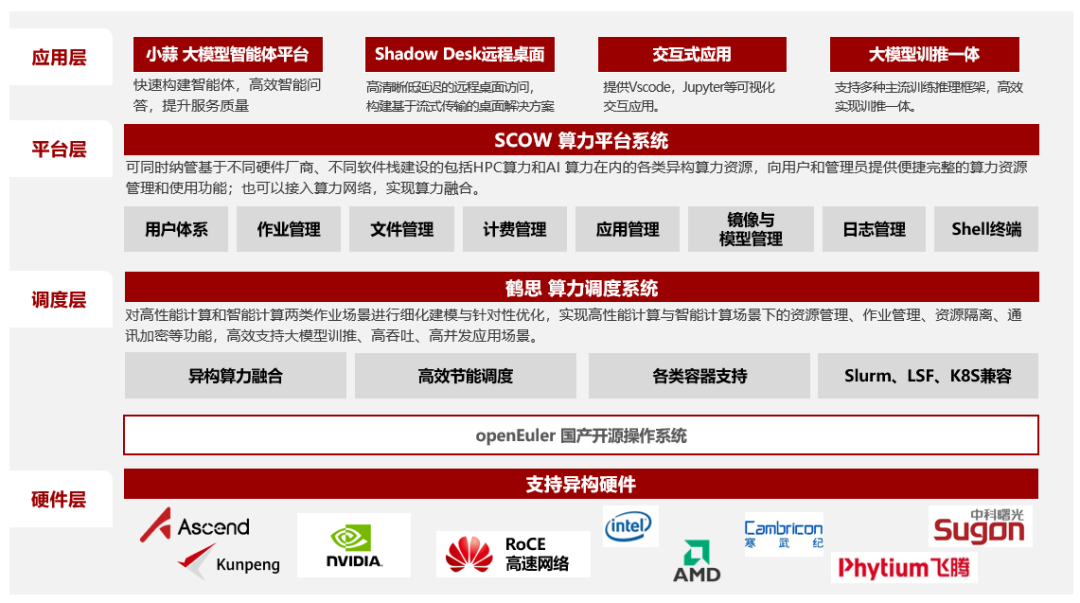

算力与模型的割裂:厂商需为不同硬件重复适配模型,开发成本陡增; 生态孤岛化:各厂商自建技术栈,导致跨平台协作效率低下; 长尾需求难满足:中小开发者受限于算力与框架兼容性,难以复用头部模型能力。

混合专家(MoE)架构的适配性挑战:专家模型与硬件内存存在匹配困境,同时专家负载不均与通信开销过高; 多模型协同与训推一体的系统挑战:多模型动态交互、训推状态切换、资源动态分配引发协同困难,训推一体化软件栈的易用性不足; 长序列推理与稀疏计算的性能挑战:长序列KV Cache存在容量瓶颈;稀疏计算引发的向量化效率下降。

全栈开放 生态共建

北京大学联合OpenAtom openEuler(简称"openEuler") 开源社区与MindSpore社区,推出面向大模型的全栈开源方案,以操作系统+AI框架+模型生态的三层开放架构,替换操作系统和AI框架,秉承代码开源+标准开放+生态共建的理念,逐步成为智能时代的全国产化的数字基座。

1. 对上:兼容多元大模型生态,普惠AI

支持DeepSeek、LLaMA系列等主流模型接入,通过归一化的开源推理软件栈,保证不同模型对资源的动态调配,在生态上做到统一演进,且开箱即优,避免“重复造轮子”; 集成模型微调与蒸馏能力,优化增强RAG流程搭建,结合DeepSeek群体策略优化经验,降低长尾场景定制门槛。

通过硬件抽象层兼容GPU、NPU等芯片,释放DeepSeek低能耗技术红利; 在极致资源约束下,资源动态调度诉求强烈,通过全栈协同优化降低模型资源消耗获得竞争优势。

分层协同 性能提升

通过openEuler、MindSpore与vLLM/RAY等开源组件分层协同,为DeepSeek-R1大模型带来了吞吐性能与易用性的显著提升。核心技术点如下:

openEuler:

1. 异构融合调度:负载感知MoE冷热专家,任务细粒度调度提升推理性能

负载感知的冷热MoE专家动态识别和并行调度,稀疏MoE计算分层细粒度进程拆分,并将相应进程进行多样算力部署;

共享资源细粒度按需控制,支持MoE专家均衡调度,计算/通信细粒度并发;

针对高并发场景下推理服务、分布式计算组件Host侧资源争用的痛点,利用NUMA感知的细粒度算力与内存资源隔离,提升推理整体性能。

2. 异构融合内存:高效管理异构内存,减小系统内存碎片,提升系统推理性能

针对推理服务高并发场景,通过线程特性感知的细粒度内存分配、高性能代码段大页机制,在控制内存开销的同时,提升Host侧性能与整体推理吞吐;

针对MoE架构的稀疏访存特征,通过Host/Device协同内存管理实现多粒度动态混合页与按需内存分配,减少页表访存开销同时提升显存利用效率;

针对大模型推理服务面临的显存容量挑战,基于MoE架构的稀疏计算特征,利用运行时-OS协同设计实现高效专家超分部署,提升显存利用率与整体推理吞吐。

3. 异构融合编译:毕昇编译优化,减少算子下发耗时,提升算子性能

架构亲和编译优化:通过架构亲和的原子指令优化和Malloc、Memcpy高性能库优化,降低各类锁的代价,提高内存利用效率,降低访存开销,进而降低时延,提高吞吐率;算子编译阶段使能智能感知流水优化,基于数据依赖关系深度分析和自适应同步决策机制,自动插入最优同步指令实现高效的多级流水并行;通过昇腾算子抽象层与芯片ISA的智能映射,实现指令级并行优化,极大发挥芯片理论算力; 多维融合算子优化:针对算子下发阶段前端性能瓶颈较高的特点,通过CFGO优化技术,借助运行时信息,编译器进行精准的代码布局优化,有效提高程序IPC,降低算子下发时延;多维融合加速能够自动实现向量类算子融合、矩阵-向量类算子融合,减少数据搬运开销,并通过细粒度并行进一步提升算子性能,快速满足用户验证模型算法和提升模型开箱性能。

MindSpore:

1. 图编译:将模型编译为计算图,通过模式匹配自动将小算子融为大算子

a. 图生成:MindSpore通过JIT编译自动将模型的python类或者函数编译成一张完整的计算图,JIT编译提供了多种方式(ast/bytecode/trace)以满足不同场景的用途,覆盖了绝大部分Python语法。

2. 模型压缩:金箍棒工具,快速定制模型量化推

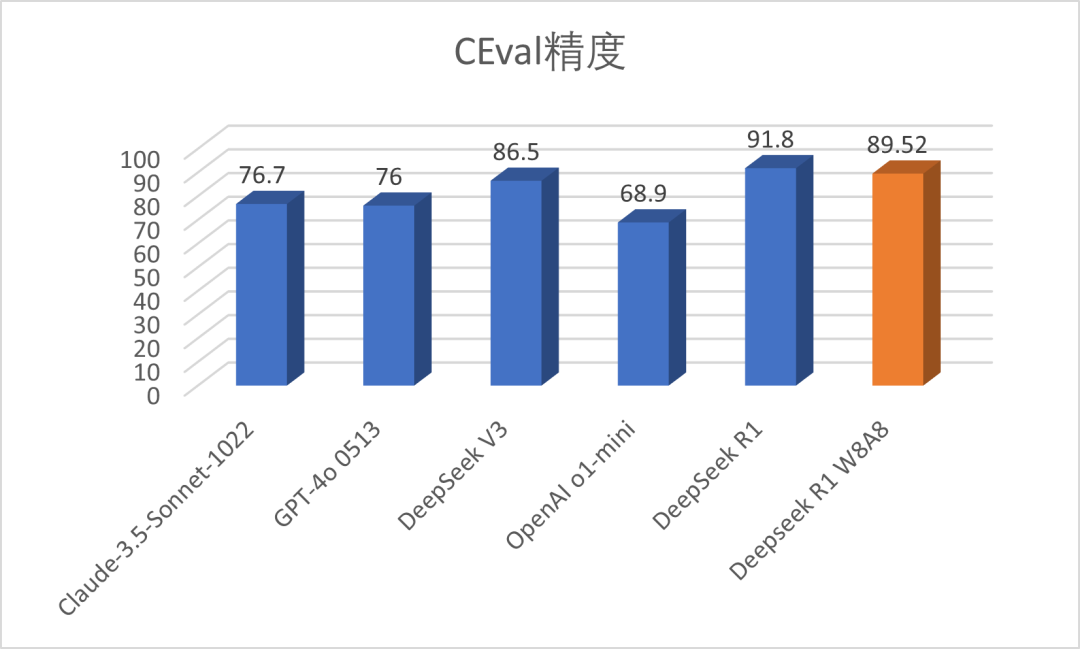

a.8bit权重量化:对 DeepSeek-R1 进行8bit 权重量化,使权重显存占用降为1/2,小batch_size场景推理性能提升明显,但大batch_size场景推理性能变差,分析发现是权重量化矩阵乘算子随着batch_size增大性能会下降。

b.SmoothQuant 8bit量化:为提升大batch_size场景的性能,用SmoothQuant 8bit 全量化,测试发现随batch_size增加,吞吐量线性度良好,但网络量化精度损失仍较大。

c.混合量化:为降量化精度损失,对精度较敏感的FeedForward层用激活动态量化,损失部分性能提升来提升量化精度,MLA层用Outlier-Suppression+异常值抑制算法替代SmoothQuant进一步提升精度。

算力集群的北大方案:

高效部署 开箱即用

北京大学与openEuler及MindSpore社区开发者进行生产环境部署实践

openEuler环境部署

两台Atlas 800I A2(8*64G)。 Ascend HDK Driver 24.1.0版本,Firmware 7.5.0.3.22版本。 openEuler 24.03 LTS版本。

DeepSeek模型下载

Modelers | https://modelers.cn/models/MindSpore-Lab/DeepSeek-R1-W8A8 |

MindSpore一键部署

一键式部署脚本推荐在单独控制的节点执行,控制节点需要可以使用SSH访问各个推理节点。

Step1:下载oedeploy,调整oedeploy配置文件

# 下载插件包并解压wget https://repo.oepkgs.net/openEuler/rpm/openEuler-24.03-LTS/contrib/oedp/plugins/mindspore-deepseek.tar.gztar zxvf mindspore-deepseek.tar.gz# 按照提示调整mindspore-deepseek目录下config.yaml# 下载并安装oedp工具wget https://repo.oepkgs.net/openEuler/rpm/openEuler-24.03-LTS/contrib/oedp/aarch64/Packages/oedp-1.0.0-2.oe2503.aarch64.rpmyum localinstall oedp-1.0.0-2.oe2503.aarch64.rpm复制

Step2:运行一键部署脚本

oedp run install #在mindspore-deepseek目录下运行复制

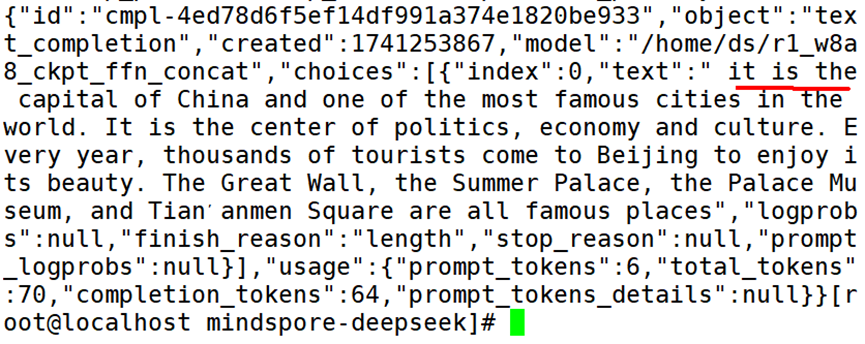

推理服务测试验证

curl http://主节点ip:推理服务端口/v1/completions -H "Content-Type: application/json" -d '{"model": "模型路径", "prompt": "I love Beijing, because", "max_tokens": 32, "temperature": 0, "top_p": 1.0, "top_k": 1, "repetition_penalty":1.0}'复制

返回推理结果示例:

测试结果:基于DeepSeek-R1 W8A8大模型,2台Atlas 800I A2 64GB服务器,128请求吞吐率超过1198token/s,单请求吞吐率可达16.7token/s。

开源方案 优秀实践

高效部署,开箱即用

采用MindSpore与openEuler一键部署脚本,自动完成镜像拉取、集群启动、推理服务拉取等技术。相较于传统手动部署时间通常花费2-3小时,基于当前复杂组网现状,本方案端到端部署时间约20分钟。

未来基于精简组网及内存卸载,一键部署可在单台主机上进行DeepSeek满血部署,部署效率进一步提升。

全栈开放,生态共建

按需量化,动态适配