KDD 2022 | Reliable Representations Make A Stronger Defender: Unsupervised Structure Refinement for Robust GNN

文章信息

「来源」:Proceedings of the 28th ACM SIGKDD Conference on Knowledge Discovery and Data Mining (KDD 2022)

「标题」:Reliable Representations Make A Stronger Defender: Unsupervised Structure Refinement for Robust GNN

「作者」:Li Kuan, Liu Yang, Ao Xiang, Chi Jianfeng, Feng Jinghua, Yang Hao, He Qing

「链接」:https://dl.acm.org/doi/10.1145/3534678.3539484

内容简介

得益于消息传递机制,图神经网络 (GNN) 在图数据上的蓬勃发展任务上取得了成功。然而,最近的研究表明,攻击者可以通过恶意修改图结构来灾难性地降低 GNN 的性能。「解决此问题的解决方案是通过学习两个端节点的成对表示之间的度量函数来对边权重进行建模」,该函数为对抗性边分配低权重。现有方法使用原始特征或 GNN 学习的表示来对边权重进行建模。然而,这两种策略都面临着一些直接的问题:「原始特征不能代表节点的各种属性」(例如,结构信息),而有 GNN 学习的表示可能会受到有噪声图的影响。本文的目标是学习编码特征信息和结构信息,并且对结构扰动不敏感的表示。

为此,本文提出了一个名为 STABLE 的无监督pipeline来优化图结构,最后将精细化的图输入到下游分类器中。对于这一部分,本文设计了一个新的GCN,它在不增加时间复杂度的情况下显着增强了 GCN 的鲁棒性。在四个真实世界图基准上进行的大量实验表明,STABLE 优于最先进的方法并成功防御了各种攻击。

本文的主要贡献有:

提出了一种具有鲁棒性增强的对比方法来获得用于结构细化的表示,该方法可以有效地捕获节点的结构信息并且对扰动不敏感。 本文进一步探讨了 GCN 缺乏鲁棒性的原因,并提出了一种更鲁棒的归一化技巧。 在四个真实世界数据集上进行的大量实验表明,STABLE 可以防御不同类型的对抗性攻击,并优于最先进的防御模型。

方法介绍

整体架构

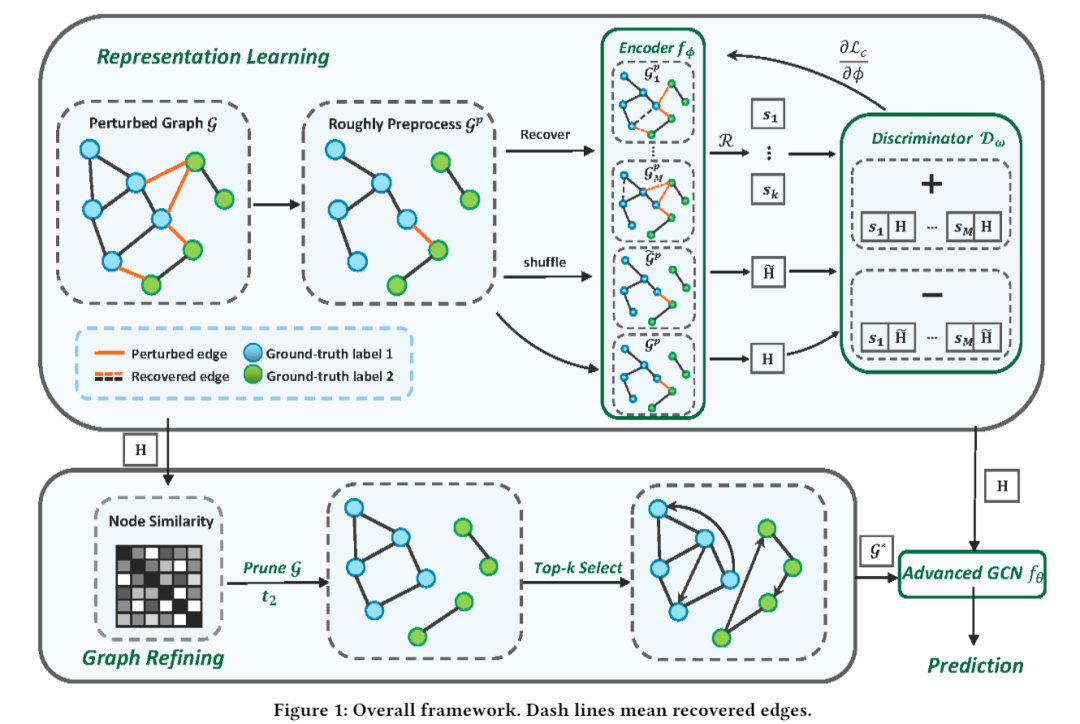

该框架的示意图如下图所示。它由两个主要组件组成,结构学习网络和GCN 分类器。结构学习网络可以进一步分为表示学习和图细化两部分。对于表示学习部分,本文设计了一种新颖的对比学习方法,该方法具有面向鲁棒性的图数据增强,可随机恢复去除的边。然后根据同质假设利用学习的表示来修改结构。最后,在分类步骤中,通过观察对抗性边连接的节点具有哪些属性,本文仔细改变了 GCN 中的重整化技巧以提高鲁棒性。

表征学习

「预处理」STABLE 通过利用与任务无关的对比方法和面向鲁棒性的增强来学习表示,从而避免前面提到缺陷。首先,本文基于相似性度量对扰动图进行粗略的预处理,例如 Jaccard 相似性或余弦相似性。本文量化节点 与其邻居 之间的分数 如下:

其中S是分数矩阵,和分别是和的特征向量。

「生成视图」生成视图是对比方法的关键组成部分。图的不同视图为每个节点提供不同的上下文,本文希望文中的视图携带上下文以增强表示的鲁棒性。本文通过在预处理图 上随机恢复 的一小部分来生成 视图,表示为 到 。形式上,首先对随机掩蔽矩阵 进行采样,如果 和 ,则其条目来自伯努利分布。这里𝑝是一个控制恢复率的超参数。增强视图的邻接矩阵可以计算为:

其中 和 分别表示 和 的邻接矩阵。

「编码器传播规则」编码器遵循传播规则为:

「全局平均池化函数」本文利用的全局平均池化函数为:

图细化

一旦准备好高质量的表示,本文就可以中进一步细化图结构。现有文献认为,底层图的强同质性可以帮助 GNN 在转导节点分类方面取得良好的性能。因此,细化的目标是减少异性边(连接不同类中的两个节点)并添加同性边(连接同一类中的两个节点)。在同质性假设下,相似的节点更有可能在同一类中,因此本文使用节点相似性来搜索潜在的同质边和异质边。

本文利用对比学习编码器学习的表示来测量节点相似度:

其中 是相似度得分矩阵, 是节点 和节点 的得分。本文这里利用余弦相似度。然后删除所有连接相似度分数低于阈值 的节点的边。上述过程可以表述为:

其中 是剪枝后的邻接矩阵。

根据本文的经验结果,当扰动率很高时,这尤其有效。最优邻接矩阵可以表示为:

实验分析

「数据集」本文在四个基准数据集上进行实验,包括三个引文图,即Cora、Citeseer 和 PubMed,以及一个博客图,即 Polblogs。

「基线」本文将 STABLE 与具有代表性和最先进的防御 GNN 进行比较,以验证鲁棒性。基线和 SOTA 方法是 GCN、RGCN、Jaccard、GNNGuard、GRCN、ProGNN、SimpGCN、Elastic。本文实现了三种非目标结构对抗攻击方法,即 MetaAttack、DICE 和 Random。

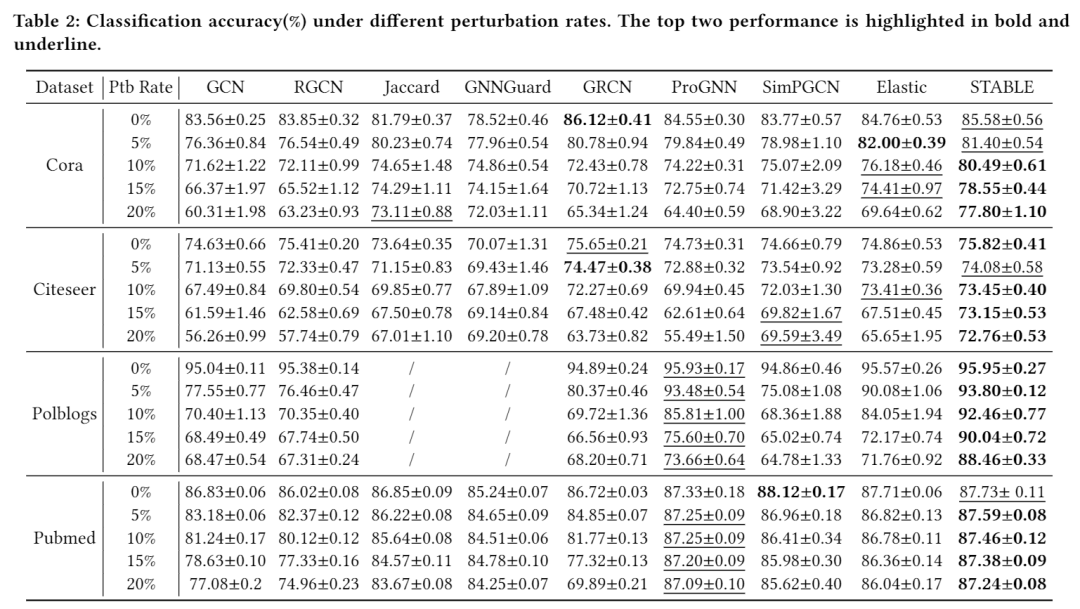

「鲁棒性评估」下表显示了针对 MetaAttack 的三个数据集的性能,这是一种有效的攻击方法。前两个性能以粗体和下划线突出显示。本文将扰动率设置为 0% 到 20%。从这个主要实验中,可以观察到:所有方法都在干净图上执行得很好,因为它们中的大多数都是为对抗性攻击而设计的,而在干净图上的性能是他们的目标。GCN 和 RGCN 在有扰动的图上表现不佳,证明 GNN 在没有有效防御的情况下很容易受到攻击。在不同的扰动率下,STABLE 优于其他方法。随着扰动率的增加,所有数据集的性能缓慢下降,这表明 STABLE 对扰动不敏感。

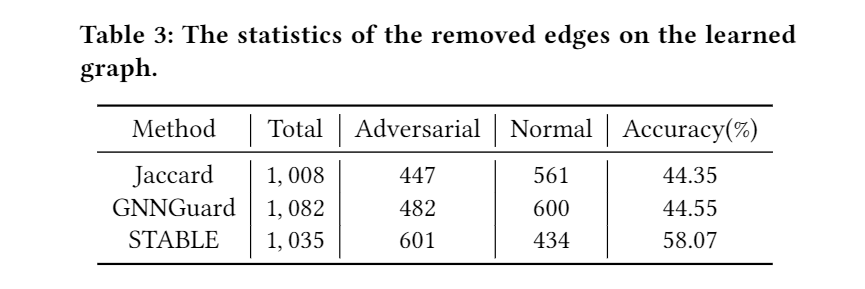

「结构学习的结果」为了验证结构学习的有效性,本文比较了 STABLE 和其他度量学习方法中结构优化的结果。学习图的统计数据如下表所示,它显示了总删除边、删除对抗边和删除正常边的数量。为了确保公平比较,本文调整了每种方法中的修剪阈值以接近总移除边的数量。可以观察到,STABLE 实现了最高的剪枝精度,表明 STABLE 通过更可靠的表示更精确地修改了结构。

结论

为了克服 GNN 的脆弱性,本文提出了一种新的防御模型 STABLE,它通过更可靠的表示成功地改进了图结构。此外,本文设计了一个先进的 GCN 作为下游分类器,以增强 GCN 的鲁棒性。实验表明,STABLE 始终优于最先进的基线,并且可以防御不同类型的攻击。对于未来的工作,本文的目标是探索表征学习。在对抗性攻击场景中,STABLE 的有效性证明了鲁棒性的表示可能是 GNN 鲁棒性的关键。