大家好,我是杰哥。

【AI信息风向】每天早上 7点准时推送的 AI 资讯中,总是会出现一些 AI 大模型的术语,阻碍了我们的理解。那么今天就开始,为你进行一波 AI 大模型常见名词的扫盲,从而让你更容易看懂每日 AI 资讯,同时更加系统地了解 AI 大模型。

1. 什么是 Token?

在大语言模型(LLM)如 GPT-4o 中,文本的处理过程通常包括将输入文本转换成一系列 tokens,这些 tokens 是模型理解语言的基础。这个过程称为 tokenization(分词),不同的模型可能使用不同的方法来分词。以下是使用 GPT-4o 模型时的一个例子:

假设我们有以下句子:

"Hello, how are you doing today?"

在使用 GPT-4o 模型之前,这个句子需要被 分词。在 GPT-4o 中,这个句子可能会被分词为以下 tokens 序列:

["Hello", ",", "how", "are", "you", "doing", "today", "?"]

在这个例子中,每个单词和标点符号都被当作一个单独的 token。注意,根据模型的具体实现,分词方式可能略有不同。例如,一些模型可能会将标点符号和它所附着的单词合并为一个 token,如将", "(逗号和一个空格)与"Hello"合并为"Hello,"。

对于中文文本,分词过程可能会更加复杂,因为中文文本没有明显的单词分隔符。例如,中文句子:

"你今天怎么样?"

在使用 GPT-4o 模型时,这个句子可能会被分词为:

["你", "今天", "怎么", "样", "?"]

在这个例子中,每个汉字都被单独作为一个 token。但是,实际的分词可能会根据模型的分词器和训练数据而有所不同。

重要的是,tokenization 是自然语言处理(NLP)任务中的一个关键步骤,它直接影响模型对文本的理解和处理能力。因此,开发者在使用 LLM 时需要确保文本被正确地分词,以便模型能够准确地进行预测和生成。

2. 什么是 Prompt?

Prompt 中文意思是“提示词”。它是给大模型的指令,是一个简短的文本输入,用于引导 AI 模型生成特定的回答或执行特定任务。

在人工智能领域,尤其是在自然语言处理(NLP)中,Prompt(提示)是一种向模型提供信息的方式,用以指导模型完成特定任务或生成特定类型的输出。简单来说,Prompt 是给模型的输入,它告诉模型需要做什么或者如何回应。

Prompt 的设计对于模型的输出质量至关重要。一个好的 Prompt 可以引导模型生成准确、相关且有用的回答。在实际应用中,设计有效的 Prompt 往往需要针对特定任务进行调整和优化。

3、什么是 LLM?

大语言模型(Large Language Models,简称 LLMs)是一类具有大量参数的机器学习模型,它们专门设计用来处理和生成人类语言。这些模型通过在大量的文本数据上进行训练,学习语言的语法、语义和上下文关系,从而能够执行各种复杂的自然语言处理(NLP)任务,如文本生成、翻译、摘要、问答等。

举个例子

GPT-4o:是 OpenAI 公司于 2024 年 5 月 14 日 推出的一款超级智能语言模型,这个 AI 模型功能强大,能同时处理文本、声音和图像,支持多达 50 种语言。它反应迅速,接近人类反应时间,平均 320 毫秒,并且能够理解情绪。

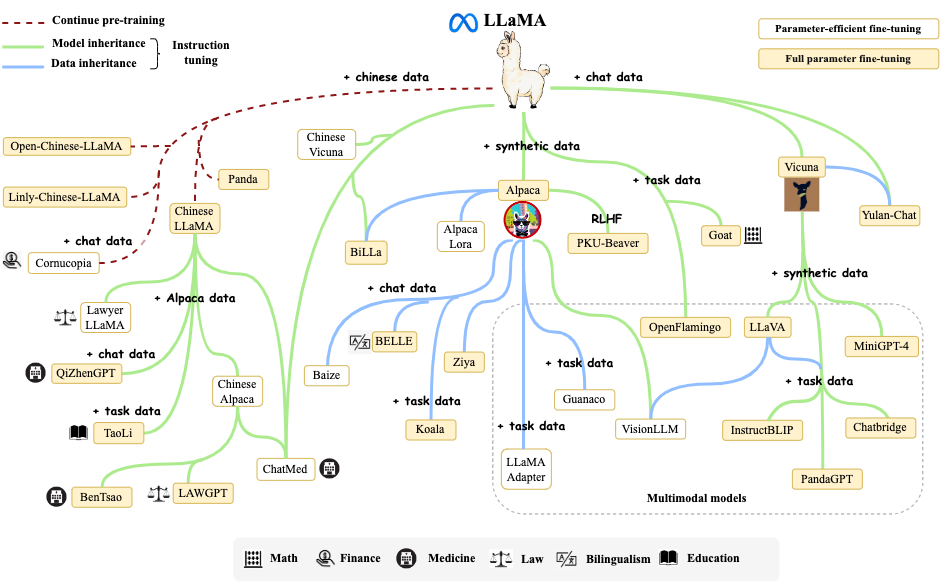

Llama 3.1 是 Meta(Facebook 的母公司)推出的一系列模型,包括不同规模的版本,如 405B、70B 和 8B 参数的模型。这些模型支持长上下文能力(最长 128K tokens),多语言支持,并且具有工具使用功能。

Claude 3.5 Sonnet:是 Anthropic 公司推出的模型,它在多项评估中表现出色,具有先进的视觉能力,并且在速度和成本方面具有优势。这个模型特别适合于需要视觉理解的任务,如解释图表和图形。

大语言模型由于其强大的语言理解和生成能力,正在成为人工智能领域的重要工具,被应用于聊天机器人、内容创作、自动摘要、机器翻译等多个场景。

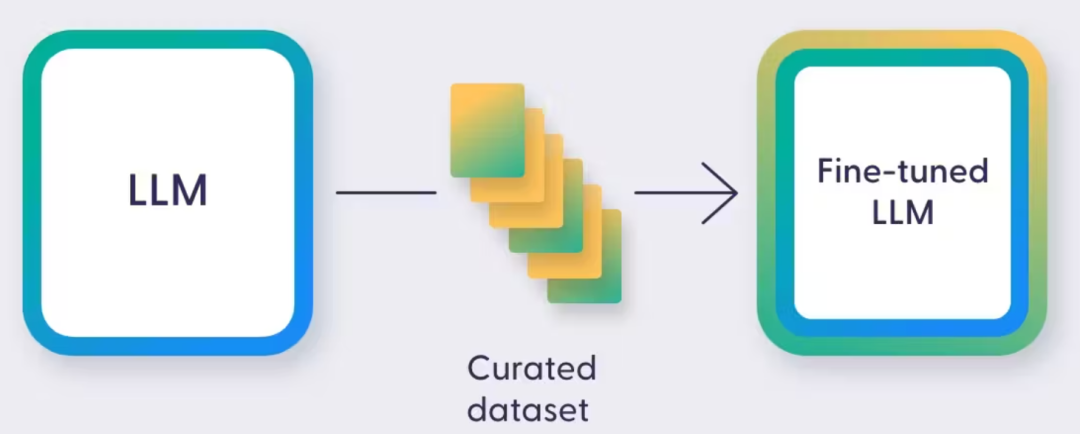

4、什么是微调?

什么是微调?

微调(Fine-tuning)是一个过程,通过这个过程,我们用新增的数据对已经预训练好的语言模型进行进一步的训练。让模型更好地学习并模仿微调数据集中的特定模式和特征,从而适应各种特定的任务和需求。通过微调,可以使语言模型更好地适应特定的领域、任务或写作风格。

比如说,你有一个 AI 模型,它已经能够识别猫和狗。但如果你想要它识别出特定品种的猫,比如暹罗猫,这时候就需要微调了。通过使用暹罗猫的图片进行微调,模型就能学会识别这种猫的独特特征。

微调的好处

节省资源:微调不需要从头开始训练模型,大大减少了计算资源和时间的消耗。 提高效率:它帮助模型更快地适应新任务,提升了工作效率。 增强适应性:微调后的模型能够更准确地处理特定场景或数据,提高了其实用性。

微调的艺术

微调的过程需要谨慎选择数据,因为这些数据将直接影响模型的性能和可能产生的偏差。就像为咖啡机选择合适的咖啡豆,微调所用的数据质量决定了最终的效果。

微调不仅仅是技术的调整,它是 AI 模型个性化成长的过程。通过微调,我们让 AI 模型变得更加精准和高效,就像那些学习新语言的人,不断进步,不断适应新的挑战。微调后的AI,就像一杯为你量身定制的咖啡,完美符合你的期待。

5、什么是 RAG?

什么是 RAG?

检索增强生成(RAG)技术将信息检索与语言模型生成相结合,旨在提升生成文本的准确度和相关性,并确保模型的回应有充分的证据支持。

简单来说,RAG 是一种人工智能技术,它结合了“检索”和“生成”两种方式,让机器能够更好地理解和回应你的问题。就像是你在学习时,先从书本中找到相关知识,然后再用自己的话来回答问题。

通过这种方式,语言模型得以利用外部知识库或文档集,这部分信息会被加入到模型的上下文窗口中。当有查询请求发送给模型时,系统会在运行时从这些外部资源中检索所需数据,尽管模型本身可能不直接执行检索动作(但它可以通过工具使用功能和一个检索函数来完成这一任务)。

RAG 的工作原理

RAG的工作原理可以分为两步:

第一步:检索(Retrieval):机器从大量的信息中检索出与问题相关的资料。 第二步:生成(Generation):机器利用检索到的信息,生成一个准确且自然的回答。

RAG 的实际应用

让我们来看一个例子:假设你问 AI:“世界上最深的海沟是哪个?”AI 首先会从它的知识库中检索相关信息,然后生成答案:“世界上最深的海沟是马里亚纳海沟。”

这个过程中,RAG 技术让AI不仅能够找到正确答案,还能以一种自然的方式表达出来,就像人类之间的对话一样。

RAG 的优势

更准确的回答:RAG通过检索相关信息,提高了回答的准确性。 更自然的语言:生成的回答更接近人类的语言习惯。 持续学习:随着知识库的不断更新,AI的回答也会越来越精准。

RAG 的未来

随着技术的不断发展,RAG 将在更多领域发挥作用,比如智能客服、在线教育、健康咨询等。它将帮助机器更好地理解人类的需求,提供更优质的服务。

RAG 技术让人工智能的“阅读理解”能力更上一层楼,未来,它将在我们的生活中扮演越来越重要的角色。让我们一起期待,AI带来的更多惊喜和便利。