1.ShuffleManager

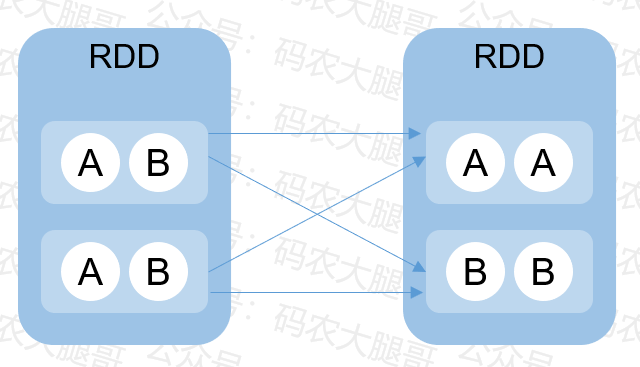

hashShuffleManager

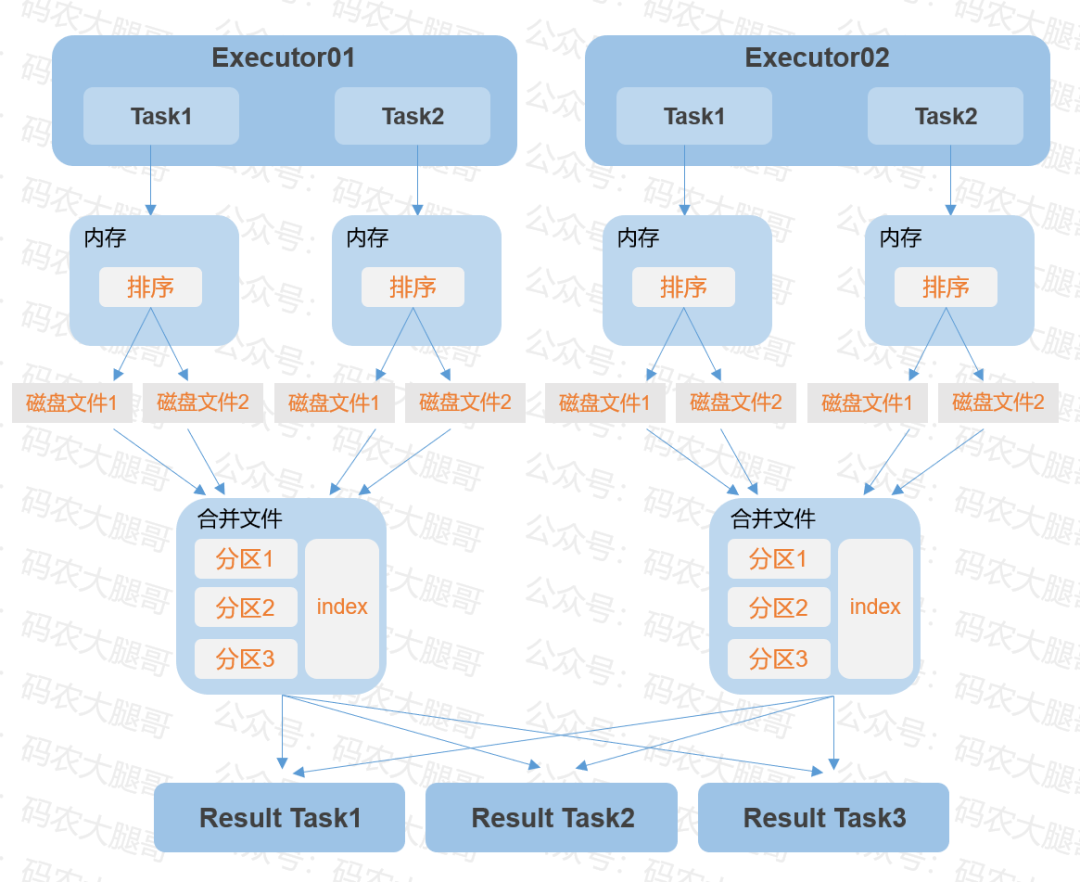

sortShuffleManager

UnsafeShuffleWriter

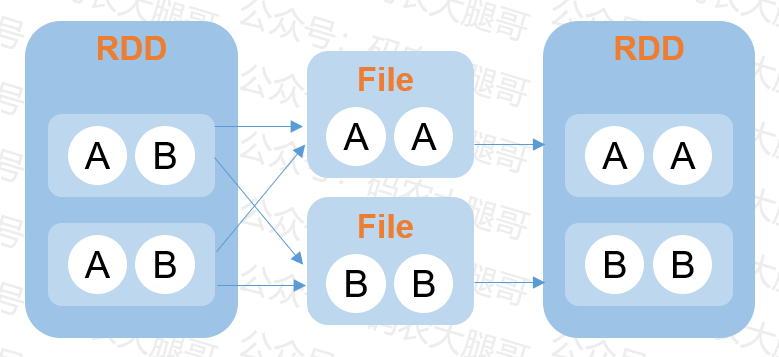

BypassMergeSortShuffleWriter

SortShuffleWriter

Result Task通过请求 Driver 端的 MapOutputTrackerMaster 询问输出的数据位置

3)aggregate

shuffle Result Task的数量小于默认值200

不是聚合类的shuffle算子

文章转载自码农大腿哥,如果涉嫌侵权,请发送邮件至:contact@modb.pro进行举报,并提供相关证据,一经查实,墨天轮将立刻删除相关内容。

评论

相关阅读

2025年4月中国数据库流行度排行榜:OB高分复登顶,崖山稳驭撼十强

墨天轮编辑部

2327次阅读

2025-04-09 15:33:27

数据库国产化替代深化:DBA的机遇与挑战

代晓磊

1074次阅读

2025-04-27 16:53:22

2025年3月国产数据库中标情况一览:TDSQL大单622万、GaussDB大单581万……

通讯员

669次阅读

2025-04-10 15:35:48

数据库,没有关税却有壁垒

多明戈教你玩狼人杀

538次阅读

2025-04-11 09:38:42

国产数据库需要扩大场景覆盖面才能在竞争中更有优势

白鳝的洞穴

515次阅读

2025-04-14 09:40:20

最近我为什么不写评论国产数据库的文章了

白鳝的洞穴

475次阅读

2025-04-07 09:44:54

【活动】分享你的压箱底干货文档,三篇解锁进阶奖励!

墨天轮编辑部

430次阅读

2025-04-17 17:02:24

2025年4月国产数据库中标情况一览:4个千万元级项目,GaussDB与OceanBase大放异彩!

通讯员

427次阅读

2025-04-30 15:24:06

天津市政府数据库框采结果公布,7家数据库产品入选!

通讯员

407次阅读

2025-04-10 12:32:35

优炫数据库成功入围新疆维吾尔自治区行政事业单位数据库2025年框架协议采购!

优炫软件

349次阅读

2025-04-18 10:01:22